NVIDIA przedstawiła nowości z obszaru AI i HPC.

NVIDIA przedstawia nową technologię przyspieszającą sztuczną inteligencję i wyznacza trendy w budowie superkomputerów.

Podczas GTC 2022 NVIDIA ogłosiła nowe technologie, które, jak twierdzi, zwiększą prędkość obliczeniową dla coraz bardziej skomplikowanych algorytmów sztucznej inteligencji. Firma przedstawiła też szczegóły dotyczące nowych układów graficznych, które będą stanowić rdzeń infrastruktury budowanej dla AI.

NVIDIA zapowiedziała gamę produktów napędzanych przez zupełnie nowe układy graficzne Hopper GH100, takie jak DGX H100, DGX SuperPod i kilka różnych akceleratorów H100 PCIe. NVIDIA DGX H100 są skierowane na rynek centrów danych skupionych na sztucznej inteligencji, przyspieszając uczenie maszynowe i wydajność analizy danych w biurach korporacyjnych, ośrodkach badawczych, laboratoriach lub biurach domowych na całym świecie.

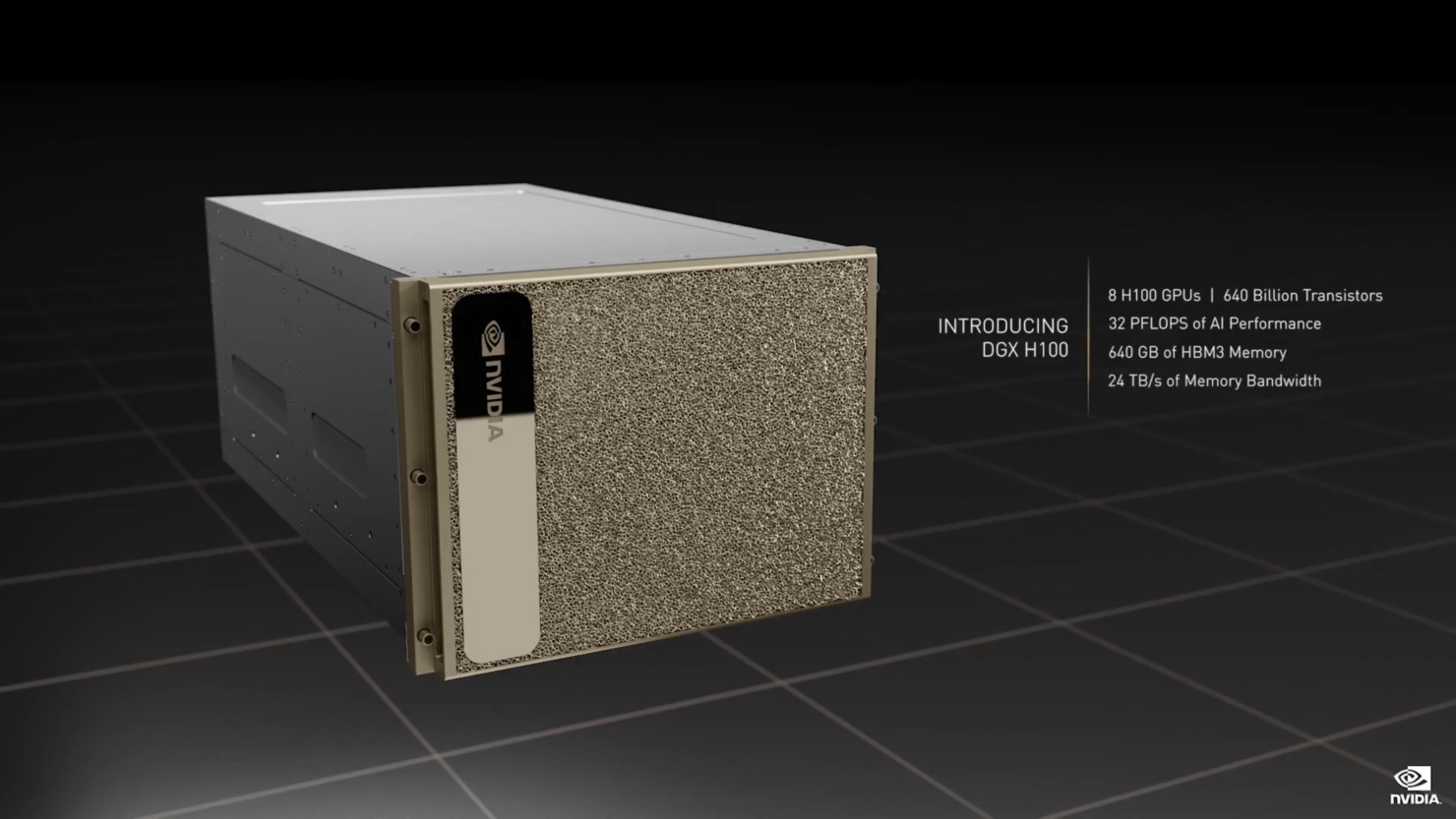

Potęga wydajności w niepozornej “kostce” – DGX H100

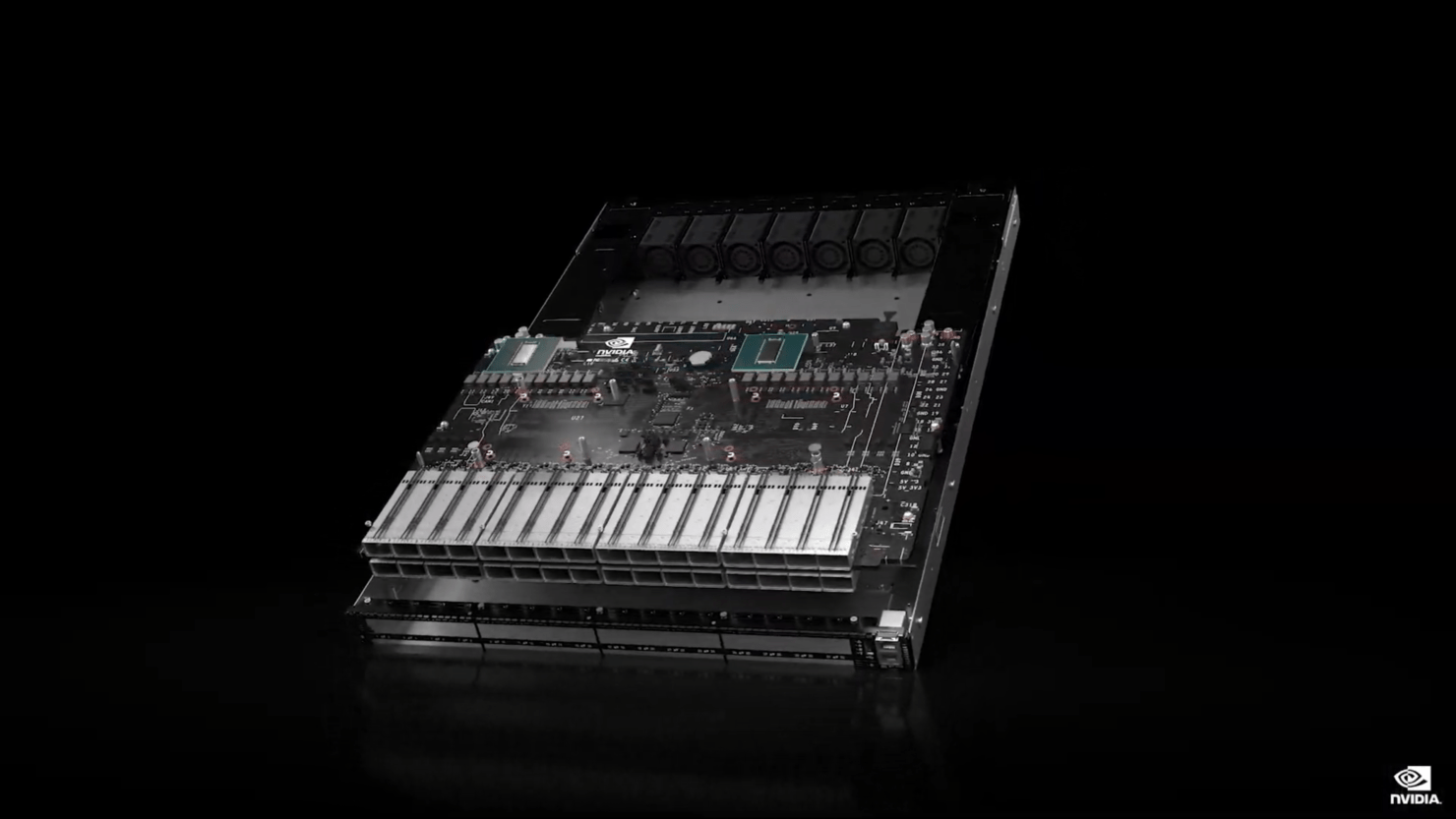

Wraz z GPU Hopper, NVIDIA wprowadza na rynek swój najnowszy komputer DGX H100. System jest wyposażony łącznie w 8 akceleratorów H100 w konfiguracji SXM i oferuje do 640 GB pamięci HBM3 oraz do 32 PFLOP szczytowej wydajności obliczeniowej. Dla porównania, istniejący na rynku komputer o tym samym zastosowaniu, bezpośredni poprzednik nowej maszyny, NVIDIA DGX A100, jest wyposażony w 8 procesorów graficznych A100 z 640 GB pamięci HBM2e i dysponuje maksymalnie 5 PFLOP mocy obliczeniowej dla AI i 10 PFLOP mocy obliczeniowej INT8.

Sam system zawiera procesory Intel z pełną obsługą PCIe Gen 5. Wyjście obrazu jest zapewniane przez oddzielną kartę DGX Display Adapter, która oferuje 4 wyjścia DisplayPort z obsługą rozdzielczości do 4K. System jest wyposażony w cztery przełączniki NVSwitch, 2 TB pamięci systemowej, dwie pamięci masowej NVMe M.2 o pojemności 1,9 TB dla systemu operacyjnego oraz 8 dysków SSD NVMe U.2 o pojemności 3,84 TB do pamięci wewnętrznej. DGX H100 zawiera procesory graficzne H100 z tyłu obudowy. Wszystkie cztery procesory graficzne i CPU są chłodzone przez zunifikowany system chłodzenia czynnikiem chłodniczym. Kompresor chłodnicy znajduje się w podwoziu DGX. Pobór mocy jest oceniany na 10,2 kW (szczyt).

Superkomputery w służbie AI

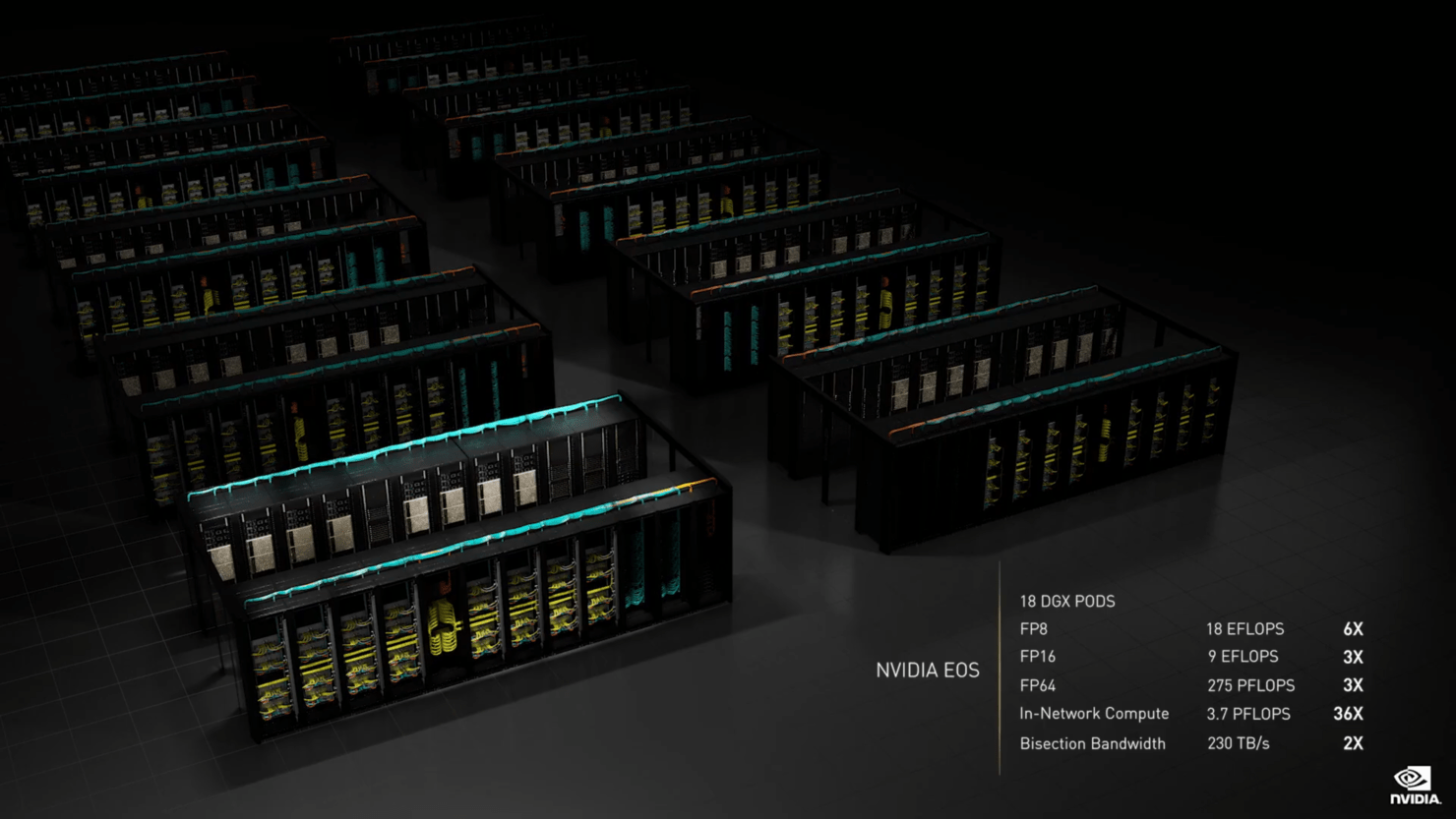

NVIDIA ogłosiła także dwie platformy superkomputerowe (klastry korzystające z komputerów DGX H100): POD i EOS. DGX POD oferuje wydajność 1 eksaflopa (EFLOP) dla sztucznej inteligencji, ma 20 TB pamięci HBM3, 192 TFLOPS obliczeń w sieci SHARP i 70 TB/s przepustowości dwukierunkowej. Przełącznik DGX POD NVLINK obsługuje 20,5 TB całkowitej pamięci HBM3 i 786 TB/s całkowitej przepustowości pamięci systemowej.

Oczekuje się, że jego superkomputer EOS będzie najszybszym na świecie systemem AI po tym, jak zacznie działać jeszcze w tym roku, obejmującym łącznie 576 systemów DGX H100 z 4608 procesorami graficznymi DGX H100. EOS osiągać ma 18,4 EFLOP w FP8 (czterokrotnie szybsze przetwarzanie AI niż superkomputer Fugaku w Japonii, który jest obecnie najszybszym na świecie), 9 EFLOP w FP16, 275 PFLOP w FP64, 3,7 PFLOP w obliczeniach w sieci i przepustowość 230 TB/s. System został zaprojektowany z nowym przełącznikiem Quantum-2 Infiniband, który zawiera 57 miliardów tranzystorów i 32-krotne akceleratory AI w systemach A100.

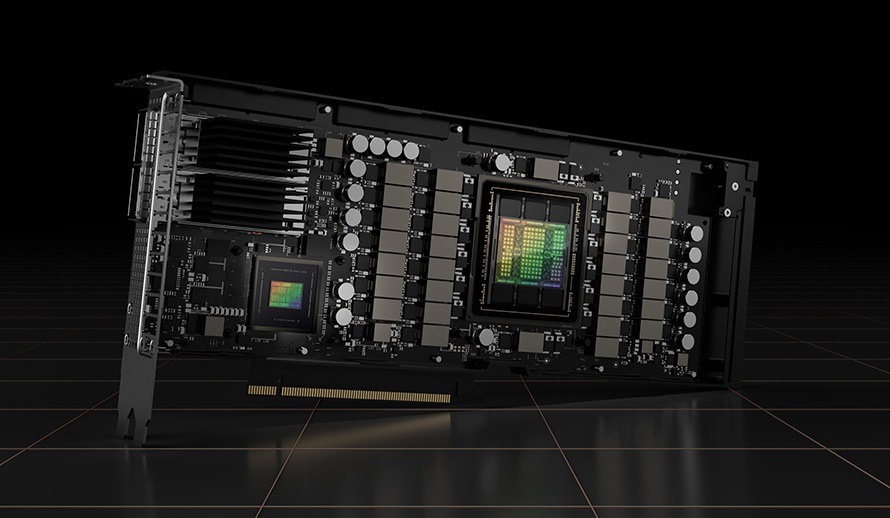

H100 PCIe

Na koniec – nowy akcelerator H100 PCIe. W przeciwieństwie do konfiguracji H100 SXM5, H100 PCIe oferuje nieco okrojone specyfikacje, włączając w to 114 SM z pełnych 144 SM GPU GH100 i 132 SM w H100 SXM. Układ jako taki oferuje 3200 FP8, 1600 TF16, 800 FP32 i 48 TFLOP mocy obliczeniowej FP64. Zawiera również 456 jednostek tensor i teksturowania. Ze względu na niższą szczytową moc obliczeniową, H100 PCIe powinien działać przy niższych taktowaniach i jako taki charakteryzuje się rozsądniejszym TDP wynoszącym 350 W w porównaniu z 700 W TDP wariantu SXM5. Jednak karta PCIe zachowa 80 GB pamięci HBM2e obsługiwanej przez interfejs magistrali 5120-bit.

“Fabryki sztucznej inteligencji”

„Centra danych stają się fabrykami sztucznej inteligencji — przetwarzają i uszlachetniają góry danych w celu uzyskania inteligencji” — powiedział Jensen Huang, CEO NVIDII, podczas internetowej konferencji, nazywając chip H100 „silnikiem” infrastruktury sztucznej inteligencji. NVIDIA twierdzi, prawdopodobnie nie mijając się z prawdą, że nowe technologie wspólnie pomogą skrócić czas obliczeń z tygodni do dni w przypadku niektórych prac związanych z trenowaniem modeli sztucznej inteligencji.

Colette Kress, dyrektorka finansowa NVIDII, powiedziała, że wraz z nowymi chipami, które popychają do przodu obliczenia sztucznej inteligencji, możliwości rynkowe firmy wynoszą około biliona dolarów.

GSMA świętuje kolejną edycję MWC 2022 na żywo w Barcelonie i przedstawia wydarzenie w liczbach.