Google prezentuje superkomputer A3 zdolny do pomieszczenia do 26 000 układów graficznych Nvidia H100

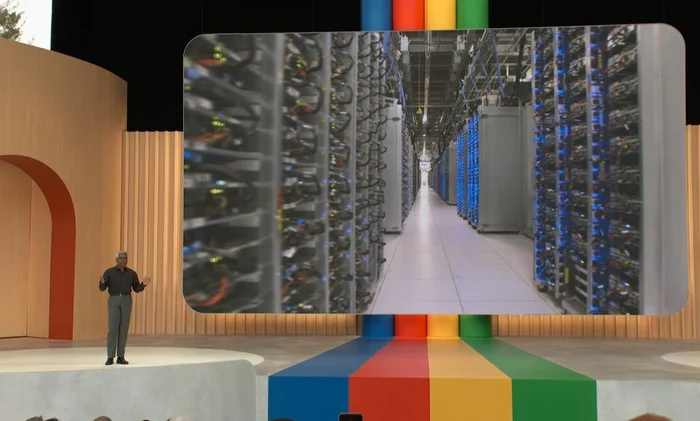

Przy pełnej specyfikacji, superkomputer A3 jest w stanie osiągnąć do 26 eksaflopsów wydajności AI. System nie znajduje się w jednym centrum danych, ale jest połączeniem zasobów wielu ośrodków.

Pojedyncza maszyna wirtualna A3 wyposażona jest w osiem układów graficznych H100, zapewniających przepustowość 3,6 TB/s w układzie dwusekcyjnym dzięki Nvidia NVSwitch i NVLink 4.0, procesory Intel Xeon Scalable 4. generacji oraz 2 TB pamięci hosta dzięki modułom DDR5 DIMM 4800 MHz.

Jest to również pierwsza instancja wykorzystująca niestandardową jednostkę Intel Infrastructure Processing Unit (IPU) Google’a, która według firmy pozwala na 10-krotne zwiększenie przepustowości sieci w stosunku do maszyn wirtualnych A2.

“Maszyny wirtualne A3 w chmurze Google Cloud, napędzane przez układy graficzne nowej generacji Nvidia H100, przyspieszą szkolenie i obsługę generatywnych aplikacji AI”, powiedział Ian Buck, wiceprezes działu hiperskali i obliczeń o wysokiej wydajności w firmie Nvidia.

“Po uruchomieniu niedawno przez Google Cloud instancji G2, jesteśmy dumni, że możemy kontynuować naszą współpracę z Google Cloud, aby pomóc przekształcać przedsiębiorstwa na całym świecie za pomocą specjalnie zbudowanej infrastruktury AI”.

Google oświadczyło, że instancje zostały zaprojektowane z myślą o treningu AI. “Biorąc pod uwagę wymagania tych obciążeń roboczych, podejście typu “one-size-fits-all” nie jest wystarczającym rozwiązaniem – potrzebujesz infrastruktury, która jest specjalnie zbudowana dla AI” – powiedzieli Roy Kim i Chris Kleban z Google Cloud we wpisie na blogu.

Firma oferuje również własne układy TPU w chmurze, jednakże to układy graficzne firmy Nvidia zdobyły większość rynku generatywnej sztucznej inteligencji.