IBM zaczyna w praktyce stosować swój 127-kubitowy procesor kwantowy Eagle

Zespół IBM we współpracy z Uniwersytetem Kalifornijskim w Berkeley i Uniwersytetem Purdue osiągnął postęp w dziedzinie komputerów kwantowych.

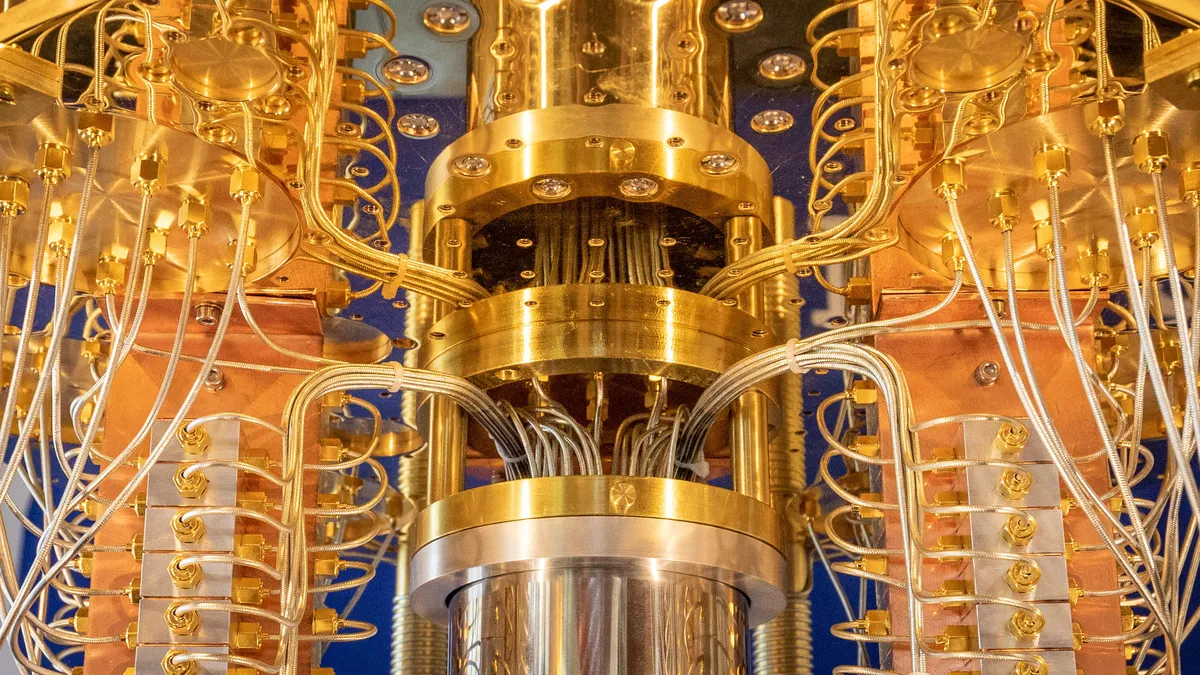

Udało im się uzyskać użyteczne wyniki obliczeń na jednym z obecnych komputerów NISQ (Noisy Intermediate Scale Quantum). Wykorzystali jednostkę przetwarzającą kwanty IBM o nazwie Eagle, aby wykonać obliczenia, które pierwotnie miały zakończyć się niepowodzeniem z powodu szumu ang.noise związanego z kubitami. Jednak dzięki sprytnemu mechanizmowi sprzężenia pomiędzy 127-kubitowym QPU Eagle od IBM a superkomputerami z Uniwersytetu Kalifornijskiego w Berkeley i Uniwersytetu Purdue, udało się uzyskać użyteczne wyniki z nieprecyzyjnego QPU.

Komputery kwantowe z NISQ zostały połączone ze standardowymi superkomputerami – najpotężniejszymi maszynami znanych ludzkości, zdolnymi do wykonywania bilionów operacji na sekundę. Pomimo ich mocy obliczeniowej prawda jest taka, że gdy dwa podmioty są ze sobą powiązane, poruszają się tylko tak szybko, jak na to pozwala najwolniejszy z nich. Superkomputer już był mocno obciążony podczas tego eksperymentu i ledwo co nadążał za komputerem kwantowym.

Gdy symulacja kubitów stała się zbyt skomplikowana dla superkomputera, aby po prostu metodą “brute force” uzyskać wyniki, badacze z Uniwersytetu Kalifornijskiego w Berkeley skorzystali z algorytmów kompresji – stanów sieci tensorowych. Te stany sieci tensorowych (macierze) to w zasadzie kostki danych, w których liczby stanowiące obliczenia są reprezentowane w trójwymiarowej przestrzeni (x, y, z), która jest zdolna do obsługi bardziej złożonych relacji i woluminów informacyjnych niż standardowe rozwiązanie 2D – dla zobrazowania pomyśl o prostym arkuszu kalkulacyjnym Excel 2D (x, y) i liczbie wierszy, przez które musiałbyś przeszukiwać w tej konfiguracji, jeśli musiałbyś uwzględnić dodatkową płaszczyznę informacji (z).

Oznacza to, że już teraz można wydobyć pewne korzyści z komputerów kwantowych NISQ – istnieją obszary, w których mogą one dostarczać wyniki, które byłyby poza zasięgiem – przynajmniej jeśli chodzi o czas i koszty – dla standardowych superkomputerów, lub w których trudności związane z uzyskaniem tych wyników byłyby większe niż zysk. Obecnie następuje symbioza rozwiązań między komputerami kwantowymi NISQ z kilkuset kubitami (najwyżej) a standardowymi superkomputerami z bilionami tranzystorów. W miarę wzrostu liczby dostępnych przydatnych kubitów będą badane obliczenia o głębszych poziomach niż 60 poziomów. W miarę wzrostu liczby i jakości kubitów standardowe superkomputery również będą musiały nadążać, przeliczając i weryfikując wyniki obliczeń kwantowych na jak najgłębszej kolejce.

“Natychmiast wskazuje to na konieczność opracowania nowych metod klasycznych” – powiedział Sajant Anand. I już teraz badają te metody. “Teraz zastanawiamy się, czy możemy zastosować ten sam koncept ograniczania błędów do klasycznych symulacji sieci tensorowych, aby uzyskać lepsze wyniki klasyczne.”

W zasadzie im dokładniej możemy przewidzieć, jak rozwija się szum w układzie kwantowym, tym lepiej wiemy, w jaki sposób ten szum zakłóca poprawne wyniki. Sposobem na naukę przewidywania czegoś jest po prostu próbowanie różnych rzeczy i obserwowanie, co się dzieje wystarczająco wiele razy, aby można było zidentyfikować dźwignie, które wpływają na dany układ.

Niektóre z tych dźwigni mają związek z tym, w jaki sposób i kiedy aktywujesz kubity (niektóre obwody używają więcej kubitów, inne wymagają, aby te kubity były ułożone w więcej lub mniej bramek kwantowych, z bardziej złożonymi splątaniami między pewnymi kubitami…). Badacze IBM musieli dokładnie nauczyć się, ile i jakiego rodzaju szumu wynika z manipulacji każdym z tych parametrów w swoim 127-kubitowym kwantowym układzie Eagle – ponieważ jeśli wiesz, jak wprowadzać szum, zaczynasz go kontrolować. Jeśli rozumiesz, jak się pojawia, możesz uwzględnić ten fakt, co z kolei pozwala ci próbować zapobiegać temu lub wykorzystywać to.

Jednakże jeśli wykonujesz obliczenia tylko na swoim zaszumionym komputerze kwantowym, jak możesz wiedzieć, czy te obliczenia są… poprawne? Właśnie wtedy pojawiają się standardowe superkomputery – i poszukiwanie tzw. “prawdziwej wartości” ang. ground truth

Zespół IBM uzyskał dostęp do dwóch superkomputerów, zwanych Lassen (na Uniwersytecie Kalifornijskim w Berkeley) i Summit (na Uniwersytecie Purdue), aby przeprowadzić symulacje komputerowe równolegle do pracy na kwantowym procesorze IBM Eagle. Porównywali wyniki z symulacji na superkomputerach z wynikami z obliczeń kwantowych na Eagle. Jeśli wyniki zgadzały się, to była to dobra wiadomość – oznaczało to, że obliczenia na procesorze Eagle były poprawne. A jeśli nie, to zespół mógł zidentyfikować, w jaki sposób szum wpływał na wyniki i pracować nad jego kontrolą.

Te badania otwierają drzwi do dalszego rozwoju komputerów kwantowych, które w przyszłości mogą być bardziej niezawodne i przydatne w szerokim zakresie zastosowań. Choć wciąż jest wiele pracy do zrobienia, to praca nad korelacją szumu i wyników kwantowych stanowi ważny krok naprzód w dziedzinie komputerów kwantowych.