SK hynix przedstawia HBM3E i dostarcza próbkę Nvidii

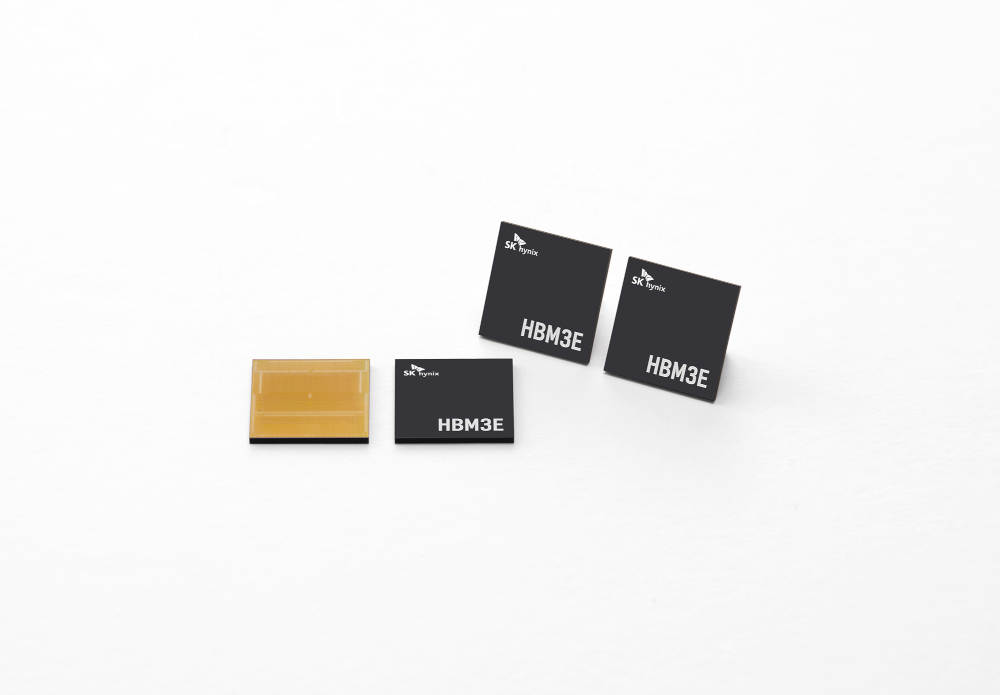

Południowokoreański producent chipów SK hynix ogłosił w poniedziałek, że z powodzeniem opracował HBM3E, najwydajniejszy chip DRAM nowej generacji do zastosowań sztucznej inteligencji. Producent chipów powiedział również, że jego klient ocenia próbkę nowego produktu.

Jak podaje „The Korea Herald”, drugi co do wielkości producent układów pamięci na świecie powiedział, że najnowszy produkt HBM3E, który jest rozszerzoną wersją HBM3, uzupełnia jego doświadczenie jako jedynego masowego dostawcy HBM3 w branży.

Producent chipów powiedział, że planuje masową produkcję HBM3E od pierwszej połowy przyszłego roku, aby umocnić niezrównaną pozycję lidera na rynku pamięci AI.

Mowa jest tutaj o pamięci o dużej przepustowości – wysokowartościowej i wydajnej pamięci, która łączy pionowo wiele układów DRAM, umożliwiając radykalny wzrost szybkości przetwarzania danych w porównaniu z wcześniejszymi produktami DRAM. HBM3E to rozszerzona wersja HBM3 i piąta generacja tego typu, następca poprzednich generacji HBM, HBM2, HBM2E i HBM3. Nvidia, czołowy producent GPU, obecnie ocenia próbkę nowego produktu SK.

„Dzięki opracowaniu HBM3E firma umocniła swoją pozycję lidera na rynku poprzez dalsze zwiększanie kompletności linii produktów HBM, która znajduje się w centrum uwagi w związku z rozwojem technologii sztucznej inteligencji” – powiedział Ryu Sung-soo, szef planowania produktów DRAM w SK Hynix. „Zwiększając udział w dostawach wysokowartościowych produktów HBM, SK hynix będzie również dążyć do szybkiego zwrotu działalności”.

Według firmy, najnowszy produkt nie tylko spełnia najwyższe w branży standardy szybkości – kluczowa specyfikacja dla produktów pamięci AI – ale także wszystkie kategorie, w tym pojemność, odprowadzanie ciepła i łatwość obsługi.

SK hynix powiedział, że HBM3E może przetwarzać dane z prędkością do 1,15 terabajta na sekundę, co odpowiada przetwarzaniu ponad 230 filmów Full HD o wielkości 5 GB każdy w ciągu sekundy. Produkt zapewnia również 10-procentową poprawę rozpraszania ciepła dzięki zastosowaniu w najnowszym produkcie najnowocześniejszej technologii Advanced Mass Reflow Molded Underfill, czyli MR-MUF2. Zapewnia również kompatybilność wsteczną, która umożliwia przyjęcie najnowszego produktu, nawet w systemach, które zostały przygotowane dla HBM3 bez modyfikacji projektu lub struktury, dodał SK hynix.

Podczas gdy HBM3 jest najnowszą wersją chipa na rynku, pamięć HBM3E, która byłaby używana w najnowszym chipie AI Nvidii, jest o 50 procent szybsza, powiedziała Nvidia. HBM3e zapewnia łączną przepustowość 10 terabajtów na sekundę, umożliwiając nowej platformie uruchamianie modeli 3,5 razy większych niż poprzednia wersja, przy jednoczesnej poprawie wydajności dzięki trzykrotnie większej przepustowości pamięci, powiedziała Nvidia.

Według danych opublikowanych przez TrendForce, SK hynix został uznany za lidera na rynku HBM, zajmując prawie 50 procent udziału w rynku od 2022 roku. W tym roku analityk rynku spodziewa się, że zarówno Samsung Electronics, jak i SK hynix zdobędą od 46 do 49 procent udziału w rynku, a Micron Technology od 4 do 6 procent.