Hewlett Packard Enterprise przedstawia kompleksową ofertę dla rozwoju GenAI, w tym wspólnie zaprojektowane rozwiązania programowe i sprzętowe z NVIDIA

Hewlett Packard Enterprise prezentuje najnowsze informacje o jednym z najbardziej wszechstronnych pakietów rozwiązań natywnych dla sztucznej inteligencji, który pomagać będzie w produkcyjnym stosowaniu aplikacji generatywnej sztucznej inteligencji (GenAI) i uczenia maszynowego (ML). Wprowadzone ulepszenia obejmują następujące elementy:

- Dostępność dwóch, opracowanych wspólnie przez HPE i NVIDIA, rozwiązań full-stack w zakresie GenAI.

- Wersja zapoznawcza oprogramowania HPE Machine Learning Inference Software.

- Referencyjna architektura retrieval augmented generation (RAG).

- Wsparcie w rozwoju przyszłych produktów opartych na nowej platformie NVIDIA Blackwell.

„Aby rozwiązania mogły spełniać oczekiwania związane z GenAI, skutecznie obejmując pełny cykl życia AI, z założenia muszą mieć charakter hybrydowy” — powiedział Antonio Neri, prezes i CEO HPE. “Od trenowania i dostrajania modeli lokalnie, w kolokacji lub w chmurze publicznej, po wnioskowanie na brzegu sieci, sztuczna inteligencja jest zadaniem dla chmury hybrydowej. HPE i NVIDIA mają długą historię wspólnych innowacji i nadal będziemy dostarczać wspólnie zaprojektowane rozwiązania programowe i sprzętowe AI, które pomogą naszym klientom przyspieszać rozwój i wdrażanie GenAI od koncepcji do produkcji”.

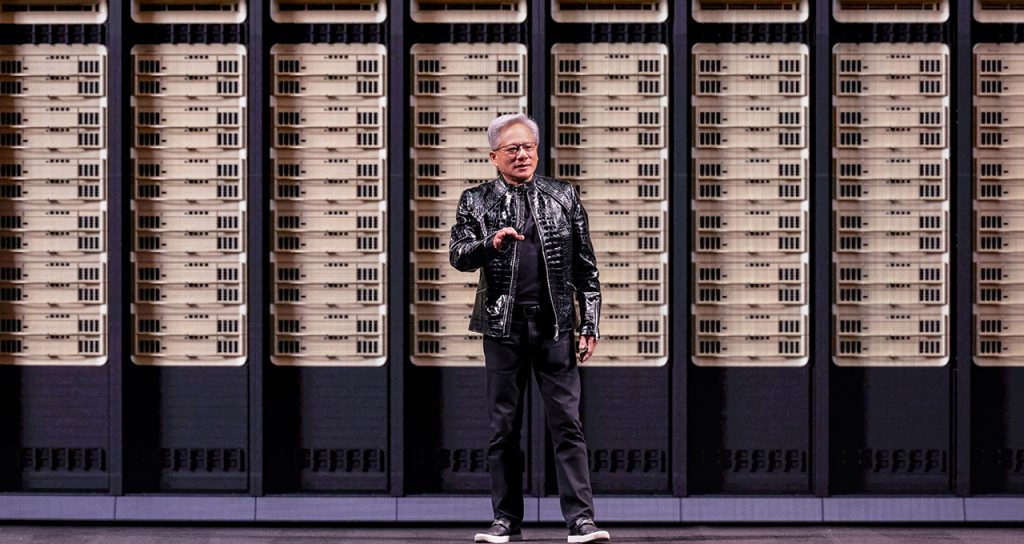

„Generatywna sztuczna inteligencja potrafi przekształcać dane, korzystając z urządzeń połączonych z siecią, centrów danych i chmur, w wiedzę, która może przyczynić się do przełomowych rozwiązań w różnych branżach” – powiedział Jensen Huang, założyciel i dyrektor generalny firmy NVIDIA. „Nasza rozwijająca się współpraca z HPE umożliwi korporacjom zapewnienie bezprecedensowej produktywności poprzez wykorzystanie danych do opracowywania i wdrażania nowych aplikacji AI w celu transformacji ich działalności”.

Trenowanie i dostrajanie GenAI oparte na superkomputerach

Zaprezentowane na konferencji SC23 rozwiązanie superkomputerowe HPE dla generacyjnej sztucznej inteligencji jest już dostępne dla organizacji poszukujących wstępnie skonfigurowanego i przetestowanego rozwiązania full-stack do opracowywania i trenowania dużych modeli sztucznej inteligencji. To gotowe rozwiązanie, stworzone specjalnie z myślą o przyspieszeniu projektów GenAI i głębokiego uczenia (w tym LLM, systemów rekomendacji i wektorowych baz danych), korzysta z mocy urządzeń NVIDIA i może obsługiwać do 168 superchipów NVIDIA GH200 Grace Hopper. Rozwiązanie to umożliwia dużym przedsiębiorstwom, instytucjom badawczym i jednostkom rządowym usprawnienie procesu tworzenia modeli dzięki pakietowi oprogramowania AI/ML. Przeznaczone jest do użytku w centrach badawczych AI i dużych przedsiębiorstwach w celu skrócenia czasu uzyskania korzyści i dwu- lub trzykrotnego przyspieszenia procesu trenowania.

Dostrajanie i wnioskowanie GenAI klasy korporacyjnej

Wstępnie zaprezentowane na targach Discover Barcelona 2023 rozwiązanie HPE do przetwarzania danych korporacyjnych dla celów generatywnej sztucznej inteligencji jest już dostępne bezpośrednio lub za pośrednictwem HPE GreenLake w elastycznym i skalowalnym modelu płatności za wykorzystanie. Wstępnie skonfigurowane rozwiązanie służące do dostrajania i wnioskowania, opracowane we współpracy z firmą NVIDIA, zostało zaprojektowane z myślą o skróceniu czasu i kosztów rozbudowy, oferując odpowiednie zasoby obliczeniowe, pamięci masowej, oprogramowania, sieciowe i doradcze, jakich organizacje mogą potrzebować do tworzenia aplikacji GenAI. Natywne dla sztucznej inteligencji rozwiązanie full-stack zapewnia firmom szybkość, skalowalność i kontrolę niezbędną do dostosowania podstawowych modeli przy użyciu prywatnych danych i wdrażania aplikacji GenAI w modelu chmury hybrydowej.

Rozwiązanie to, obejmujące wysokowydajny klaster obliczeniowy AI i oprogramowanie od HPE i NVIDIA idealnie nadaje się do lekkiego dostrajania modeli, RAG i wnioskowania skalowalnego w poziomie. Czas dostrajania 70 miliardów parametrów modelu Llama 2 z wykorzystaniem tego rozwiązania zmniejsza się liniowo wraz z liczbą węzłów, w systemie z 16 węzłami zajmując 6 minut. Szybsze osiąganie korzyści następuje dzięki poprawie produktywności przy wykorzystaniu aplikacji AI takich jak wirtualni asystenci, inteligentne czatboty i wyszukiwanie na poziomie korporacyjnym.

To rozwiązanie, oparte na serwerach HPE ProLiant DL380a Gen11, jest wstępnie skonfigurowane z procesorami graficznymi NVIDIA GPU i platformą sieciową NVIDIA Spectrum-X Ethernet oraz NVIDIA BlueField-3 DPU. Rozwiązanie jest wzbogacone o platformę uczenia maszynowego i oprogramowanie analityczne firmy HPE, oprogramowanie NVIDIA AI Enterprise 5.0 z nową mikrousługą NVIDIA NIM zapewniającą zoptymalizowane wnioskowanie generatywnych modeli sztucznej inteligencji, a także NVIDIA NeMo Retriever i inne biblioteki do analizy danych i sztucznej inteligencji.

Aby uzupełnić luki kompetencyjne w zakresie sztucznej inteligencji, eksperci HPE Services pomogą w projektowaniu, wdrażaniu i zarządzaniu rozwiązania, w tym w zastosowaniu odpowiednich technik dostrajania modeli.

Od prototypu do produkcji

HPE i NVIDIA współpracują nad rozwiązaniami programistycznymi, które pomogą przedsiębiorstwom wykonać kolejny krok, przekształcając sztuczną inteligencję i uczenie maszynowe z systemów eksperymentalnych w aplikacje produkcyjne. Oprogramowanie HPE Machine Learning Inference Software, dostępne dla klientów HPE w wersji zapoznawczej, umożliwi przedsiębiorstwom szybkie i bezpieczne wdrażanie modeli uczenia maszynowego na dużą skalę. Nowa oferta zostanie zintegrowana z NVIDIA NIM w celu dostarczania zoptymalizowanych pod kątem NVIDIA modeli podstawowych przy użyciu gotowych kontenerów.

Z myślą o pomaganiu przedsiębiorstwom potrzebującym szybkiego tworzenia i wdrażania aplikacji GenAI wykorzystujących dane prywatne przedsiębiorstwa, firma HPE opracowała dostępną już dziś architekturę referencyjną dla korporacyjnych rozwiązań RAG, opartą na architekturze mikrousług NVIDIA NeMo Retriever. Oferta składa się z kompleksowego fundamentu obsługi danych, opartego na oprogramowaniu HPE Ezmeral Data Fabric i HPE GreenLake for File Storage. Nowa architektura referencyjna udostępniać będzie firmom wzorzec tworzenia niestandardowych chatbotów, generatorów i kopilotów.

Aby pomóc w przygotowywaniu danych, szkoleniu sztucznej inteligencji i realizacji wnioskowania, rozwiązanie to łączy w sobie pełne spektrum narzędzi i rozwiązań typu open source w ramach HPE Ezmeral Unified Analytics Software i oprogramowania HPE AI, które obejmuje produkty HPE Machine Learning Data Management Software, HPE Machine Learning Development Environment Software oraz nowe HPE Machine Learning Inference Software. Oprogramowanie HPE do sztucznej inteligencji jest dostępne zarówno na superkomputerach HPE, jak i w rozwiązaniach obliczeniowych dla przedsiębiorstw na potrzeby generatywnej sztucznej inteligencji, aby zapewnić klientom spójne środowisko do zarządzania zadaniami związanymi z GenAI.

Rozwiązania nowej generacji zbudowane w oparciu o platformę NVIDIA Blackwell

HPE opracowywać będzie swoje przyszłe produkty w oparciu o zaprezentowaną niedawno platformę NVIDIA Blackwell, obejmującą Transformer Engine drugiej generacji, służący przyspieszeniu obciążeń GenAI. W przyszłości ogłaszane będą kolejne informacje o dostępności następnych produktów HPE z Superchipem NVIDIA GB200 Grace Blackwell, HGX B200 i HGXB100.