Niezastąpione centra danych. W wielu krajach działalność Data Center jest sklasyfikowana jako „usługi o kluczowym znaczeniu”. Jak pandemia zmieniła rolę usług data centers?

Gotowość na niespodziewane sytuacje jest niejako wpisana w DNA branży centrów danych. W wielu krajach ich działalność jest sklasyfikowana jako „usługi o kluczowym znaczeniu”. Wybuch pandemii był jednym z testów, czy rzeczywiście tak jest. Biorąc pod uwagę wnioski z badania przeprowadzonego przez PMR, można powiedzieć, że centra danych zdały egzamin z radzenia sobie w niecodziennych okolicznościach. Z czym musiały się zmierzyć?

Można wyodrębnić dwa kluczowe czynniki stymulujące ogromny wzrost popytu, związane z wybuchem pandemii. Po pierwsze jest to zapotrzebowanie na moc obliczeniową, wynikające z przejścia wielu firm i instytucji na pracę zdalną. Infrastruktura cyfrowa nigdy nie była tak ważna dla światowej gospodarki. Związane z tym wykorzystanie aplikacji cyfrowych na potrzeby połączeń wideo, telemedycyny, e-handlu i e-nauczania, a także w celach rozrywkowych, ponieważ spędzamy więcej czasu w domu, powoduje wzrost zapotrzebowania na duże ilości danych.

Wykorzystanie przepustowości centrów danych z nowymi rekordami

Najnowsza publikacja firmy Kingston dotycząca rozwoju centrów danych wskazywała na „nienasycone” zapotrzebowanie na dane związane z rozwojem technologii 5G, Internetu rzeczy i Edge Computing. W kontekście pandemii sprawiło to, że 11 marca 2020 r. dostawca usług centrum danych, Deutsche Commercial Internet Exchange, ustanowił we Frankfurcie nowy rekord świata — przepustowość danych przekraczającą 9,1 terabajta na sekundę. Jednak choć monitorowanie „kondycji Internetu” wskazuje na tendencję wzrostową przerw w realizacji usług, nie osiąga ona poziomu odpowiadającego bezprecedensowemu wzrostowi ruchu. Ponadto, mimo obecnego i prognozowanego z roku na rok wzrostu ruchu i obciążeń w centrach danych, warto zauważyć, że Międzynarodowa Agencja Energetyczna (IEA) przewiduje spadek globalnego zapotrzebowanie na energię w centrach danych. Wynika to zarówno z praktyk konsolidacyjnych, jak i wydajnościowych (zwłaszcza w odniesieniu do systemów chłodzenia), a także faktu, że niektóre nowe hiperskalowe centra danych są lub mają być zasilane w 100% energią ze źródeł odnawialnych.

Systemy obliczeniowe o dużej wydajności wspierają badania na rzecz zwalczania wirusa

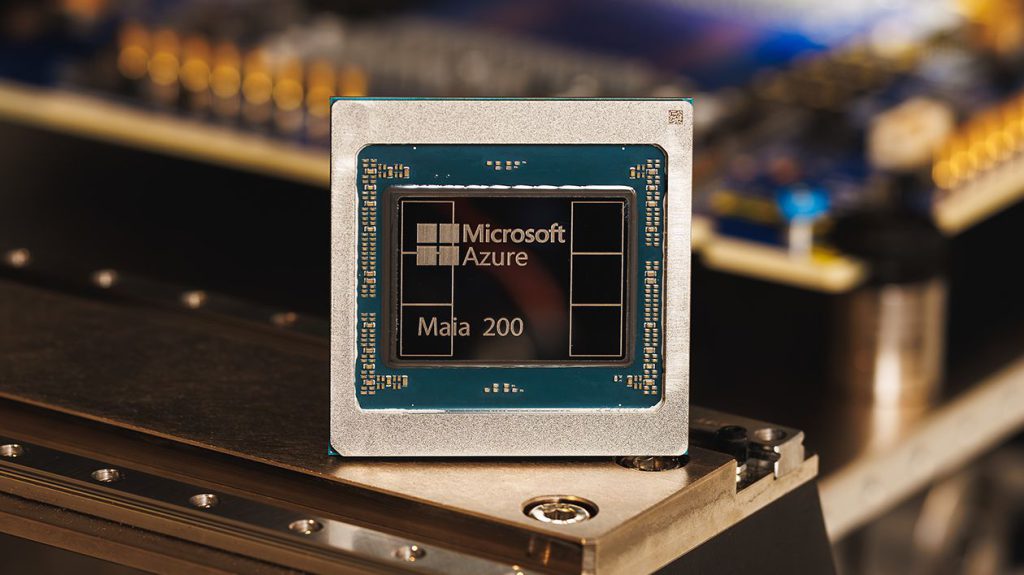

Drugim kluczowym czynnikiem jest potrzeba szybkości i mocy obliczeniowej — i tu właśnie pojawiają się systemy obliczeniowe o dużej wydajności (ang. High Performance Computing, HPC). Badania nad szczepionkami i leczeniem generują duże zbiory danych. Instytucje badawcze i firmy farmaceutyczne po raz pierwszy wykorzystują na dużą skalę systemy HPC do przeprowadzania symulacji i obliczeń w takich dziedzinach, jak epidemiologia i bioinformatyka. Może pomóc to radykalnie skrócić czas potrzebny na opracowanie nowych leków.

Coronavirus High-Performance Computing Consortium zrzesza liderów z obszarów technologii, administracji i środowisk akademickich, udostępniając ponad 330 petaflopów mocy obliczeniowej, 775 000 rdzeni procesorów i 34 000 kart graficznych. W celu lepszego zrozumienia wirusa i opracowania metod leczenia, które mogą być wykorzystane do stworzenia potencjalnych szczepionek, możliwe jest teraz wykonanie niesamowitej liczby 330 trylionów operacji zmiennoprzecinkowych na sekundę. To także doskonały przykład przedkładania współpracy nad konkurencję przez takie firmy, jak IBM, Amazon, Microsoft, HPE i Google.

Choć centra danych są często niewidoczne, w istocie są „generatorami mocy” dla przetwarzania w chmurze i „łącznikami” Internetu, które zaspokajają potrójną potrzebę: większej prędkości, większej elastyczności i optymalnej dostępności. Operatorzy szybko zareagowali, aby zapewnić systemom odporność i przeciwdziałać ryzyku przestojów i przerw w świadczeniu usług dla różnych grup użytkowników. Według szacunków firmy Gartner średni koszt przestoju IT wynosi ok. 5600 USD na minutę, nic zatem dziwnego, że jest to wiodący problem w zarządzaniu systemami IT. W taki sam sposób konsumenci starali się gromadzić żywność i artykuły gospodarstwa domowego, czego symbolicznym przykładem były masowe zakupy papieru toaletowego obserwowane na całym świecie. Na podobnej zasadzie klienci centrów danych starali się zabezpieczyć dodatkowe zasoby mocy obliczeniowej i przepustowości, aby sprostać szybko rosnącym potrzebom i zapewnić ciągłość działania.

Wirtualne zarządzanie „wirtualną” rzeczywistością

Przejrzystość ma zasadnicze znaczenie zarówno dla zapewnienia bezpieczeństwa, jak i budowania zaufania, dlatego operatorzy centrów danych publicznie dzielą się informacjami dotyczącymi kryteriów zarządzania, a w razie potrzeby nadawania priorytetu nowym usługom w chmurze w celu zabezpieczenia operacji o krytycznym znaczeniu. Obecni klienci również otrzymali znaczące wsparcie — wielu dostawców wprowadziło krótkoterminowe rozwiązania, takie jak zawieszenie naliczania dodatkowych opłat za przekroczenie limitów przepustowości. W przypadku wielu klientów z sektora MŚP, u których wystąpiło nieoczekiwane i nieplanowane zapotrzebowanie na ruch sieciowy i przepustowość, zdolność do zwiększenia obciążeń systemu i sieci ponad zadeklarowane wartości, do poziomu maksymalnej przepustowości portów, bez ponoszenia karnych opłat, może mieć w tym burzliwym czasie znaczenie dla zapewnienia rentowności. W badaniu „KoronaBilans MŚP” 45% ankietowanych firm odpowiedziało, że może częściowo lub całkowicie prowadzić działalność online, z czego połowa już wprowadziła te zmiany w życie lub planowała zrobić to w ciągu najbliższych trzech miesięcy.

Kluczowe jest zachowanie ciągłości usług

Umożliwienie zachowania ciągłości działania klientów i partnerów wymaga zapewnienia jej również dla samych centrów danych, zwłaszcza w kontekście ochrony pracowników, partnerów i dostawców. Jednym z kluczowych obszarów, które to potwierdzają, jest poziom dzielenia się wiedzą w tym sektorze, szczególnie jeśli chodzi o procedury BHP, a także kwestie dotyczące zasobów ludzkich i łańcucha dostaw. W grę wchodzi także współpraca z rządem.

Wybuch pandemii oznaczał ograniczenie dróg infekcji i konieczność radzenie sobie z rzeczywistością izolacji obiektów. Wymagało to wprowadzenia ograniczeń dostępu i harmonogramu dyżurów z zachowaniem zasad dystansu społecznego. Pojawiły także problemy związane z dostępnością — przede wszystkim na skutek zmniejszenia się liczby pracowników na miejscu, a także nieobecności kluczowego personelu z powodu choroby lub izolacji.

Wskazówki dotyczące obiektów o krytycznym znaczeniu są szczególnie ważne dla ograniczenia ryzyka, dlatego kluczowe są możliwości zdalnego zarządzania. Połączenie technologii czujników, usług pomocy technicznej w rozwiązywaniu problemów, takich jak „Smart Hands”, a także monitorowania systemów w kluczowych obszarach wydajności (zwłaszcza związanych z dystrybucją zasilania i temperaturą), umożliwia podniesienie poziomu zdalnej kontroli w czasie rzeczywistym. Pozwala to uzyskać zdolność do zaawansowanej analizy danych i przewidywania potencjalnych incydentów. W istocie oprócz potrzeby zaspokojenia wymagań dotyczących wydajności obliczeniowej, szybkości, niezawodności i mocy koronawirus wysunął na pierwszy plan pytanie, do jakiego stopnia można efektywnie zdalnie zarządzać centrum danych. Co więcej, w obszarach związanych z pracą, nauką, komunikacją i rozrywką — a także lepszym zrozumieniem mechanizmów działania wirusa i zapewnieniem wsparcia w leczeniu — rola centrów danych przesunęła się teraz wyraźnie na centralny plan.

https://itreseller.pl/itrnewkolejni-giganci-technologiczni-ubiegaja-sie-o-licencje-umozliwiajaca-handlowanie-z-huawei-japonscy-giganci-moga-byc-zaledwie-wierzcholkiem-gory-lodowej/