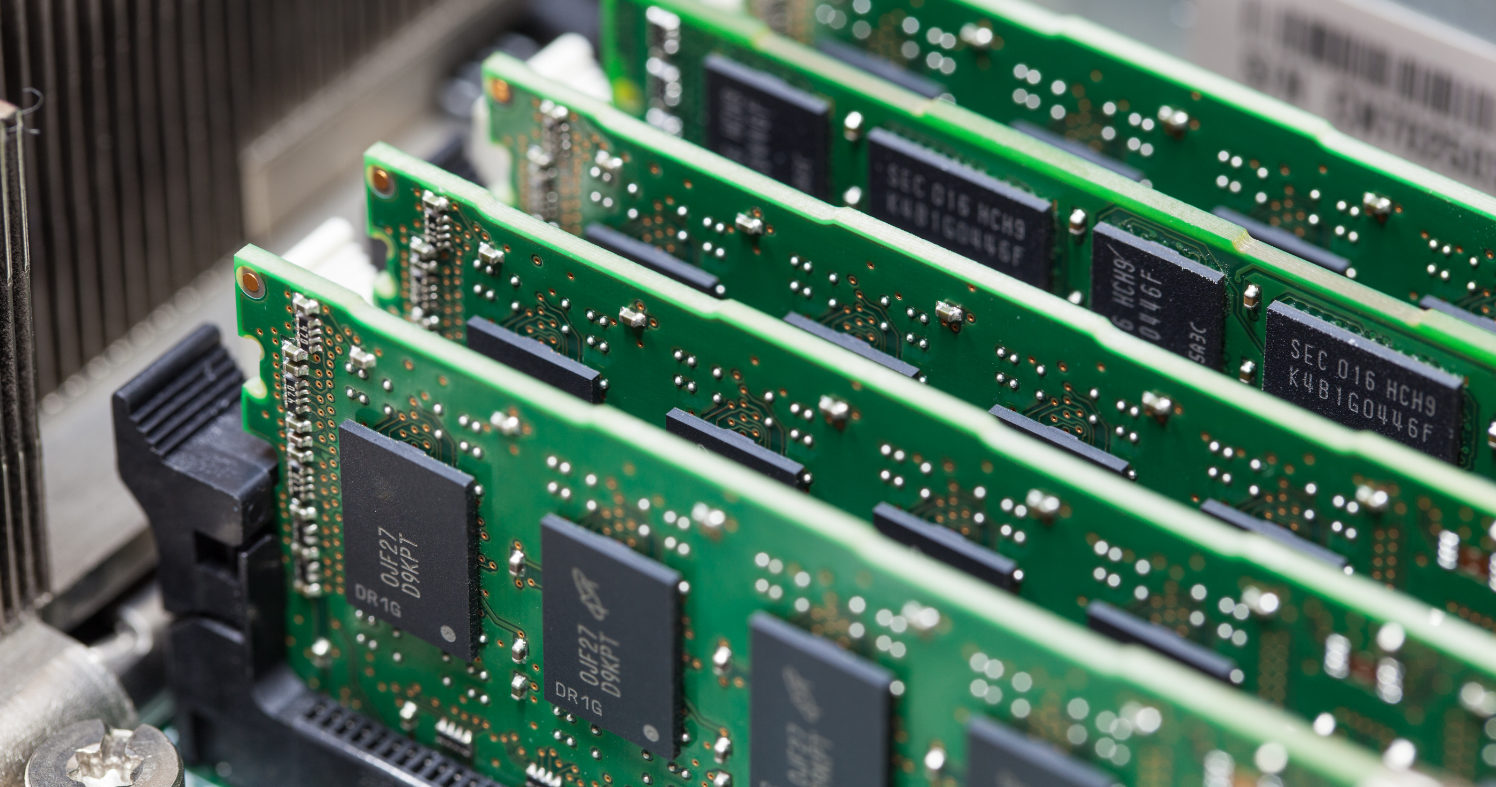

AI pochłonie jedną piątą globalnej produkcji DRAM w 2026 roku

Rozwój infrastruktury sztucznej inteligencji coraz mocniej uderza w globalny rynek pamięci. Według szacunków cytowanych przez Commercial Times, już w 2026 roku AI może odpowiadać za równowartość blisko 20% światowej produkcji wafli DRAM. Kluczową rolę odgrywają tu pamięci HBM oraz GDDR7, których wytwarzanie jest znacznie bardziej zasobożerne niż klasycznego DRAM.

AI generuje ogromny popyt na pamięć

Commercial Times, powołując się na źródła branżowe, prognozuje, że zapotrzebowanie chmur obliczeniowych na szybkie pamięci może do 2026 roku sięgnąć łącznie około 3 EB (eksabajtów). Największą część tej wartości stanowią obciążenia inferencyjne realizowane w czasie rzeczywistym przez globalne platformy AI. Dotyczy to m.in. usług rozwijanych przez Google, Amazon Web Services oraz OpenAI. Same potrzeby operacyjne tych systemów szacowane są na około 750 PB (petabajtów), jednak po uwzględnieniu rezerw, redundancji i wymogów bezpieczeństwa wolumen ten rośnie do około 1,5 EB.

Drugim filarem popytu są prywatne centra danych dużych graczy technologicznych oraz rynek chiński. Infrastruktura budowana przez Meta i Apple, w połączeniu z lokalnymi wdrożeniami w Chinach, ma odpowiadać za kolejne 800 PB zapotrzebowania. Do tego dochodzą potrzeby związane z trenowaniem kolejnych generacji modeli, w tym przechowywanie punktów kontrolnych i parametrów sieci neuronowych, co według raportu generuje dodatkowe około 500 PB.

HBM i GDDR7 jako główny czynnik presji

Autorzy raportu podkreślają, że wyścig w obszarze AI coraz mniej dotyczy surowej mocy obliczeniowej, a coraz bardziej kosztów inferencji i dostępnej pojemności pamięci. Modele generatywne oraz systemy agentowe wymagają przechowywania ogromnych ilości danych pośrednich, co wielokrotnie zwiększa zapotrzebowanie na pamięć na jednego użytkownika lub agenta AI.

To właśnie w tym miejscu kluczowe znaczenie zyskują HBM oraz GDDR7. Produkcja tych pamięci jest znacznie bardziej obciążająca dla fabryk niż klasyczny DRAM. Według szacunków, 1 GB pamięci HBM zużywa czterokrotnie więcej mocy produkcyjnej wafli niż standardowy DRAM, a w przypadku GDDR7 współczynnik ten wynosi około 1,7. W praktyce oznacza to, że udział AI w zużyciu mocy produkcyjnych jest znacznie większy niż jego udział w fizycznie dostarczonej pojemności.

Konsekwencje dla rynku i cen

Commercial Times wskazuje, że całkowita globalna zdolność produkcyjna DRAM może w 2026 roku sięgnąć około 40 EB. Przy takim poziomie, równoważne zużycie przez AI na poziomie niemal 20% oznacza silną presję na pozostałe segmenty rynku. Tymczasem roczny wzrost mocy produkcyjnych DRAM szacowany jest jedynie na 10–15%.

W efekcie coraz bardziej realny staje się scenariusz ograniczonej podaży pamięci DDR5 dla komputerów osobistych, smartfonów i klasycznych serwerów. To z kolei niemal nieuchronnie prowadzi do dalszych wzrostów cen i większej zmienności rynku. Dane z raportu pokazują wyraźnie, że w nadchodzących latach to pamięć, a nie same procesory czy akceleratory, może stać się głównym wąskim gardłem rozwoju infrastruktury AI.