AI pod kontrolą: Bezpieczeństwo i dostarczanie aplikacji w praktyce, zdaniem Bartłomieja Anszpergera, Solution Engineering Managera w firmie F5

Zrozumienie, jak aplikacje AI wpływają na architekturę sieci oraz wybór rozwiązań w obszarze ich dystrybucji oraz zabezpieczeń to kluczowe kroki w odpowiedzi na nowe wyzwania technologiczne. Zmiany w dystrybucji obciążeń i wzorcach ruchu wymagają analizy, aby efektywnie implementować usługi, które zapewnią maksymalną efektywność, wydajność i redukcję kosztów. Temat przedstawia Bartłomiej Anszperger, Solution Engineering Manager w firmie F5.

Każda nowa generacja architektury aplikacji wpływa na ruch w sieci. Jest to istotne, ponieważ każda znacząca zmiana wymaga dostosowania systemów dostarczania i zabezpieczeń aplikacji. W przypadku aplikacji AI, choć skala i złożoność problemów wzrastają, wyzwania pozostają znajome.

– Wyzwania związane z aplikacji AI są dobrze znane. Choć te problemy ewoluują, wiele z nich dotyczy zagadnień, które rozwiązywaliśmy od minionej dekady – zaznacza Bartłomiej Anszperger. – Sztuczna inteligencja zmienia jednak sposób dystrybucji obciążeń i wzorce ruchu. Większość tego ruchu w sieci to ruch aplikacyjny, a coraz częściej ruch API i na tym polega różnica. Zrozumienie tych nowych wzorców i sposobu ich dystrybucji między rdzeniem, chmurą a brzegiem sieci daje wgląd w to, jakie usługi dostarczania i bezpieczeństwa aplikacji są potrzebne oraz gdzie należy je wdrożyć.

Nowe wzorce ruchu

Jedną z kluczowych konsekwencji wdrożenia sztucznej inteligencji jest wzrost ruchu w dwóch osiach: poziomej (E-W) i pionowej (N-S). Jego znaczna część na linii N-S będzie pochodzić od aplikacji AI, co sprawia, że wychodząca ścieżka N-S stanie się strategicznym punktem kontroli obok tradycyjnej ścieżki przychodzącej.

W perspektywie najbliższych 2–3 lat aplikacje AI będą uzupełniać istniejące portfele, a konsolidacja nastąpi wraz ze zrozumieniem popytu na interfejsy języka naturalnego (NLI). Zwiększona dystrybucja na ścieżce N-S wymaga wzmocnienia usług bezpieczeństwa na granicy firmowej. Jednocześnie rosnący ruch E-W w różnych środowiskach wymusza rozwój sieci jej łączących (ang. multicloud networks) oraz rozwiązań bezpieczeństwa a także kontroli dostępu wewnątrz organizacji.

W efekcie w architekturze AI pojawiają się dwa nowe punkty integracji usług (ang. insertion points), które stwarzają okazję do przemyślenia strategii wdrożeń nowych elementów pod kątem efektywności, redukcji kosztów i skuteczności działania. Jest to szczególnie ważne w obliczu coraz częstszych luk w zabezpieczeniach serwerów inferencyjnych, które komunikują się z klientami przez API. Wdrażanie zabezpieczeń API na tym poziomie jest kluczowe dla ochrony modeli AI i serwerów, oraz pełni rolę „ostatniej linii obrony” i umożliwia szybką reakcję na nowe zagrożenia dzięki programowalnym rozwiązaniom bezpieczeństwa.

Punkty integracji dla dostarczania i bezpieczeństwa aplikacji

W oparciu o wzorce wnioskowania AI można wyróżnić sześć różnych punktów integracji usług aplikacji. Każdy z nich pozwala zoptymalizować bezpieczeństwo, skalowalność i wydajność w rozszerzonej architekturze.

- Usługi globalne (dla całej organizacji)

Na tym poziomie dominują głównie usługi bezpieczeństwa, obejmujące również rozwiązania na poziomie firmowym, takie jak DNS, GSLB i sieci wielochmurowe. Mechanizmy bezpieczeństwa, takie jak DDoS i Bot Protection, doskonale się tu sprawdzają, ponieważ uniemożliwiają zapobiegają wykorzystaniu krytycznych (i kosztownych) zasobów głębiej w infrastrukturze IT, szczególnie w aplikacjach, które są hostowane w chmurze publicznej.

- Usługi wspólne (dla konkretnej lokalizacji)

Zapewniają dodatkową ochronę przed atakami oraz gwarantują dostępność aplikacji i infrastruktury. Oferują takie funkcje jak balansowanie obciążenia dla aplikacji, API czy usług infrastrukturalnych (np. zapory ogniowe, SSL VPN).

- Usługi aplikacyjne (dla konkretnej aplikacji)

W tym punkcie usługi są ściśle powiązane z aplikacjami lub API, które obsługują i chronią. Obejmują zapory aplikacyjne (WAF), lokalne balansowanie obciążenia oraz kontrolę dostępu, zabezpieczając komunikację pomiędzy użytkownikiem a aplikacją.

- Sieciowanie mikrousług (dla konkretnego klastra)

Usługi na tym poziomie są zwykle wdrażane w ramach infrastruktury Kubernetes i obejmują m.in. wzajemne uwierzytelnianie transportowe (mTLS) oraz warstwę sieci (ang. service mesh), które zabezpieczają komunikację między aplikacjami.

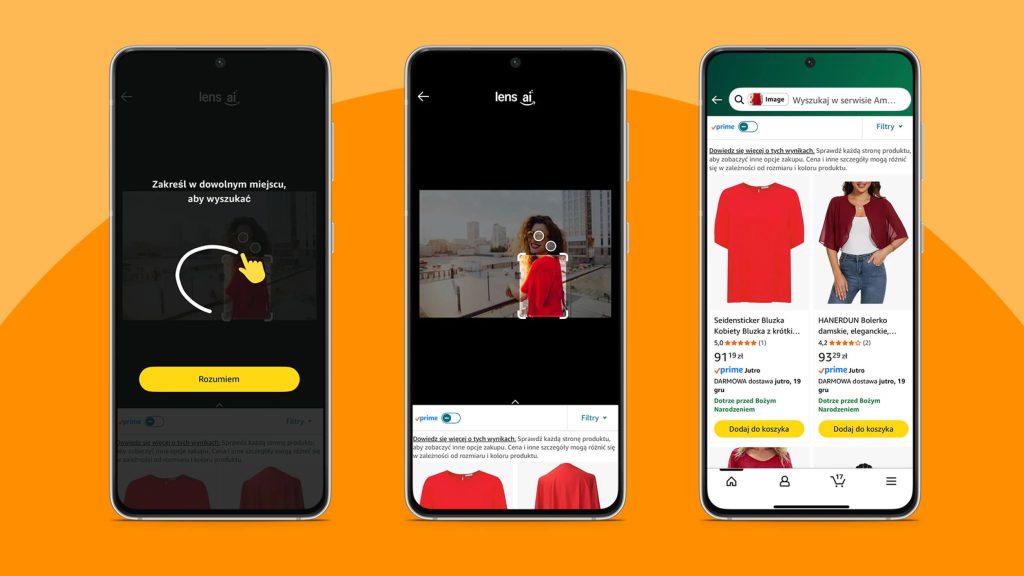

- Usługi wnioskowania AI (dla kompleksów obliczeniowych AI)

Ten nowy punkt integracji jest specyficzny dla aplikacji AI i obejmuje funkcje dostarczania i bezpieczeństwa zaprojektowane specjalnie w celu dostarczania i ochrony usług wnioskowania AI. Typowe rozwiązania to balansowanie obciążenia oraz ograniczanie przepustowości na poziomie warstwy aplikacyjnej w celu ochrony API wnioskowania AI.

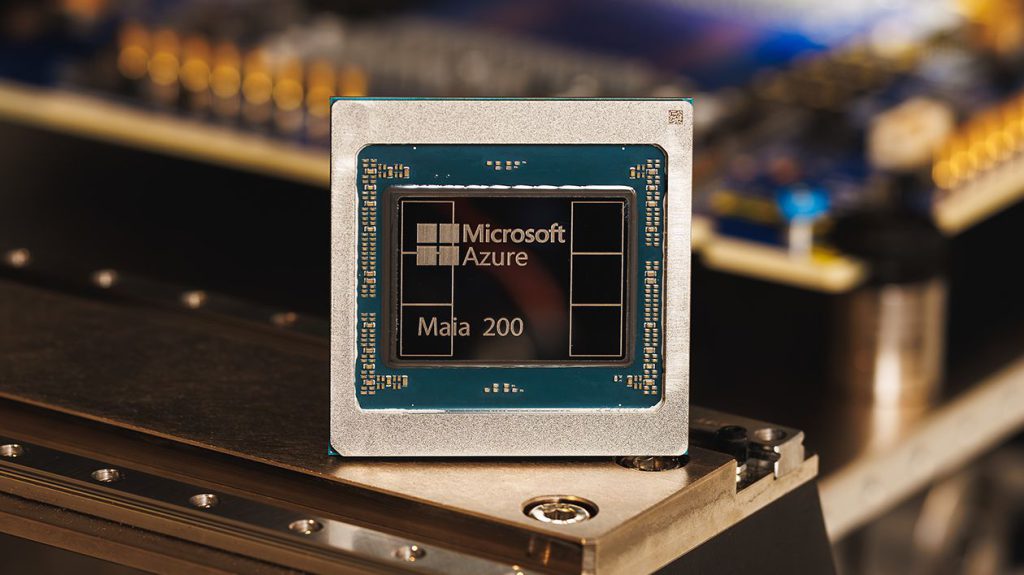

- Usugi infrastrukturalne AI (dla serwerów AI)

Ostatni, nowy punkt integracji jest skorelowany z siecią AI. Te usługi są wdrażane na jednostkach DPU (Data Processing Units) do obsługi zadań związanych z dostarczaniem i bezpieczeństwem. Dzięki temu procesory CPU są odciążone od z zadań związanych z infrastrukturą, dzięki czemu mogą być w pełni wykorzystane do przetwarzania zapytań zwiększając tym samym wydajność serwerów wnioskowania.

Większość usług dostarczania i bezpieczeństwa aplikacji można wdrożyć w dowolnym punkcie integracji , z wyjątkiem tych zaprojektowanych do specyficznych środowisk, jak kontrolery wejścia i warstwa sieci aplikacyjnej w Kubernetes, które wymagają dostosowania do konkretnych infrastruktur.

– Wybór odpowiedniego punktu integracji powinien uwzględniać takie czynniki jak skuteczność zabezpieczeń, wydajność operacyjną oraz optymalizację koszty, zarówno tych operacyjnych, jak i związanych z przetwarzaniem ruchu w infrastrukturze IT – komentuje Bartłomiej Anszperger. – F5 wspiera wdrażanie tych usług w jak największej liczbie punktów integracji w różnych środowiskach, umożliwiając organizacjom dopasować je do ich specyficznych rozwiązań infrastrukturalnych i środowiska.

Choć istnieją sprawdzone praktyki dopasowywania usług do punktów integracji , każda architektura korporacyjne ma swoje unikalne wymagania. To właśnie dlatego elastyczność i programowalność w projektowaniu usług aplikacyjnych oraz zabezpieczeń są kluczowe dla efektywnego zarządzania infrastrukturą IT.