AMD wyznacza nowe standardy na rynku AI dzięki współpracy z OpenAI i startupami

AMD intensyfikuje współpracę z najlepszymi startupami AI, inwestuje w rozwój własnego ekosystemu oprogramowania i wprowadza na rynek kolejne generacje chipów, które mają konkurować z produktami Nvidii. Nowe inicjatywy mają nie tylko przyciągnąć kluczowych partnerów, ale także uczynić AMD realną alternatywą na globalnym rynku AI.

Rosnące ambicje AMD na rynku sztucznej inteligencji

W obliczu rosnącego popytu na zaawansowane układy AI oraz dominacji Nvidii, AMD zintensyfikowało działania na rzecz rozwoju zarówno sprzętu, jak i oprogramowania, ściśle współpracując z innowacyjnymi startupami branżowymi. Firma niedawno sfinalizowała przejęcie producenta serwerów ZT Systems, co pozwala na lepszą integrację rozwiązań sprzętowych dla klientów z sektora sztucznej inteligencji.

Jednak sukces w branży AI nie zależy wyłącznie od nowoczesnych układów scalonych. Kluczową rolę odgrywa kompleksowe, dopracowane oprogramowanie, które umożliwia sprawną pracę najnowszych modeli sztucznej inteligencji. Dlatego w ostatnich tygodniach AMD przejęło kilka mniejszych firm programistycznych, wzmacniając swoje kompetencje zespołowe oraz rozbudowując platformę ROCm – otwartą warstwę oprogramowania umożliwiającą efektywne wykorzystywanie kart graficznych AMD w zastosowaniach AI.

„To podróż zaplanowana na lata i kolejne generacje produktów” — podkreśla Vamsi Boppana, starszy wiceprezes działu AI w AMD.

Firma postawiła sobie za cel stworzenie w pełni konkurencyjnej oferty zarówno sprzętowej, jak i programistycznej dla najbardziej wymagających klientów.

Współpraca z liderami rynku i optymalizacja pod konkretne potrzeby

Jednym z kluczowych partnerów AMD w obszarze AI jest kanadyjski startup Cohere, który tworzy modele sztucznej inteligencji skierowane do dużych przedsiębiorstw. Dzięki ostatnim postępom po stronie AMD, migracja rozwiązań Cohere na chipy tej firmy zajmuje już nie tygodnie, lecz zaledwie kilka dni.

„Dla nas to duży krok naprzód — AMD wykonało ogromny postęp w dziedzinie oprogramowania” — komentuje Aidan Gomez, CEO Cohere.

Jak podkreśla, proces migracji oprogramowania na platformę AMD stał się dużo bardziej efektywny, a rozwiązania firmy stanowią obecnie istotny element globalnej infrastruktury obliczeniowej Cohere.

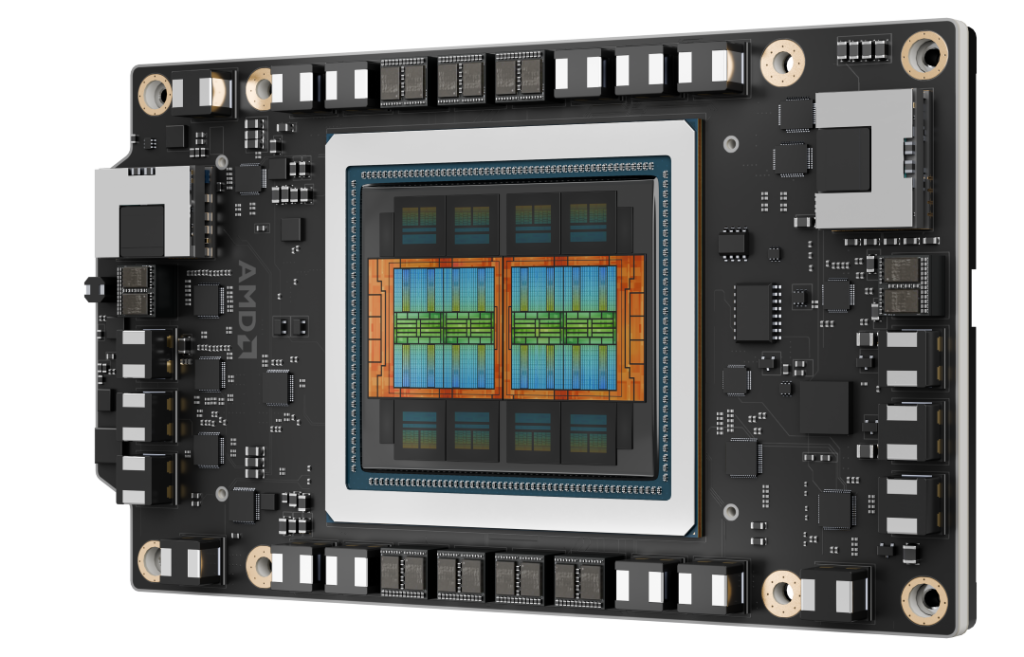

Kolejnym strategicznym partnerem AMD jest OpenAI. Współpraca przy projektowaniu najnowszych chipów z serii MI450 i nowej generacji serwerów Helios miała istotny wpływ na optymalizację architektury pamięci oraz możliwości skalowania.

„Otrzymaliśmy mnóstwo cennych uwag od OpenAI, które znacząco pomogły w projektowaniu układów pod kątem najbardziej wymagających zastosowań” — mówi Forrest Norrod, wiceprezes wykonawczy AMD.

Nowe chipy i własna platforma serwerowa

Przygotowywana na 2026 rok platforma serwerowa Helios, oparta o układy MI400, ma być odpowiedzią AMD na koncepcję zintegrowanych serwerów, które Nvidia z powodzeniem oferuje sektorowi AI. Tego typu rozwiązania pozwalają na jednoczesną pracę setek, a nawet tysięcy układów obliczeniowych, co jest niezbędne do trenowania najnowocześniejszych modeli generatywnej sztucznej inteligencji.