CES 2026: AMD stawia na yotta-scale computing, MI400 już w drodze, MI500 w planach

Podczas wystąpienia na targach CES 2026 w Las Vegas AMD ujawniło pełne portfolio akceleratorów Instinct MI400 oraz pierwsze szczegóły dotyczące przyszłej generacji MI500. Według zapowiedzi prezes firmy, dr Lisy Su, nowe układy mają być fundamentem ery „yotta-scale computing” i przynieść bezprecedensowy wzrost mocy obliczeniowej dla sztucznej inteligencji.

MI400, Helios i skala exaflopów w jednej szafie

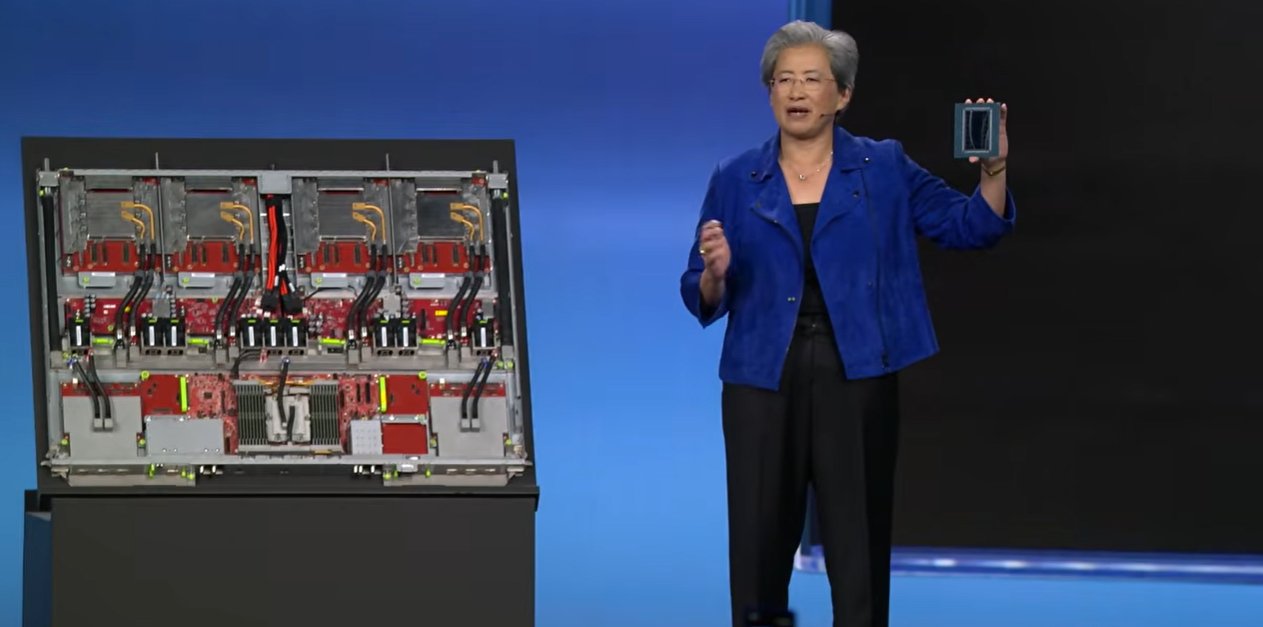

AMD zaprezentowało na CES kompletne portfolio MI400, obejmujące kilka klas akceleratorów i gotowych platform serwerowych. Kluczowym elementem jest podwójna szafa Helios, której rynkowa premiera planowana jest na III kwartał 2026 roku. Według AMD pojedynczy rack Helios ma oferować do trzech eksaflopów mocy obliczeniowej AI, co firma określa jako wzorzec dla przyszłych instalacji yotta-scale.

Helios integruje 72 akceleratory Instinct MI455X, wyposażone łącznie w 31 TB pamięci HBM4. Uzupełnieniem oferty są Instinct MI440X, serwer montowany w szafie, łączący osiem GPU z jednym procesorem AMD Epyc Venice, przeznaczony do trenowania i wnioskowania modeli AI, oraz Instinct MI430X, adresowany do projektów sovereign AI, HPC i środowisk hybrydowych.

Wszystkie akceleratory MI430X, MI440X i MI455X mają być pierwszymi GPU obsługującymi nowy interkonekt UALink do skalowania w obrębie węzła. W komunikacji między węzłami Helios wykorzysta Ultra Ethernet, współpracujący z kartami Pensando Pollara 400G oraz zapowiadanymi Pensando Vulcano 800G.

MI500 i zapowiedź skoku o trzy rzędy wielkości

Podczas przemówienia dr Lisa Su zdradziła także pierwsze informacje o serii MI500, której debiut planowany jest na 2027 rok. Według zapowiedzi nowe układy mają zapewnić nawet 1 000-krotny wzrost wydajności AI w porównaniu z Instinct MI300X, przy zastosowaniu architektury AMD CDNA 6. Zarówno MI400, jak i MI500 mają powstawać w litografii 2 nm TSMC, przy czym w przypadku MI500 firma sugeruje użycie jeszcze bardziej zaawansowanego wariantu procesu.

AMD przypomniano również o ogłoszonym w październiku 2025 roku partnerstwie z OpenAI, obejmującym dostawy GPU o łącznej mocy 6 GW. Występujący na scenie razem z Lisą Su prezes i współzałożyciel OpenAI, Greg Brockman, nie ujawnił jednak nowych szczegółów dotyczących planowanego centrum danych o mocy 1 GW ani jego lokalizacji.