Coraz więcej halucynacji w artykułach o AI, a błędne cytowania to najmniejszy problem

Najważniejsze konferencje poświęcone uczeniu maszynowemu i sztucznej inteligencji mierzą się z narastającym problemem jakości publikacji naukowych. Analiza zaakceptowanych prac pokazuje rosnącą liczbę halucynacji, błędów merytorycznych i fikcyjnych odniesień bibliograficznych, które coraz częściej wynikają z niekontrolowanego użycia narzędzi generatywnej AI.

Halucynacje i fikcyjne cytowania w pracach naukowych

Firma GPTZero, zajmująca się wykrywaniem treści generowanych przez sztuczną inteligencję, zidentyfikowała 100 halucynacji w ponad 51 artykułach zaakceptowanych przez NeurIPS. Chodzi głównie o nieistniejące publikacje, fikcyjnych autorów oraz fragmenty tekstu, które sprawiają wrażenie poprawnych naukowo, lecz nie mają pokrycia w rzeczywistych badaniach.

To nie jest pierwszy tego typu przypadek. Wcześniejsze analizy wykazały podobne problemy w pracach zgłaszanych na ICLR, gdzie wykryto dziesiątki nieprawdziwych odniesień bibliograficznych. Skala zjawiska sugeruje, że nie są to incydenty jednostkowe, lecz efekt systemowy.

Jednym z czynników sprzyjających problemowi jest gwałtowny wzrost liczby zgłoszeń. W latach 2020–2025 liczba prac przesyłanych na NeurIPS wzrosła o ponad 220%, z 9 467 do 21 575. Wymusiło to masową rekrutację recenzentów, często o bardzo zróżnicowanym doświadczeniu i wąskich specjalizacjach, co zwiększa ryzyko przeoczeń i błędów w procesie oceny.

Rosnąca liczba błędów merytorycznych

Problem nie ogranicza się wyłącznie do cytowań. Analiza preprintu opublikowanego w grudniu 2025 r. przez zespoły z Together AI, NEC Labs America, Rutgers University oraz Stanford University pokazuje wyraźny wzrost liczby błędów merytorycznych w artykułach naukowych dotyczących AI.

Badanie objęło prace z NeurIPS, ICLR oraz TMLR. Średnia liczba obiektywnych błędów w jednej publikacji systematycznie rosła. W przypadku NeurIPS wzrosła z 3,8 w 2021 r. do 5,9 w 2025 r., co oznacza wzrost o 55,3%. Podobny trend odnotowano w ICLR i TMLR.

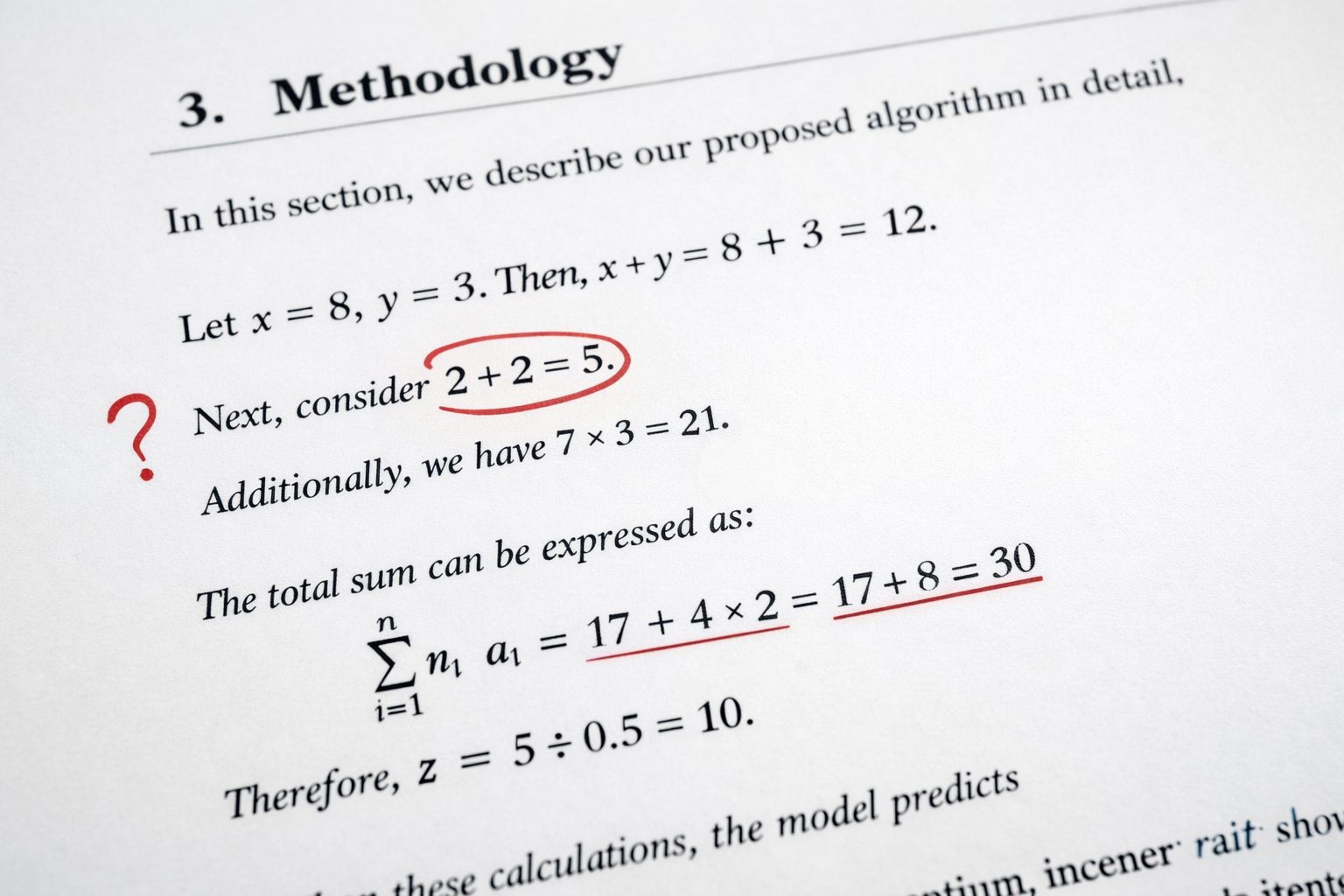

Błędy obejmują niepoprawne wzory, błędne obliczenia, niewłaściwe wykresy oraz nieścisłości metodologiczne. To problemy znacznie poważniejsze niż same halucynacje bibliograficzne, ponieważ mogą bezpośrednio podważać wyniki badań i ich dalsze wykorzystanie.

Konsekwencje dla świata nauki

Środowisko akademickie nie podlega tak surowym sankcjom jak prawnicy, którzy w ostatnich latach mierzyli się z konsekwencjami setek błędnych cytowań generowanych przez AI w dokumentach sądowych. Jednak skutki dla nauki mogą być długofalowe. Utrata zaufania do publikacji, konieczność wycofywania prac oraz spadek wiarygodności całych konferencji to realne zagrożenia.

Według danych International Association of Scientific, Technical & Medical Publishers w 2024 r. opublikowano 5,7 mln artykułów naukowych, wobec 3,9 mln pięć lat wcześniej. Tak szybki wzrost wolumenu publikacji wymusza zmianę modeli wydawniczych i podejścia do weryfikacji treści, zwłaszcza w epoce AI wspomagającej pisanie.

Niektórzy wydawcy rozważają włączenie narzędzi wykrywających halucynacje do standardowych procedur redakcyjnych. Jednocześnie pojawiają się rozwiązania, które utrudniają identyfikację treści generowanych przez AI, co dodatkowo komplikuje sytuację.

Wyścig pomiędzy narzędziami kontroli a coraz bardziej zaawansowanymi modelami generatywnymi dopiero się rozpoczyna. Jego wynik może zdecydować o tym, czy tempo publikacji w nauce da się pogodzić z utrzymaniem jakości i rzetelności badań.