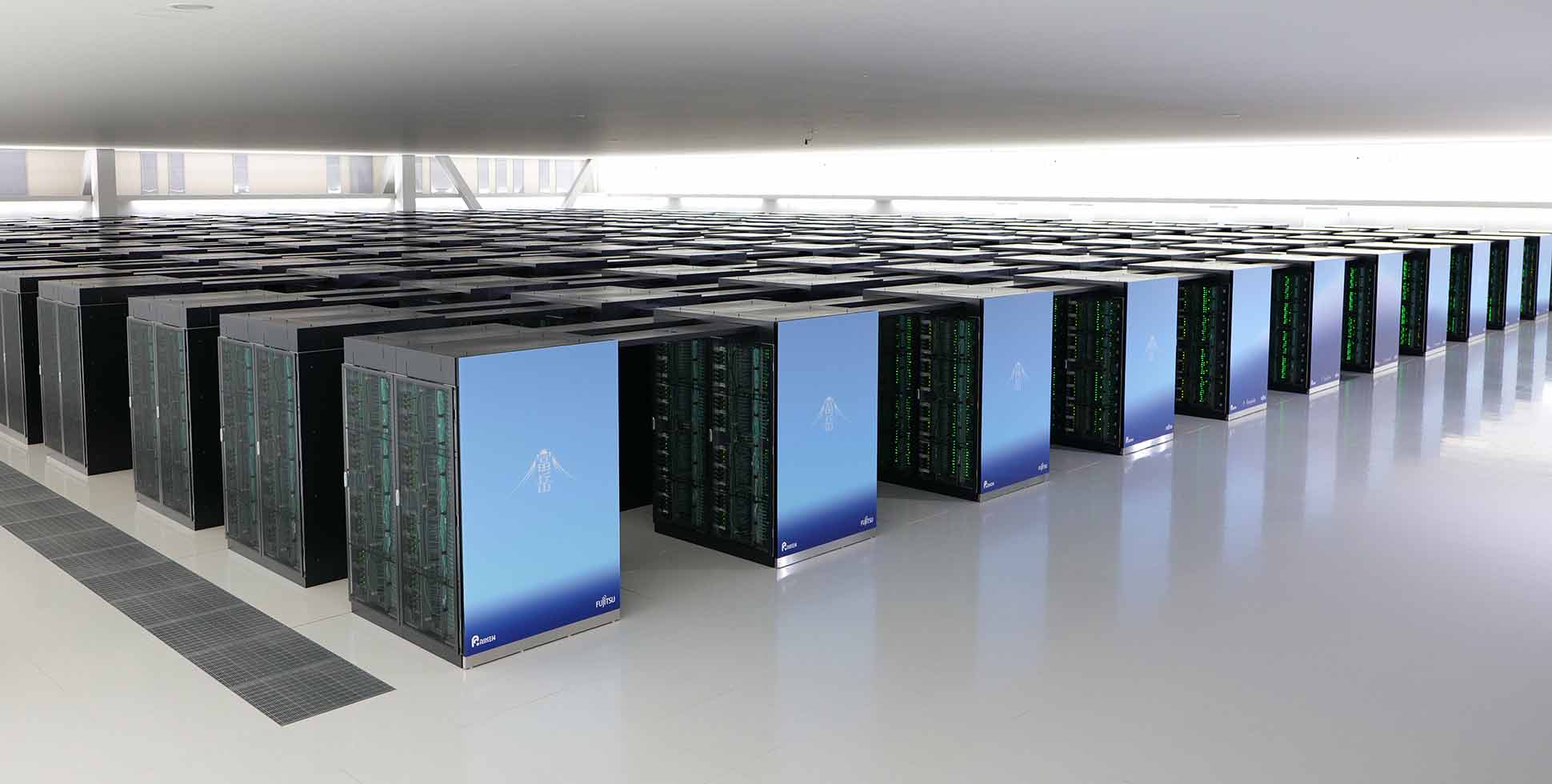

Fujitsu wykorzystuje superkomputer Fugaku do trenowania LLM

Chociaż superkomputer Fugaku firmy Fujitsu nie jest już najszybszą maszyną na świecie z listy Top 500 superkomputerów, to nadal jest to bardzo wydajny system, a wszechstronność procesora A64FX pozwala na wykorzystanie go do różnych obciążeń, takich jak sztuczna inteligencja.

W tym tygodniu Fujitsu wydało Fugaku-LLM, duży model językowy z zaawansowanymi możliwościami przetwarzania języka japońskiego, który jest przeznaczony zarówno do badań, jak i zastosowań komercyjnych.

Fugaku-LLM firmy Fujitsu został przeszkolony przy użyciu 380 miliardów tokenów w 13 824 węzłach superkomputera Fugaku opartego na procesorze A64FX, który obsługuje tryby FP64, FP32, FP16 i INT8 dla różnych zastosowań sztucznej inteligencji i konwencjonalnych superkomputerów. Szkolenie Fugaku-LLM naturalnie wykorzystało techniki rozproszonego uczenia równoległego zoptymalizowane pod kątem architektury superkomputera i połączenia Tofu D.

To obszerne szkolenie skoncentrowane na języku japońskim odróżnia go od innych japońskich modeli, które były szkolone głównie na angielskich zbiorach danych. W rezultacie Fugaku-LLM może pochwalić się doskonałą biegłością w języku japońskim, osiągając średni wynik 5,5 w japońskim MT-Bench. To najwyższy wynik wśród ogólnodostępnych modeli wytrenowanych na oryginalnych danych z Japonii. Szczególnie wyróżnia się w naukach humanistycznych i społecznych, osiągając imponujący wynik 9,18, według Fujitsu.

Inicjatywa Fugaku-LLM była napędzana przez współpracę wiodących japońskich instytucji, w tym Tokyo Institute of Technology, Tohoku University, Fujitsu Limited, RIKEN, Nagoya University, CyberAgent i Kotoba Technologies. Jednym z powodów współpracy był niedobór procesorów graficznych zwykle wykorzystywanych do trenowania i wnioskowania modeli sztucznej inteligencji. Innym powodem było to, że model mógł być używany ze 150-rdzeniowym procesorem centrów danych Monaka nowej generacji firmy Fujitsu, zoptymalizowanym zarówno pod kątem obciążeń AI, jak i HPC.

Fugaku-LLM jest teraz dostępny zarówno do celów akademickich, jak i komercyjnych na określonych warunkach licencyjnych z GitHub i Hugging Face (choć Fujitsu nie podało żadnych linków). Ponadto od 10 maja 2024 r. będzie on również oferowany za pośrednictwem portalu badawczego Fujitsu.