Google twierdzi, że dane publiczne są uczciwą ceną za szkolenie sztucznej inteligencji

Google zaktualizowało swoją politykę prywatności, aby potwierdzić, że pobiera publiczne dane z Internetu w celu szkolenia swoich modeli i usług sztucznej inteligencji – w tym chatbota Bard i produktów hostowanych w chmurze.

Drobny druk w sekcji badań i rozwoju brzmi teraz następująco: “Google wykorzystuje informacje w celu ulepszania naszych usług oraz opracowywania nowych produktów, funkcji i technologii, które przynoszą korzyści naszym użytkownikom i społeczeństwu. Na przykład wykorzystujemy publicznie dostępne informacje, aby pomóc w szkoleniu modeli sztucznej inteligencji Google oraz tworzeniu produktów i funkcji, takich jak Tłumacz Google, Bard i możliwości sztucznej inteligencji w chmurze”.

Co ciekawe, pracownicy firmy spoza USA nie mogli zobaczyć cytowanego tekstu. Dopiero powyższa wersja PDF polityki Google stwierdza: “Możemy gromadzić informacje, które są publicznie dostępne online lub z innych źródeł publicznych, aby pomóc w szkoleniu modeli sztucznej inteligencji Google oraz tworzeniu produktów i funkcji, takich jak Tłumacz Google, Bard i funkcje sztucznej inteligencji w chmurze”.

Zmiany określają zakres szkolenia Google w zakresie sztucznej inteligencji. Wcześniej polityka wspominała tylko o “modelach językowych” i odnosiła się do Tłumacza Google. Sformułowanie zostało jednak zmienione na “modele AI” i obejmuje Bard oraz inne systemy zbudowane jako aplikacje na platformie chmurowej.

Rzecznik Google powiedział, że aktualizacja nie zmieniła zasadniczo sposobu, w jaki Google trenuje swoje modele AI.

“Nasza polityka prywatności od dawna jest przejrzysta, że Google wykorzystuje publicznie dostępne informacje z otwartej sieci do trenowania modeli językowych dla usług takich jak Tłumacz Google. Najnowsza aktualizacja po prostu wyjaśnia, że nowsze usługi, takie jak Bard, są również uwzględnione. Włączamy zasady prywatności i zabezpieczenia do rozwoju naszych technologii AI, zgodnie z naszymi Zasadami AI” – powiedział rzecznik w oświadczeniu.

Deweloperzy od lat przeszukują internet, albumy ze zdjęciami, książki, sieci społecznościowe, kody źródłowe, muzykę, artykuły i nie tylko, aby gromadzić dane szkoleniowe dla systemów sztucznej inteligencji. Proces ten jest kontrowersyjny, biorąc pod uwagę, że materiały są zazwyczaj chronione prawami autorskimi, warunkami użytkowania i licencjami, a cała ta procedura doprowadziła do procesów sądowych.

Niektórzy użytkownicy są niezadowoleni, że ich własne treści są nie tylko wykorzystywane do tworzenia systemów uczenia maszynowego, które powielają ich pracę, a tym samym potencjalnie zagrażają ich dochodom, ale także, że wyniki modeli są zbyt bliskie naruszenia praw autorskich lub licencji, na przykład poprzez zwracanie tych danych szkoleniowych bez zmian.

Twórcy sztucznej inteligencji mogą argumentować, że ich wysiłki mieszczą się w ramach dozwolonego użytku, a wyniki modeli są nową formą pracy, a nie kopią oryginalnych danych szkoleniowych. Problem ten jest przedmiotem gorących dyskusji.

Przedstawiciel Google odmówił wyjaśnienia, czy gigant reklamowy i wyszukiwarkowy mógłby gromadzić dane publiczne lub posty w mediach społecznościowych, które mogą być chronione prawami autorskimi lub rozpowszechniane na określonych warunkach licencyjnych w celu szkolenia swoich systemów.

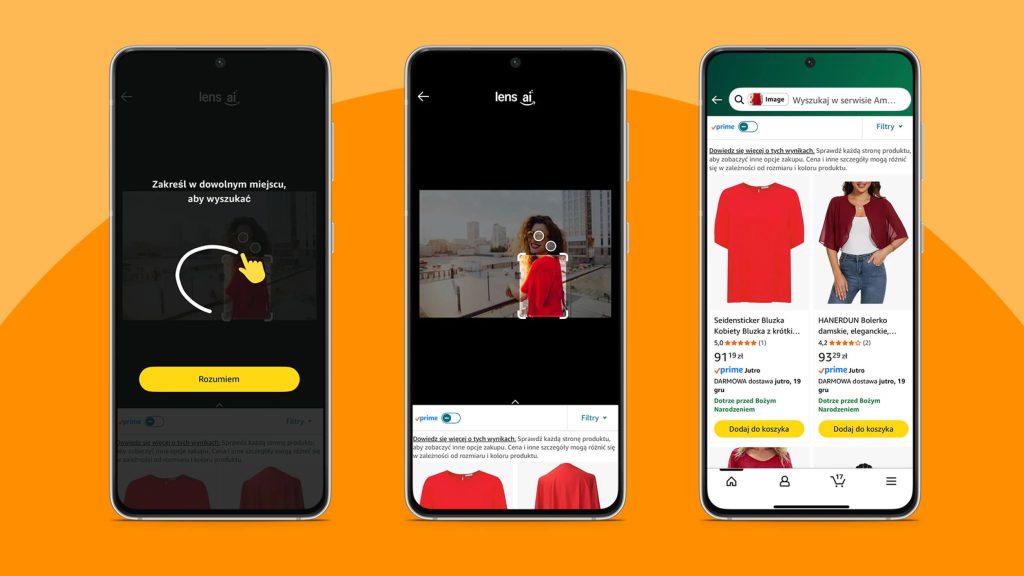

Teraz, gdy ludzie są lepiej poinformowani o tym, jak trenowane są modele sztucznej inteligencji, niektóre firmy internetowe zaczęły pobierać opłaty od programistów za dostęp do swoich danych. Na przykład Stack Overflow, Reddit i Twitter wprowadziły w tym roku opłaty lub nowe zasady dostępu do swoich treści za pośrednictwem interfejsów API. Inne witryny, takie jak Shutterstock i Getty, zdecydowały się licencjonować swoje obrazy twórcom modeli AI i nawiązały współpracę z takimi firmami jak Meta i Nvidia.