GTC 2025: SK Hynix prezentuje SOCAMM i HBM4 – obiecujące rozwiązania układów pamięci dla AI

SK Hynix zaprezentował nowe technologie układów pamięci dedykowane dla AI, w tym moduły SOCAMM i HBM4. Firma chce podkreślić w ten sposób swoją przewagę nad konkurencją, w tym nad Samsungiem i Micronem.

SK Hynix dynamicznie rozwija innowacyjne produkty dla najwydajniejszych układów obliczeniowych, w tym dla GPU NVIDII przeznaczonych dla centrów danych. Na GTC 2025 w San Jose firma zaprezentowała flagowe rozwiązania: 12-warstwowe HBM3E oraz SOCAMM – nowy standard pamięci opracowany we współpracy z NVIDIĄ. SOCAMM, oparty na technologii CAMM, wykorzystuje niskopoborową pamięć DRAM, zwiększając pojemność i wydajność w zadaniach AI przy zachowaniu efektywności energetycznej.

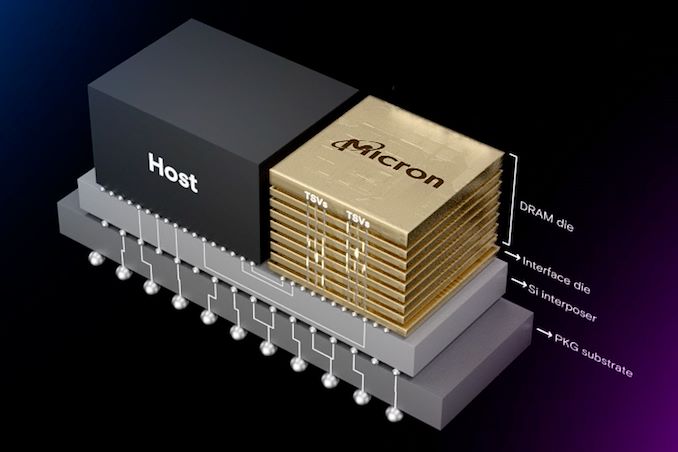

Podczas prezentacji pojawiły się również 12-warstwowe układy HBM3E, które SK Hynix dostarcza NVIDII do układów GB300 Blackwell. Cóż, trzeba przyznać, że tutaj firma faktycznie wyprzedziła konkurencję – masowa produkcja HBM3E rozpoczęła się już we wrześniu 2024 roku.

Kluczowym elementem prezentacji były chyba jednak 12-warstwowe układy HBM4, nowa generacja pamięci, która jest obecnie w fazie próbnych dostaw do klientów, w tym do NVIDII, gdzie trafi do GPU nowej serii Rubin. HBM4 oferuje 36 GB pojemności na stos i przepustowość 2 TB/s. Co więcej, przepustowość ta jest aż 60% więlksza niż w poprzedniej generacji. Masowa produkcja HBM4, wykorzystująca proces TSMC 3 nm, rozpocznie się w drugiej połowie 2025 roku.