Intel „Diamond Rapids” – Nowa generacja Xeonów ze 192 rdzeniami i 500 W TDP

Intel przygotowuje rewolucję w segmencie procesorów serwerowych. Nowa platforma „Oak Stream” z układami Xeon „Diamond Rapids” zaoferuje nawet 192 rdzenie, rekordową przepustowość pamięci i współczynnik TDP sięgający 500 W. Premiera zaplanowana na 2026 rok może wyznaczyć nowy standard wydajności w centrach danych i chmurze obliczeniowej.

Nowa platforma Oak Stream – fundament przyszłości serwerów

Intel ogłosił, że jego kolejna generacja serwerowych procesorów Xeon, oparta na platformie o nazwie „Oak Stream”, trafi na rynek w 2026 roku. Układy te będą obsługiwać dwa warianty konfiguracji pamięci DDR5 – 8-kanałowy i aż 16-kanałowy, co stanowi znaczący wzrost względem obecnych rozwiązań. Wysokoprzepustowe moduły MRDIMM Gen 2 umożliwią transfery rzędu 12 800 MT/s na kanał, zapewniając nawet najbardziej wymagającym rdzeniom „Panther Cove” stały dostęp do danych.

Nowa generacja obsłuży także PCI Express 6.0, co pozwoli na bezpośrednie podłączenie najnowocześniejszych akceleratorów i pamięci persistent memory. Architekturę przewidziano do pracy w konfiguracjach jedno-, dwu- i czterosocketowych (LGA 9324), co otwiera drzwi do skalowania mocy obliczeniowej nawet do 768 rdzeni w jednej obudowie serwerowej przy poborze mocy około 2000 W.

Diamond Rapids – wydajność i elastyczność na niespotykanym dotąd poziomie

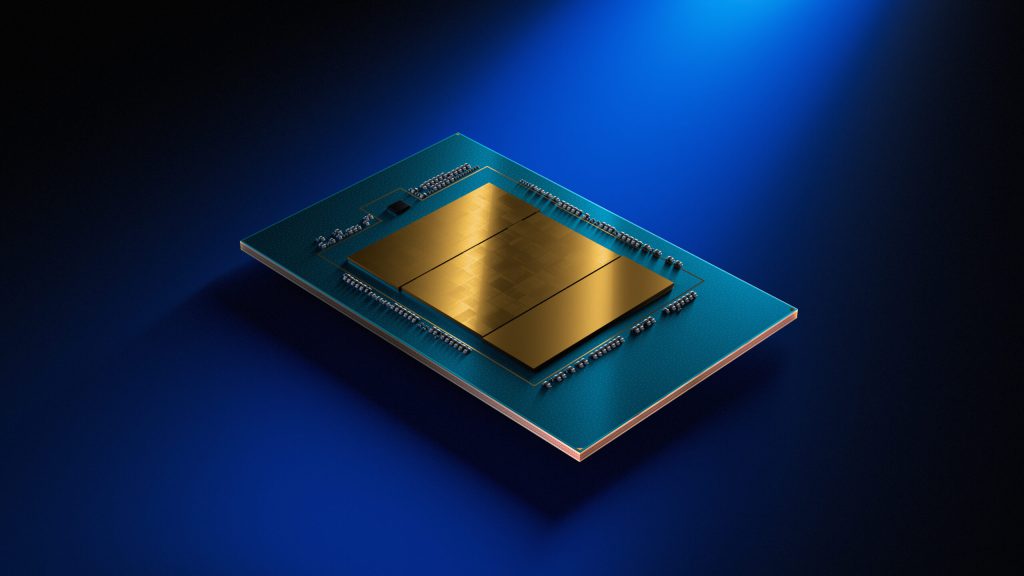

Sercem platformy Oak Stream będzie układ SoC „Diamond Rapids”, bazujący na litografii Intel 18A. W topowych wariantach procesory zaoferują do 192 rdzeni P (Performance), rozłożonych na cztery elementy obliczeniowe po 48 rdzeni każdy. Takie podejście umożliwia nie tylko rekordową liczbę rdzeni w jednym CPU, ale również lepsze rozpraszanie ciepła – szczególnie istotne przy deklarowanym TDP na poziomie aż 500 W dla jednego gniazda.

Wśród nowości technologicznych znajdziemy wsparcie dla instrukcji Intel APX oraz istotne usprawnienia w obliczeniach macierzowych (AMX), które będą efektywniejsze i szybsze. Co istotne z punktu widzenia AI i HPC, procesory natywnie obsłużą formaty liczb zmiennoprzecinkowych takie jak TF32 (używany przez NVIDIĘ) i FP8, wykorzystywane m.in. w uczeniu maszynowym.

Intel deklaruje, że większość podstawowych operacji inferencyjnych dla mniejszych modeli AI będzie można realizować wyłącznie na CPU, bez konieczności sięgania po kosztowne akceleratory GPU. To istotny argument dla firm budujących elastyczne, wielozadaniowe klastry obliczeniowe.