Meta prezentuje nowe modele AI z serii Llama 4

Meta ogłosiła wprowadzenie na rynek najnowszej serii modeli sztucznej inteligencji Llama 4, obejmującej Llama 4 Scout, Llama 4 Maverick oraz zapowiedzianego Llama 4 Behemoth. Te zaawansowane modele multimodalne potrafią przetwarzać różnorodne formaty danych, takie jak tekst, obrazy, wideo i dźwięk, co czyni je niezwykle wszechstronnymi narzędziami w dziedzinie AI.

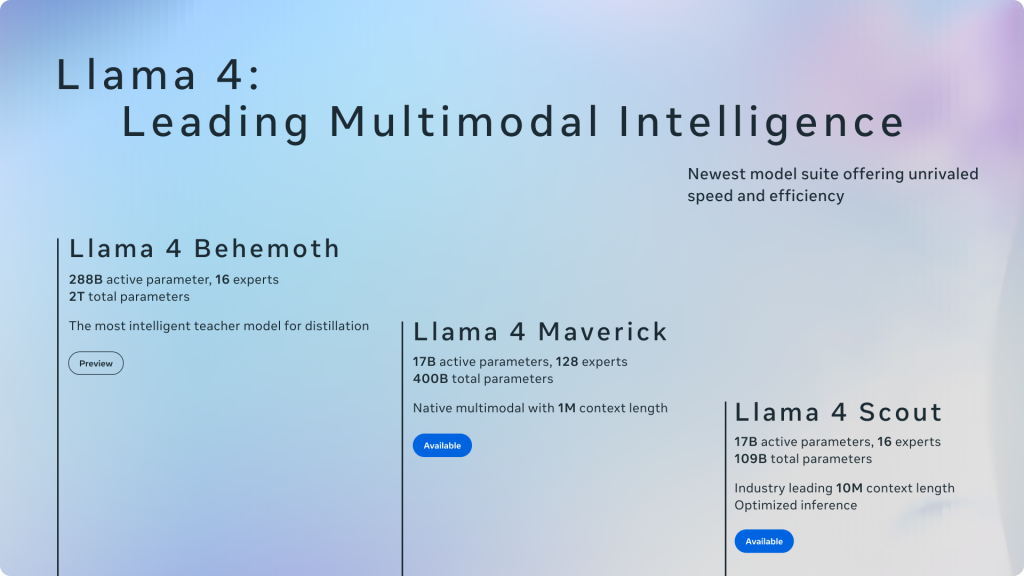

Charakterystyka modeli Llama 4

Llama 4 Scout to kompaktowy model zaprojektowany do działania na pojedynczym procesorze graficznym Nvidia H100. Posiada okno kontekstowe o pojemności 10 milionów tokenów, co pozwala mu przewyższać konkurencyjne modele, takie jak Gemma 3 od Google czy Mistral 3.1, w różnych testach porównawczych. Z kolei Llama 4 Maverick to większy model, porównywalny pod względem wydajności z GPT-4o od OpenAI oraz DeepSeek-V3 w zadaniach związanych z kodowaniem i rozumowaniem, przy jednoczesnym wykorzystaniu mniejszej liczby aktywnych parametrów. Oba modele są dostępne jako open-source, co umożliwia szerokie zastosowanie i rozwój przez społeczność deweloperów.

Meta zapowiedziała również Llama 4 Behemoth, model o imponującej liczbie 288 miliardów aktywnych parametrów (łącznie 2 biliony). Behemoth ma pokonać konkurencyjne modele, takie jak GPT-4.5 i Claude Sonnet 3.7, w testach z zakresu nauk ścisłych. Obecnie model ten jest w fazie szkolenia.

Innowacyjna architektura i możliwości

Modele z serii Llama 4 wykorzystują architekturę mixture of experts (MoE), która pozwala na efektywne zarządzanie zasobami poprzez aktywowanie tylko niezbędnych części modelu w zależności od konkretnego zadania. Dzięki temu osiągają one wysoką wydajność przy mniejszym zużyciu mocy obliczeniowej. Ponadto, Llama 4 Scout i Maverick zostały zaprojektowane z myślą o natywnej multimodalności, co oznacza, że od podstaw integrują różne typy danych, umożliwiając bardziej zaawansowane i elastyczne zastosowania.

Integracja i dostępność

Nowe modele Llama 4 zintegrowano z asystentem Meta AI, dostępnym na platformach takich jak WhatsApp, Messenger, Instagram oraz na stronie internetowej Meta.ai. Dzięki temu użytkownicy mogą korzystać z zaawansowanych funkcji AI w codziennej komunikacji i interakcji z aplikacjami. Więcej o planach Meta mamy dowiedzieć się na nadchodzącej konferencji LlamaCon, zaplanowanej na 29 kwietnia.