Meta prezentuje ulepszone chipy MTIA AI, które oferują 3,5-krotny wzrost wydajności

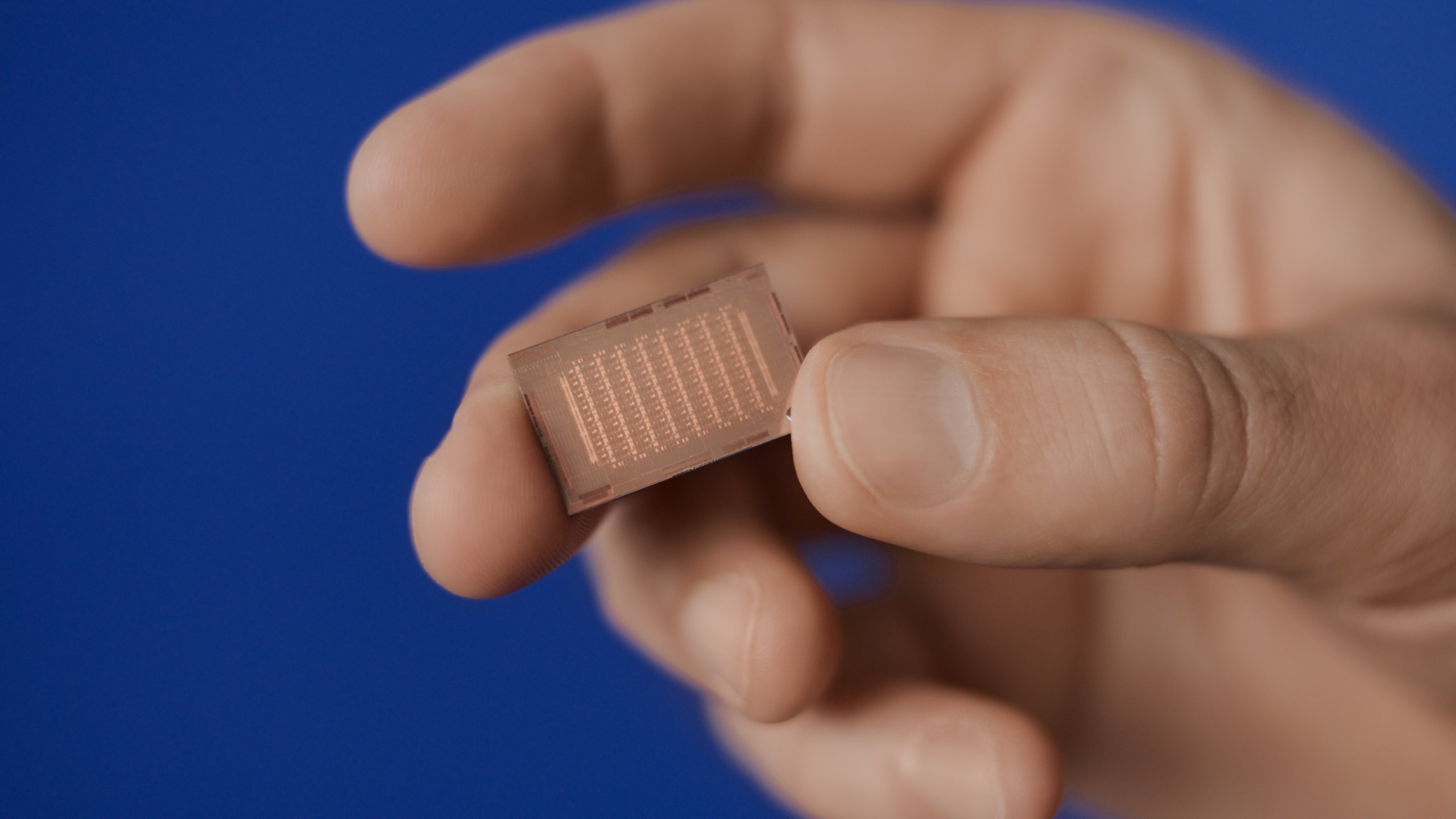

Meta udostępniła szczegółowe informacje na temat nowej generacji Meta Training and Inference Accelerator (MTIA), czyli niestandardowych chipów zaprojektowanych z myślą o określonych obciążeniach Meta AI.

Firma stwierdziła, że najnowsza wersja jej chipów wykazuje znaczną poprawę wydajności w porównaniu z MTIA v1 i jest już wykorzystywana do obsługi produktów i usług generatywnej sztucznej inteligencji, takich jak rankingi i modele reklam rekomendacyjnych Meta.

Zaktualizowane współczynniki MTIA są oparte na węzłach 5 nm. Chipy pracują z częstotliwością 1,35 GHz, mają projektową moc cieplną 90 W i mierzą około 421 milimetrów kwadratowych. MTIA v2 charakteryzuje się również ulepszoną architekturą sieci na chipie i zawiera 256 MB pamięci wbudowanej i przepustowość pamięci na chipie 2,7 TB/s, podczas gdy pojemność pamięci lokalnej wynosi 384 KB na element przetwarzający (PE) i 1 TB/s przepustowości łącza.

Meta stwierdziła, że te ulepszenia zapewniają 3,5-krotny wzrost wydajności obliczeń gęstych w porównaniu z MTIA v1 i 7-krotny wzrost wydajności obliczeń rzadkich. Firma potroiła także rozmiar lokalnej pamięci PE, podwoiła wbudowaną pamięć SRAM, zwiększyła jej przepustowość 3,5-krotnie i podwoiła pojemność LPDDR5.

Akcelerator wnioskowania jest częścią szerszego programu rozwoju pełnego stosu firmy Meta dla niestandardowego, specyficznego dla domeny krzemu, który uwzględnia unikalne obciążenia i systemy. Firma podała, że MTIA została już wdrożona w jej centrach danych i obecnie obsługuje modele w produkcji.

Zwrot firmy Meta w kierunku sztucznej inteligencji i zmiany chipów zmusił firmę do przeprojektowania swoich centrów danych z myślą o procesorach graficznych i innych akceleratorach oraz anulowania wielu projektów.

Firma podała w lutym, że spodziewa się wydać 37 miliardów dolarów na infrastrukturę cyfrową w 2024 roku.