Microsoft prezentuje Maia 200. Chip do inferencji AI już pracuje w centrach danych

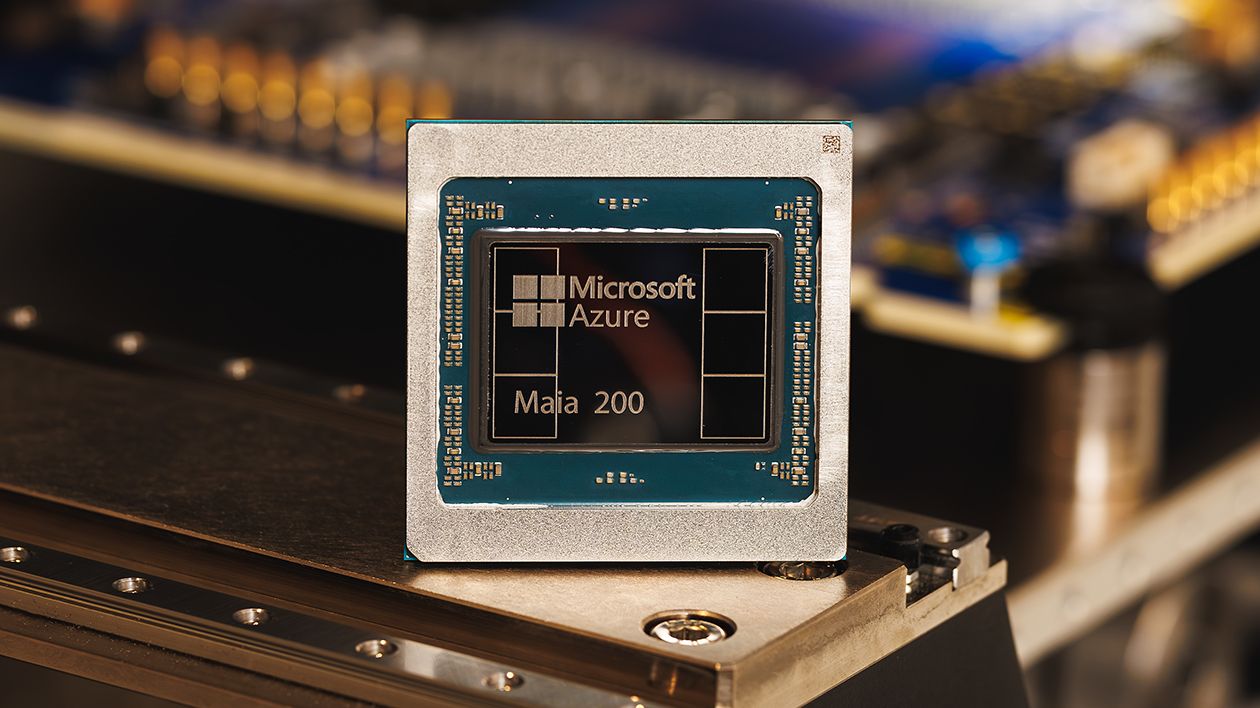

Microsoft zaprezentował Maia 200, własny układ do inferencji sztucznej inteligencji zaprojektowany z myślą o dużych modelach językowych i zastosowaniach wielomodalnych. Chip, produkowany w technologii 3 nm, został już wdrożony w jednym z amerykańskich regionów centrów danych Azure. To kolejny krok firmy w stronę większej niezależności sprzętowej w wyścigu o skalowalną i tańszą AI.

Własny akcelerator pod potrzeby AI

Maia 200 to akcelerator inferencyjny zaprojektowany przez Microsoft i produkowany w fabrykach TSMC w procesie 3 nm. Układ oferuje około 10 petaflopsów mocy obliczeniowej FP4 oraz 5 petaflopsów FP8 przy TDP na poziomie 750 W dla całego SoC. Kluczowym elementem jest podsystem pamięci, który obejmuje 216 GB HBM3e o przepustowości 7 Tb/s oraz 272 MB pamięci SRAM na chipie, wspieranej przez dedykowane silniki transferu danych.

Microsoft podkreśla, że Maia 200 zapewnia trzykrotnie wyższą wydajność FP4 niż najnowsze akceleratory konkurencyjnych hyperskalerów, w tym Amazon Trainium3 oraz siódmej generacji TPU Ironwood od Google. Według deklaracji producenta nowy chip oferuje także o 30% lepszy stosunek wydajności do kosztu w porównaniu z dotychczasowym sprzętem wykorzystywanym w infrastrukturze Azure.

Sieć, chłodzenie i skalowanie

Istotnym elementem projektu Maia 200 jest dwupoziomowa architektura skalowania oparta na standardowym Ethernecie. Układ zapewnia 2,8 Tb/s dwukierunkowej przepustowości scale up. Cztery akceleratory mogą być połączone bezpośrednio bez przełączników, co ma poprawiać efektywność inferencji. Ten sam protokół komunikacyjny Maia AI Transport służy do łączenia w obrębie szafy, między szafami i w całych klastrach.

Chip zaprojektowano z myślą o bezpośredniej integracji z infrastrukturą centrów danych Microsoftu, w tym z zamkniętym obiegiem chłodzenia cieczą drugiej generacji opartym na wymiennikach ciepła. Jak podkreśla firma, czas od pierwszego krzemu do instalacji w szafach centrów danych udało się skrócić o ponad połowę względem porównywalnych programów infrastrukturalnych.

Maia 200 w Azure i modele językowe

Microsoft potwierdził, że Maia 200 działa już w regionie US Central w pobliżu Des Moines w stanie Iowa. Kolejnym wdrożeniem ma być region US West 3 w okolicach Phoenix w Arizonie. Układ został zaprojektowany z myślą o obsłudze dużych modeli językowych, w tym rozwiązań tworzonych we współpracy z OpenAI oraz modeli rozwijanych wewnętrznie przez Microsoft.

To pierwszy chip Maia zaprojektowany specjalnie z myślą o dużych modelach językowych, takich jak te od OpenAI, oraz o naszych własnych modelach – powiedział Scott Guthrie, wiceprezes wykonawczy ds. chmury i AI w Microsoft.

Inwestujemy zarówno w hiperoptymalne centra danych, które nazywamy fabrykami tokenów, jak i w własne rozwiązania krzemowe, aby uzyskać najlepszy możliwy stosunek tokenów do wata i dolara.