NetApp i Lenovo oferują rozwiązanie infrastruktury konwergentnej zoptymalizowane pod kątem GenAI

NetApp i Lenovo są połączone ścisłą współpracą od ponad pięciu lat, a obecnie przenoszą ją na wyższy poziom, wprowadzając proste, ekonomiczne i wydajne rozwiązanie sztucznej inteligencji dla przedsiębiorstw.

Nowe rozwiązanie w zakresie infrastruktury konwergentnej będzie obsługiwać mikrousługi wnioskowania NVIDIA NIM, platformę oprogramowania NVIDIA AI Enterprise do tworzenia i wdrażania generatywnej sztucznej inteligencji oraz generację wspomaganą odzyskiwaniem (RAG), aby umożliwić klientom wykorzystanie ich prywatnych, zastrzeżonych danych na potrzeby sztucznej inteligencji bez konieczności stosowania modelu na dużą skalę szkolenie.

Generatywna sztuczna inteligencja stworzyła organizacjom szerokie możliwości, choć wiele osób może mieć wrażenie, że AI jest poza zasięgiem ze względu na koszty, złożoność integracji i czas wdrożenia. Tymczasem wstępnie zbudowane duże modele językowe (LLM) często nie są przeszkolone w zakresie najbardziej aktualnych lub odpowiednich danych, których organizacje potrzebują do generowania cennych spostrzeżeń lub skutecznej automatyzacji rutynowych zadań.

NetApp jest liderem w dziedzinie przechowywania danych nieustrukturyzowanych od ponad trzydziestu lat, a większość nieustrukturyzowanych danych przedsiębiorstw na całym świecie jest przechowywana w pamięci masowej NetApp.

Odblokowanie pełnej wartości tych danych wymaga wyjścia daleko poza szkolenie z podstawowych modeli. Umożliwiając wnioskowanie i RAG, NetApp AIPod z wiodącą niezawodnością, jakością i wydajnością serwerów Lenovo sprawia, że łączenie mocy LLM z precyzyjnymi, aktualnymi i istotnymi informacjami o pamięci masowej NetApp jest płynne, proste i szybkie.

„NetApp AIPod z serwerami Lenovo ThinkSystem dla NVIDIA OVX przekształca sztuczną inteligencję przedsiębiorstwa, dostarczając wstępnie zintegrowane, wysokowydajne rozwiązanie, które przyspiesza wdrażanie i skalowanie generatywnych obciążeń AI – powiedział Sandeep Singh, starszy wiceprezes i dyrektor generalny Enterprise Storage w NetApp. – Dzięki naszej współpracy z firmami NVIDIA i Lenovo NetApp umożliwia organizacjom efektywniejsze wykorzystanie możliwości sztucznej inteligencji, zapewniając im możliwość skupienia się na tworzeniu wartości i wyciąganiu wniosków z danych bez konieczności budowania od podstaw infrastruktury sztucznej inteligencji i zarządzania nią”.

NetApp AIPod łączy niezawodne systemy pamięci masowej NetApp z hybrydowym zarządzaniem danymi w chmurze, w tym wysokowydajne serwery Lenovo ThinkSystem SR675 V3, wiodące platformy obsługujące architekturę OVX z certyfikatem NVIDIA z procesorami graficznymi NVIDIA L40S, a także technologię NVIDIA Spectrum-X Networking, zapewniając kompletne i bezproblemowe rozwiązanie infrastrukturalne usprawniające wdrażanie sztucznej inteligencji.

Dzięki temu rozwiązaniu klienci będą mogli przeprowadzać operacje AI RAG i wnioskowania na potrzeby zastosowań takich jak chatboty, zarządzanie wiedzą i rozpoznawanie obiektów. NetApp, we współpracy z Lenovo i NVIDIA, upraszcza wdrażanie sztucznej inteligencji, płynnie integrując się z ekosystemami, upraszczając operacje, przyspieszając wdrażanie i chroniąc infrastrukturę sztucznej inteligencji, umożliwiając organizacjom uwolnienie pełnego potencjału sztucznej inteligencji.

„Lenovo rozszerza naszą współpracę z NetApp i NVIDIA, aby zapewnić moc sztucznej inteligencji każdej firmie w ramach naszego ciągłego zaangażowania w udostępnianie i upraszczanie hybrydowej sztucznej inteligencji dla naszych wspólnych klientów” – powiedział Kirk Skaugen, prezes Lenovo Infrastructure Solutions Group. „Kiedy klienci wdrażają sztuczną inteligencję, wymagają krytycznej dla firmy dostępności, łatwości zarządzania i wydajności infrastruktury. NetApp AIPod z serwerami Lenovo ThinkSystem dla NVIDIA OVX zapewnia zoptymalizowane i sprawdzone rozwiązania, dzięki którym generatywna sztuczna inteligencja staje się bardziej dostępna dla firm każdej wielkości.

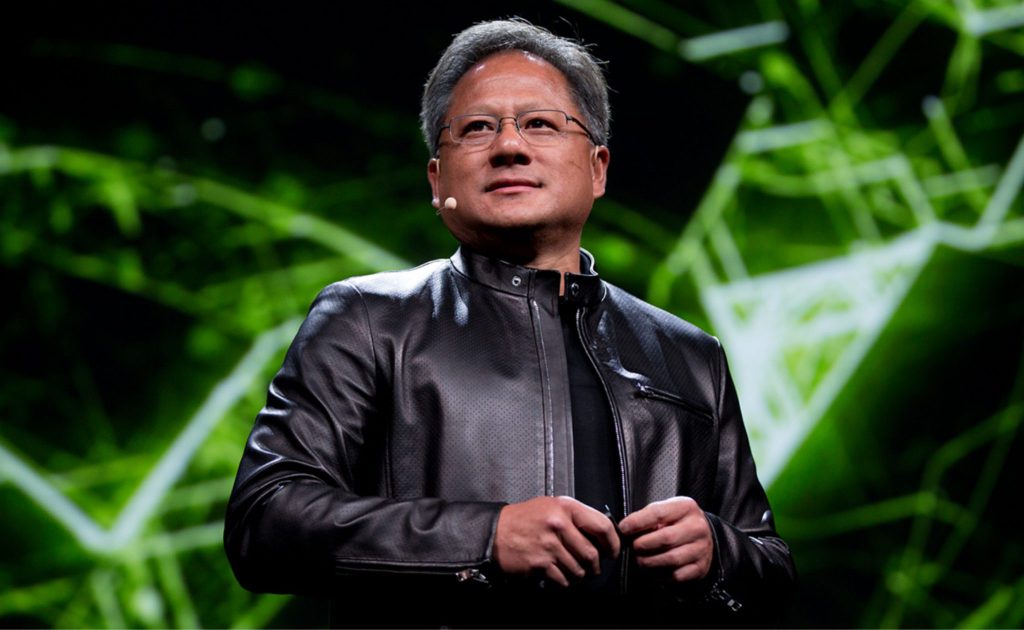

„Udostępnienie i skalowalność sztucznej inteligencji dla każdej branży jest ważniejsze niż kiedykolwiek – powiedział Bob Pette, wiceprezes ds. platform dla przedsiębiorstw w firmie NVIDIA. – NetApp AIPod z Lenovo dla NVIDIA OVX oferuje platformę gotową do obsługi sztucznej inteligencji, która jest wydajna i łatwa w użyciu, umożliwiając firmom wprowadzanie innowacji”.

NetApp AIPod z Lenovo dla NVIDIA OVX będzie dostępny latem 2024 r.