Nvidia AI Enterprise 4.0 z nowymi funkcjami związanymi z LLM i środowiskiem Kubernetes

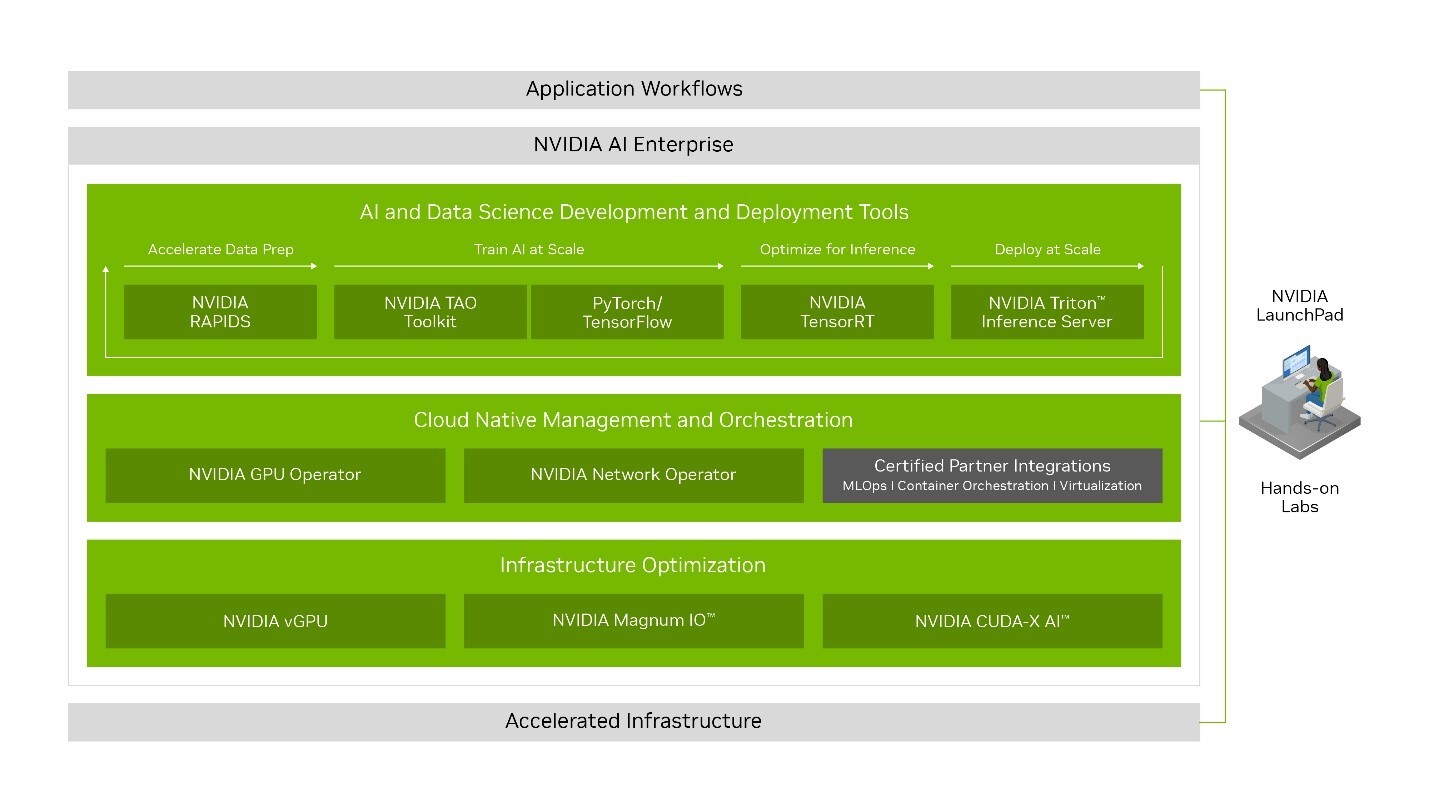

Nvidia wprowadza nową wersję swojego pakietu oprogramowania Nvidia AI Enterprise z nowymi funkcjonalnościami do tworzenia i dostosowywania aplikacji opartych na dużych modelach językowych oraz wdrażania modeli AI w kontenerach Kubernetes.

Wprowadzony w 2021 roku, Nvidia AI Enterprise dostarcza organizacjom Framework AI, czyli wstępnie przeszkolone modele i narzędzia, niezbędne m.in. do tworzenia i wdrażania aplikacji opartych na sztucznej inteligencji.

Nowe funkcje w Nvidia AI Enterprise 4.0 obejmują Nvidia NeMo, platformę w chmurze, umożliwiającą tworzenie, dostosowywanie i wdrażanie dużych modeli językowych do różnych zastosowań generatywnej sztucznej inteligencji, takich jak generowanie obrazów, wideo i modeli 3D na podstawie podpowiedzi tekstowych.

Nowa wersja będzie również zawierać Nvidia Triton Management Service, który automatyzuje proces wdrażania modeli AI poprzez wiele instancji Triton Inference Server w klastrach Kubernetes, aby zoptymalizować wydajność i wykorzystanie sprzętu.

Kolejną nadchodzącą funkcją jest Nvidia Base Command Manager Essentials, czyli oprogramowanie do zarządzania klastrami, które pomaga organizacjom “maksymalizować wydajność i wykorzystanie serwerów AI w centrach danych, środowiskach wielochmurowych i hybrydowych”.

Nvidia AI Enterprise została certyfikowana do działania na systemach certyfikowanych przez Nvidię, w tym na systemach Nvidia DGX oraz głównych platformach chmurowych, oraz nowo ogłoszonych stacjach roboczych Nvidia RTX.

Pakiet oprogramowania został zintegrowany z usługami ServiceNow, Snowflake i Dell Technologies, a także z partnerskimi usługami Amazon Web Services, Google Cloud i Microsoft Azure. Integracja jest również planowana z kilkoma narzędziami MLOps, w tym z Azure Machine Learning od Microsoftu, ClearML, Domino Data Labs, Run:AI oraz Weight & Biases.