NVIDIA Blackwell: Nowe GPU biją rekordy w treningu AI – nawet 2,2x szybciej niż Hopper

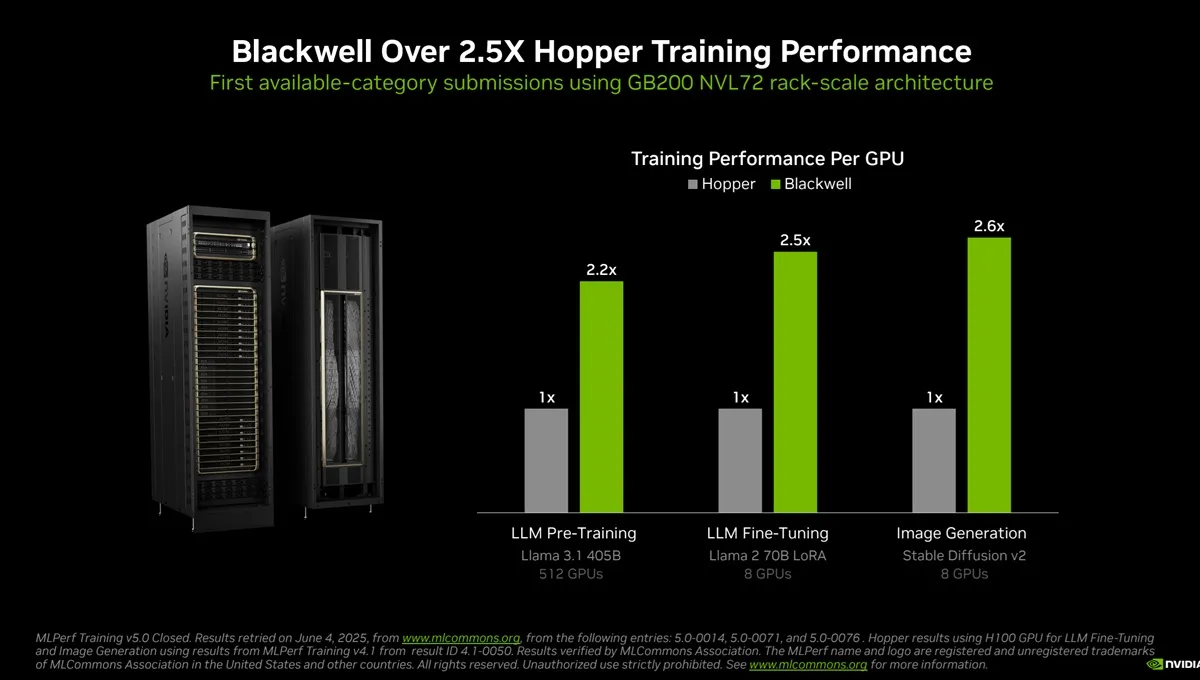

NVIDIA ogłosiła, że jej najnowsze układy Blackwell ustanowiły nowe rekordy wydajności w benchmarkach MLPerf v4.1 dla treningu dużych modeli językowych AI, osiągając nawet 2,2 razy lepsze wyniki niż poprzednia generacja Hopper.

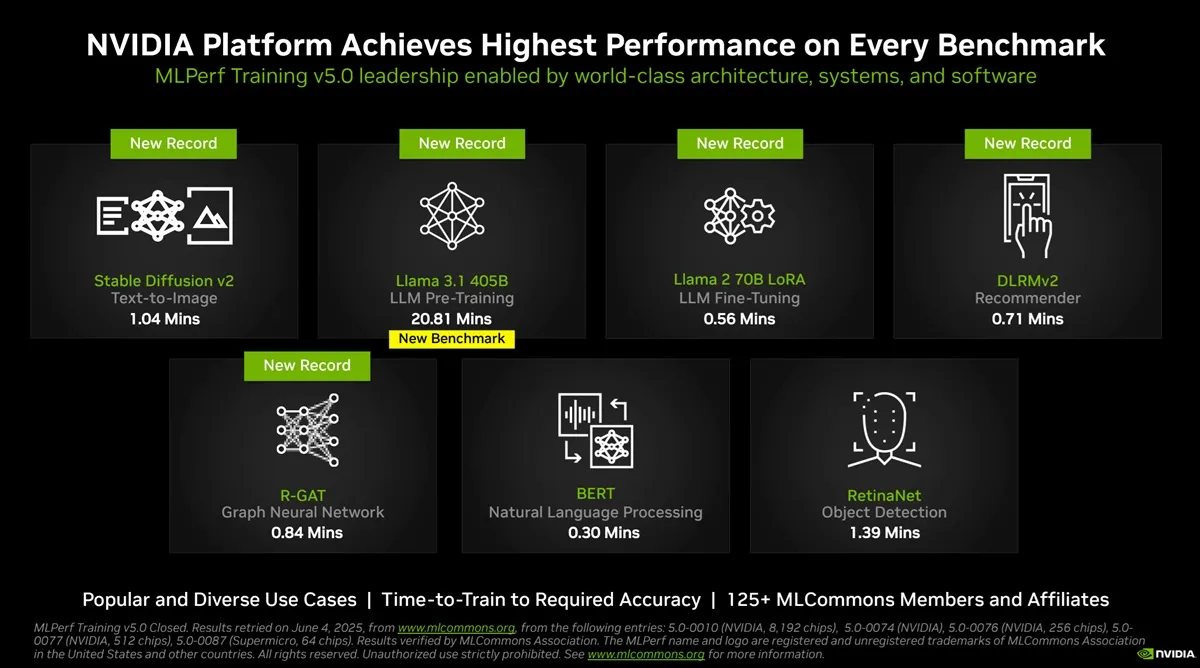

NVIDIA zaprezentowała oficjalne wyniki testów nowych układów Blackwell, które wyraźnie dominują w najnowszych branżowych benchmarkach MLPerf v4.1 dotyczących treningu dużych modeli językowych (LLM) i generatywnej AI. W testach, takich jak pre-trening GPT-3 175B i fine-tuning Llama 2 70B, Blackwell osiągnął nawet 2,2 razy wyższą wydajność na GPU niż dotychczasowy lider – Hopper H100.

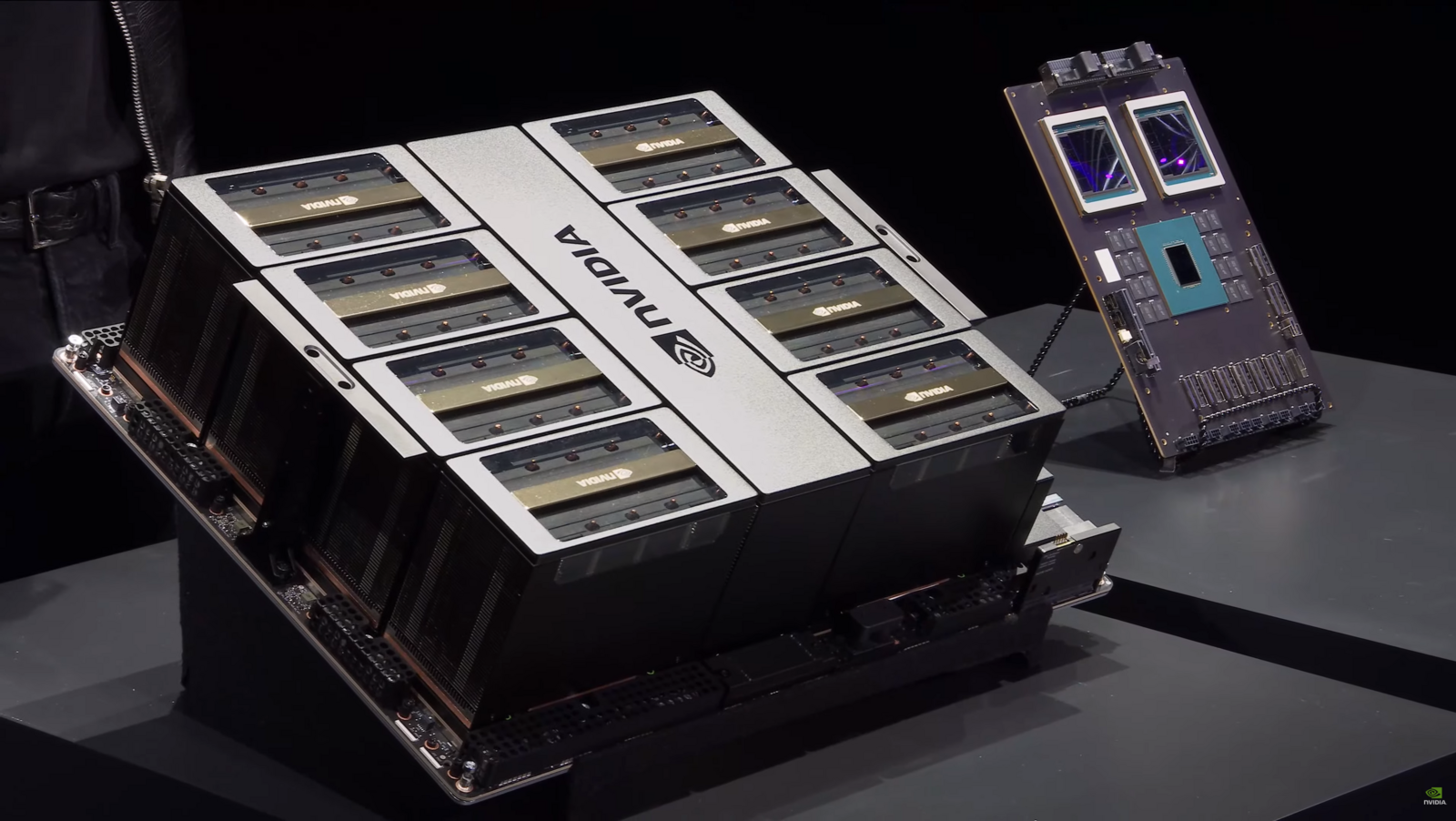

Blackwell to największy i najbardziej zaawansowany układ GPU w historii firmy, wyposażony w 208 miliardów tranzystorów, nową generację pamięci HBM3e oraz piątą generację łącza komunikacyjnego NVLink. Dzięki temu nowe systemy, takie jak DGX B200 i superkomputer Nyx, ustanowiły rekordy w siedmiu głównych kategoriach MLPerf, realizując te same zadania szybciej i z mniejszym zużyciem energii niż dotychczas.

W praktyce oznacza to, że zadania, które wcześniej wymagały 256 układów Hopper, można obecnie zrealizować na 64 GPU Blackwell bez utraty wydajności. To przełom dla firm i instytucji rozwijających generatywne modele AI, ponieważ skraca czas treningu i znacząco zmniejsza koszty infrastruktury.

Nowa architektura wprowadza także drugą generację silnika Transformer, zoptymalizowane rdzenie Tensor Core i nowe formaty precyzji, co pozwala efektywnie trenować modele o ponad 10 bilionach parametrów. Blackwell jest też pierwszym GPU z funkcjami confidential computing, chroniącymi dane i modele AI przed nieautoryzowanym dostępem.

NVIDIA podkreśla, że jesteśmy dopiero na początku cyklu życia Blackwell – kolejne optymalizacje i nowe systemy, takie jak GB200 NVL72, mają jeszcze bardziej zwiększyć wydajność i elastyczność dla AI „fabryk” przyszłości.