Nvidia ustanawia nowe rekordy wydajności w benchmarkach dzięki H200 Tensor Core i oprogramowaniu TensorRT-LLM

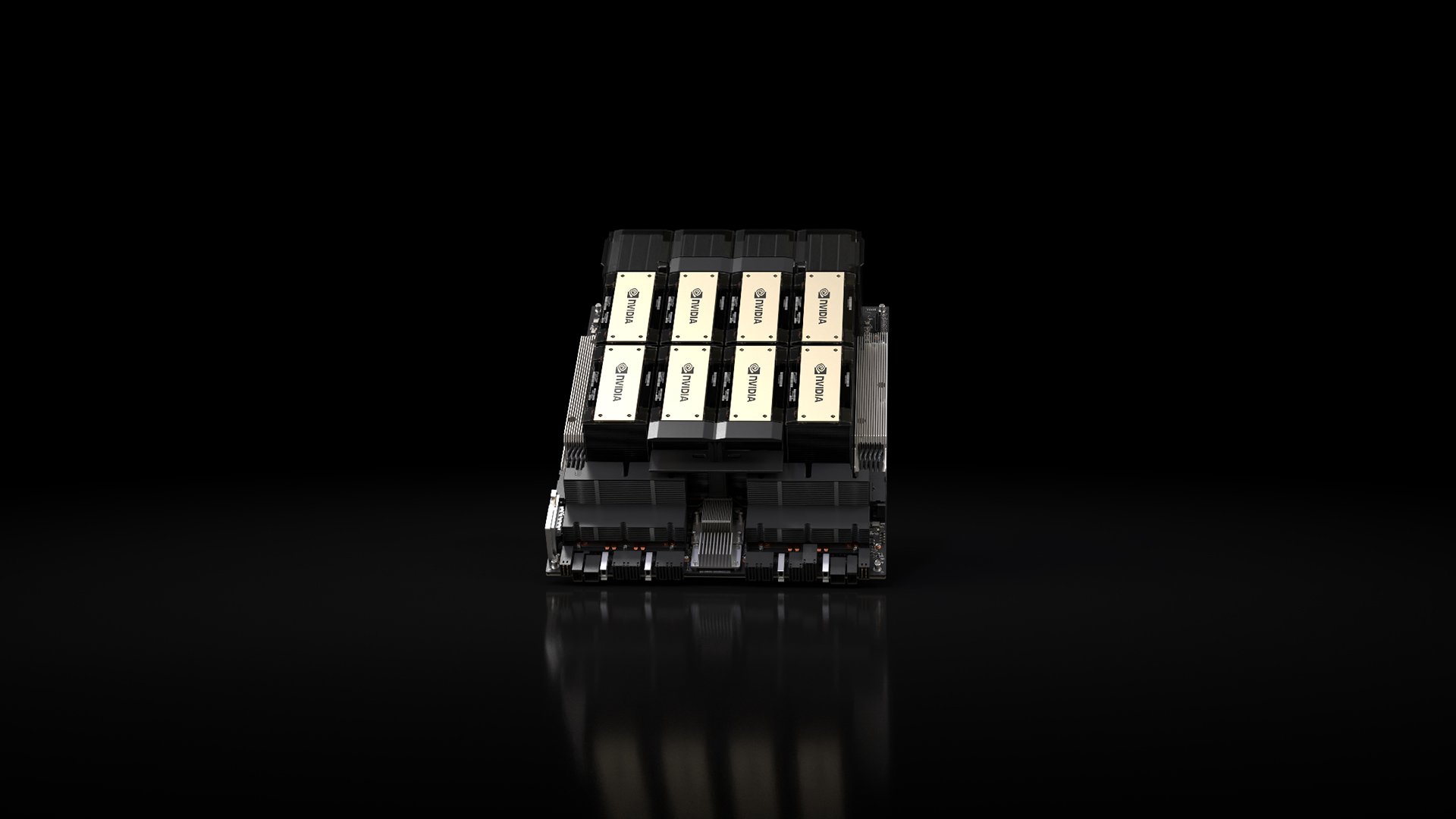

Firma Nvidia ustanowiła nowe rekordy wydajności w testach porównawczych MLPerf na swoim procesorze graficznym H200 Tensor Core i oprogramowaniu TensorRT-LLM.

MLPerf Inference to pakiet testów porównawczych, który mierzy wydajność wnioskowania w przypadkach użycia głębokiego uczenia się.

W najnowszej wersji pakietu testowego – MLPerf v4 – dodano dwa nowe obciążenia, które reprezentują generatywne przypadki użycia sztucznej inteligencji: test porównawczy dużego modelu językowego (LLM) oparty na Llama 2 70B firmy Meta oraz test zamiany tekstu na obraz oparty na Stable Diffusion XL. Nvidia ustanowiła rekordy wydajności w obu nowych obciążeniach, zapewniając najwyższą wydajność we wszystkich obciążeniach MLPerf Inference w kategorii centrów danych.

TensorRT-LLM firmy Nvidia to biblioteka oprogramowania typu open-source opracowana w celu podwojenia szybkości wnioskowania LLM na procesorach graficznych H100. W teście MLPerf v4 GPT-J, układy GPU H100 Tensor Core wykorzystujące bibliotekę TensorRT-LLM osiągnęły 2,4-krotny i 2,9-krotny wzrost szybkości w scenariuszach offline i serwerowym, w porównaniu do wydajności uzyskanej przez te układy GPU sześć miesięcy wcześniej w teście v3.1.

W teście porównawczym MLPerf Llama 2 70B, TensorRT-LLM firmy Nvidia działający na procesorach graficznych H200 Tensor Core zapewnił do 43% i 45% wyższą wydajność w porównaniu do H100, odpowiednio w scenariuszu serwerowym i offline, przy konfiguracji TDP 1000W. Nowy test porównawczy wykorzystuje największą wersję modelu Llama 2, który ma 70 miliardów parametrów i jest ponad dziesięciokrotnie większy niż model GPT-J LLM, który był używany w poprzednich testach porównawczych.

Jeśli chodzi o test porównawczy tekst-obraz Stable Diffusion XL, system 8-GPU Nvidia HGX H200 z układami GPU skonfigurowanymi pod kątem TDP 700 W osiągnął wydajność 13,8 zapytań/s i 13,7 próbek/s, odpowiednio w scenariuszu serwerowym i offline.

Gdy ten sam test został przeprowadzony przy użyciu systemu zawierającego osiem procesorów graficznych Nvidia L40S, system wykazał wydajność na poziomie 4,9 zapytania/s i 5 próbek/s, odpowiednio w scenariuszu serwerowym i offline.

Nvidia stwierdziła, że była to najlepsza wydajność osiągnięta przez jakiekolwiek rozwiązanie sprzętowe podczas testu Stable Diffusion XL.

Przemawiając przed upublicznieniem wyników, Dave Salvator, dyrektor ds. marketingu produktów w grupie obliczeń akcelerowanych Nvidia, powiedział, że wnioskowanie stało się dużą częścią działalności i biznesu Nvidii w zakresie centrów danych, zauważając, że w 2023 r. stanowiło około 40 procent przychodów firmy z centrów danych.

“Jest to coś naprawdę ważnego, ponieważ oznacza to, że nasza platforma jest nie tylko bardzo, bardzo wydajna, ale także bardzo wszechstronna, a to jest coś, co nasi klienci naprawdę doceniają i cenią” – powiedział Salvator.