NVIDIA wyposaża najszybszy na świecie procesor graficzny AI w najszybszą na świecie pamięć HBM3e

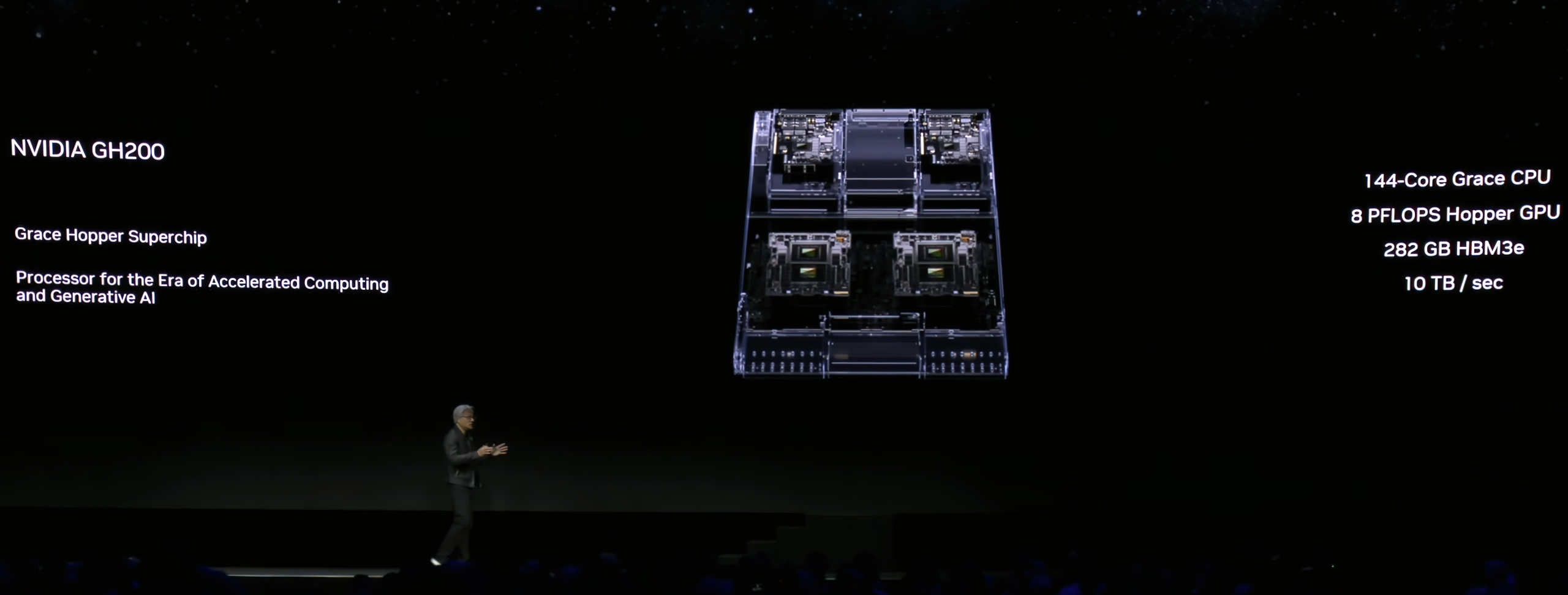

NVIDIA na SIGGRAPH 2023 zaprezentowała swój ulepszony procesor graficzny GH200, który jest teraz wyposażony w HBM3e, najszybsze na świecie rozwiązanie pamięciowe.

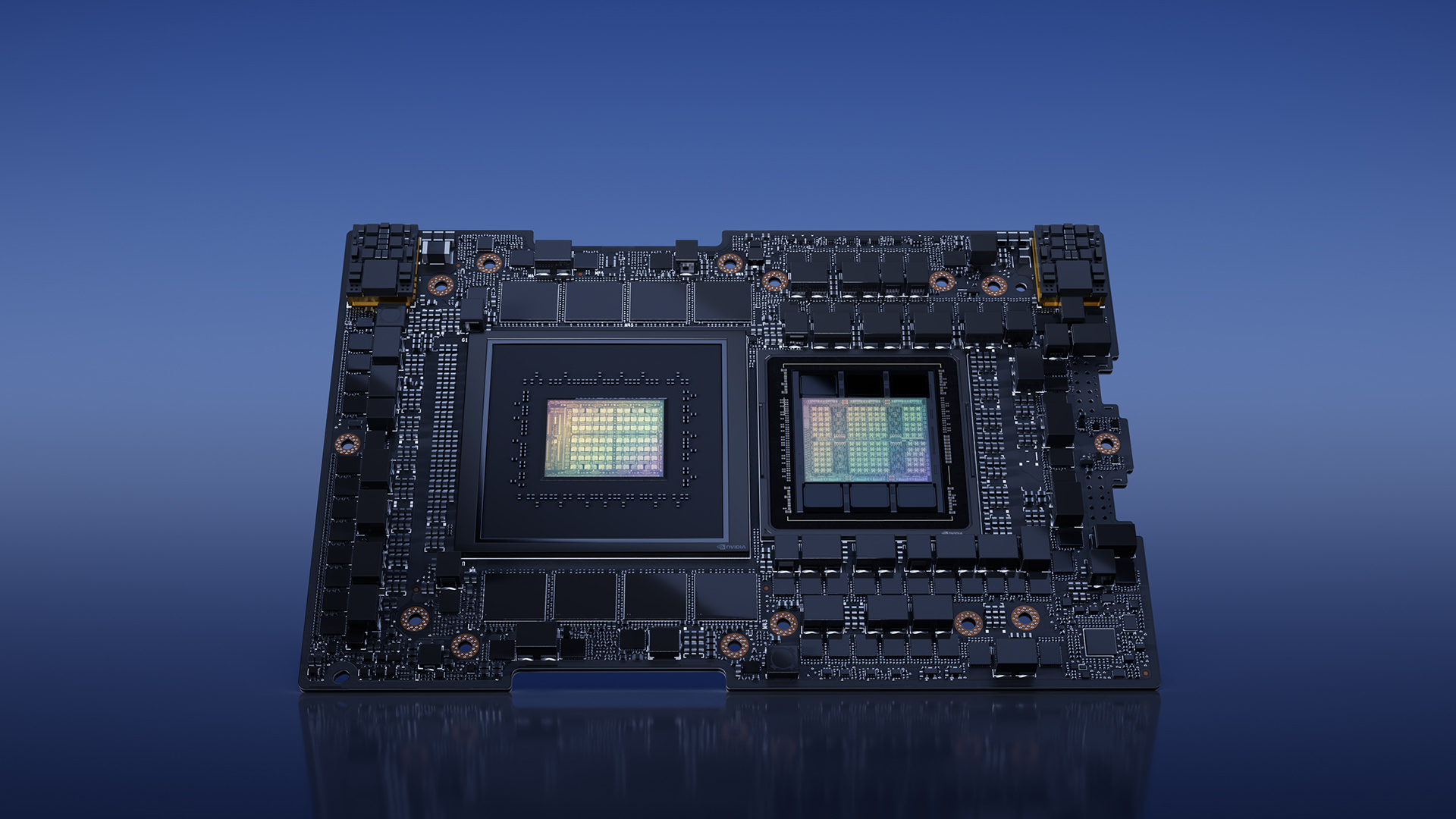

Według firmy NVIDIA, procesor graficzny Hopper GH200 jest teraz pierwszym na świecie układem graficznym z modułami pamięci HBM3e, który oferuje nie tylko wyższą przepustowość pamięci, ale także wyższą pojemność pamięci. Podwójny system Grace Hopper oferuje teraz 3,5-krotnie większą pojemność i 3-krotnie wyższą przepustowość niż dotychczasowe rozwiązania. Systemy mogą teraz oferować do 282 GB pamięci HBM3e.

Sama pamięć HBM3e oferuje o 50% większą prędkość w porównaniu do istniejącego standardu HBM3, zapewniając przepustowość do 10 TB/s na system i 5 TB/s na chip. Pamięć HBM3e będzie teraz wykorzystywana do napędzania gamy systemów wykorzystujących super chip GH200, które obejmują różnorodne kombinacje najnowszych architektur CPU, GPU i DPU firmy NVIDIA, w tym Grace, Hopper, Ada Lovelace i Bluefield, aby sprostać rosnącemu zapotrzebowaniu w segmencie sztucznej inteligencji.

NVIDIA nie ogłosiła, od kogo będzie pozyskiwać zupełnie nowe moduły pamięci HBM3e do wykorzystania w swoich procesorach graficznych GH200 AI, ale SK Hynix niedawno otrzymał prośbę od firmy NVIDIA o przetestowanie pamięci HBM3e DRAM nowej generacji. Tymczasem Samsung ma również szybkie pamięci HBM3, które mogą oferować przepustowość do 5 TB/s na stos, choć wydaje się, że SK Hynix może być wyborem dla procesorów graficznych GH200.

Firma oświadczyła również, że pierwsze systemy wykorzystujące procesory graficzne Hopper GH200 z nową technologią pamięci HBM3e będą dostępne do drugiego kwartału 2024 roku, czyli nieco później niż procesory graficzne AMD Instinct MI300X, które będą wyposażone w podobne matryce HBM3 o przepustowości 5 TB/s + i pojemności do 192 GB VRAM.