Polskie firmy nadzorują stosowanie narzędzi AI, ale nie zawsze kontrolują wszystkie ryzyka, wynika z badania EY “Jak polskie firmy wdrażają AI”

Sztuczna inteligencja może być wykorzystywana zarówno do cyberataków, jak i obrony przed nimi. Z badania EY – Jak polskie firmy wdrażają AI – wynika, że niemal wszyscy respondenci (92%) analizują aspekt cyberbezpieczeństwa przy wdrażaniu tego narzędzia. Przy czym 37% z nich bierze pod uwagę ten obszar tylko w ograniczonym stopniu. O rosnącej świadomości przedsiębiorstw w zakresie sztucznej inteligencji świadczy fakt, że 66% ankietowanych wdrożyło procedury dotyczące jej stosowania przynajmniej dla ogólnodostępnych systemów, a kolejne 30% rozważa wprowadzenie takich zasad. Co ciekawe, rodzime firmy deklarują, że odpowiednio zarządzają ryzykiem. Tylko 3% z nich nie zastanawiało się nad tym, jakie zagrożenia niesie ze sobą sztuczna inteligencja.

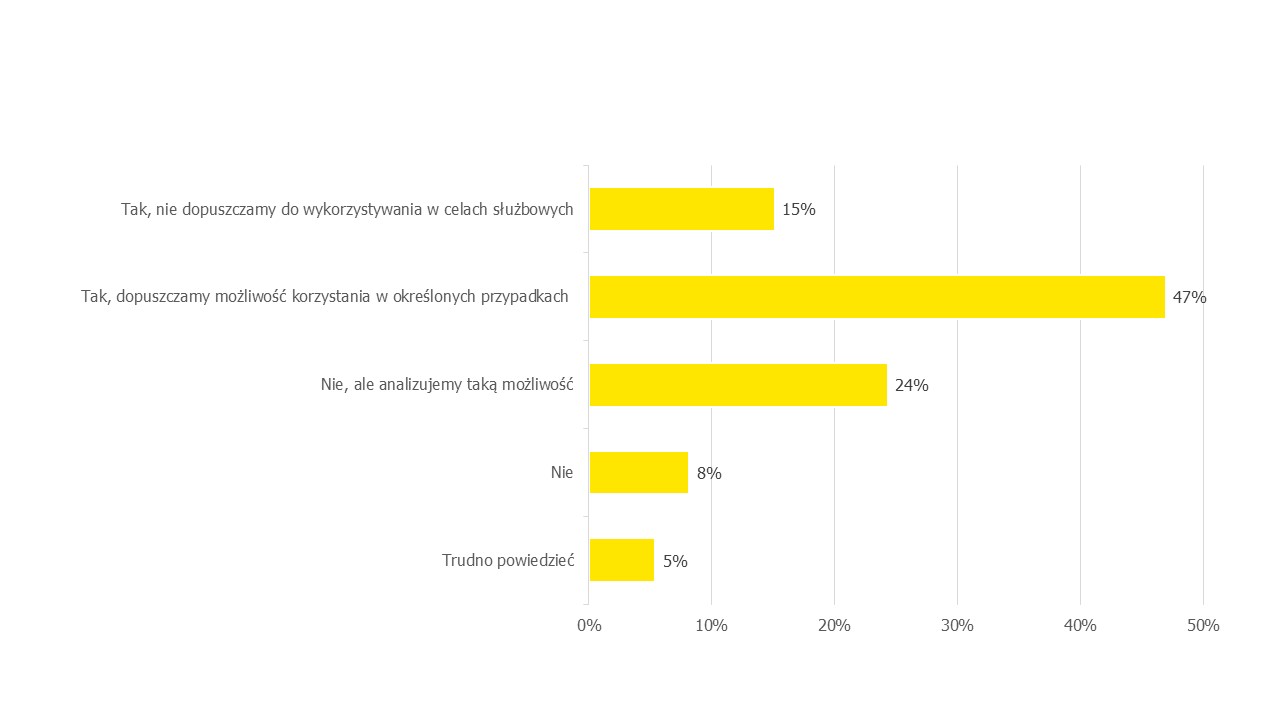

Stosowanie rozwiązań opartych na AI w wielu firmach staje się już normą i szansą na istotne zwiększenie efektywności swoich działań. Jednak jak każda technologia, również i ta niesie ze sobą zarówno szanse, jak i zagrożenia, na czele z wirtualnymi ryzykami. Wyniki badania EY – Jak polskie firmy wdrażają AI – wskazują, że dla rodzimych przedsiębiorców kwestie dotyczące cyberbezpieczeństwa przy implementacji narzędzi AI są istotne. Ponad połowa z nich (55%) rozważa ten aspekt, a kolejne 37% bierze go pod uwagę w ograniczonym zakresie. Zaledwie 3% respondentów zupełnie ignoruje ten temat.

– Wraz ze wzrostem zastosowań sztucznej inteligencji pojawiają się nowe zagrożenia, które wymagają ochrony sieci i systemów informatycznych przed atakami. Firmy w Polsce deklarują, że analizują potencjalne ryzyka, jednak praktyka w wielu przypadkach wygląda mniej optymistycznie. AI jest postrzegana głównie jako technologiczna nowość i kojarzona z takimi rozwiązaniami jak chatboty. Tymczasem to zupełnie nowy obszar ryzyka, a wiele przedsiębiorstw nie jest przygotowanych na cybernetyczne zagrożenia. Zaliczymy do nich ataki z wykorzystaniem spersonalizowanych wiadomości phishingowych, próby wyłudzeń z użyciem komunikatów zawierających nagranie głosowe łudząco podobne do głosu znanych nam osób czy też łatwiejsze pisanie kodów przez hakerów chcących znaleźć luki w oprogramowaniu. Efektem coraz swobodniejszego i niebezpiecznego wykorzystania narzędzi AI jest coraz rosnący problem z wyciekiem wrażliwych danych – tłumaczy Piotr Ciepiela, Partner EY, Lider Zespołu Cyberbezpieczeństwa w regionie EMEIA.

Wykres 1. Czy wprowadzając narzędzia oparto o AI analizowane były aspekty dot. cyberbezpieczeństwa?

Nowe polityki dotyczące narzędzi AI

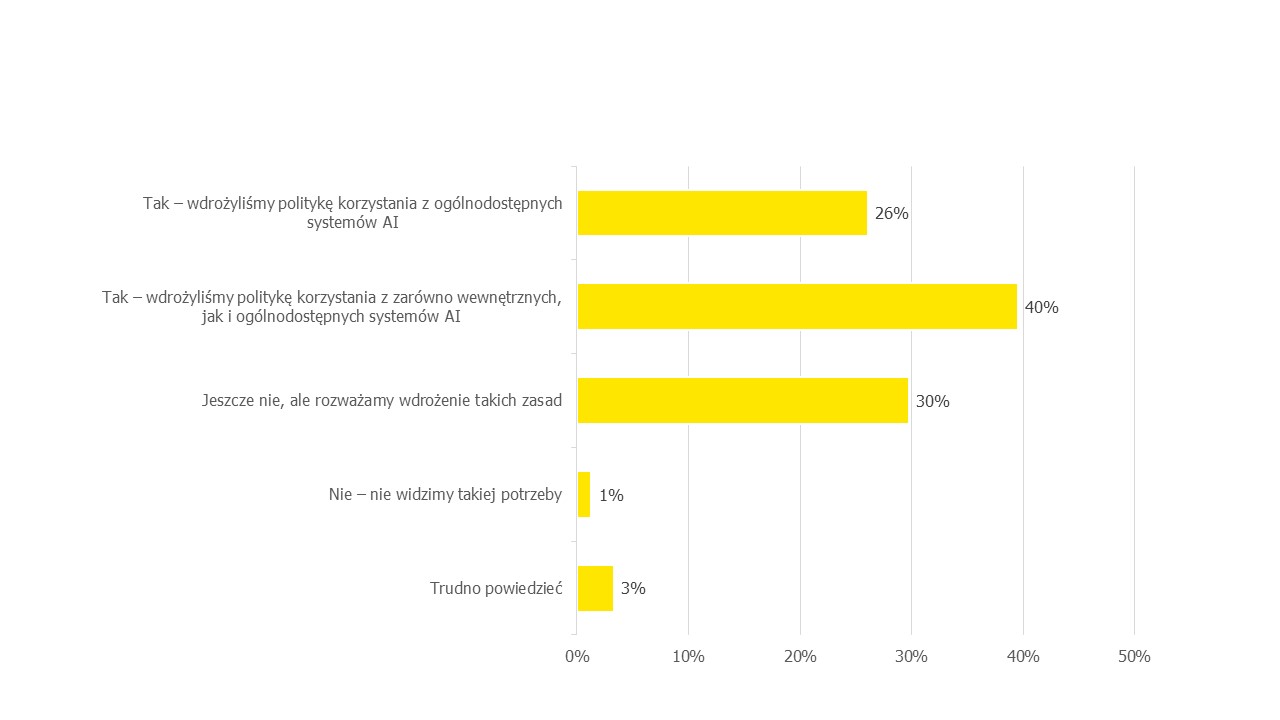

Ważnym typem działań w zakresie cyberbezpieczeństwa jest wprowadzenie odpowiednich procedur dotyczących używania systemów AI. Z badania EY wynika, że najwięcej respondentów (40%) wdrożyło politykę korzystania zarówno z wewnętrznych, jak i ogólnodostępnych narzędzi AI np. chatbotów. Pod kontrolą 26% firm znajduje się używanie wyłącznie zewnętrznych systemów, a 30% dopiero zastanawia się nad przyjęciem jakichkolwiek zasad.

Wdrożenie polityk dotyczących korzystania z ogólnodostępnych rozwiązań AI pozwoli organizacji uchronić się przed negatywnymi skutkami ich używania, np. wyciekiem zastrzeżonych czy wrażliwych danych. Jeśli pracownik bez nadzoru korzysta z zewnętrznych narzędzi do wykonywania obowiązków służbowych i przekazuje chatbotowi poufne informacje lub szczegóły ważnych projektów, może to narazić firmę na nieprzewidziane reperkusje. Dlatego tak ważne jest stosowanie systemów AI w sposób odpowiedzialny i zgodny z zasadami etycznymi firmy, co pozwoli zminimalizować potencjalne ryzyka.

Wykres 2. Czy wdrażane były szczegółowe zasady i procedury dotyczące używania systemów AI?

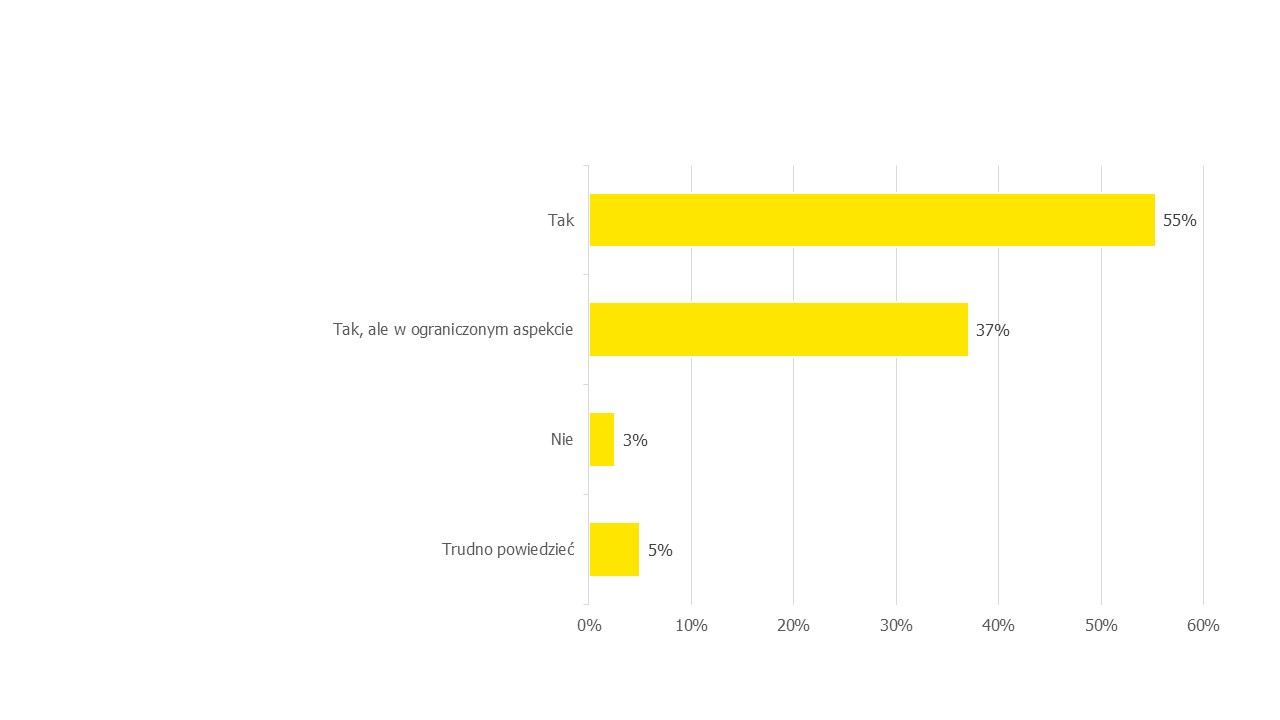

Respondenci mają świadomość zagrożeń, dlatego chatboty coraz częściej stają się przedmiotem regulacji w wielu firmach. Niemal połowa (47%) dopuszcza możliwość korzystania z nich w określonych przypadkach, zaś 15% pozwala na to tylko w celach służbowych. Co czwarta organizacja (24%) nie wprowadziła jeszcze żadnych polityk w tym obszarze, ale analizuje taką możliwość.

Minimalizowanie zagrożeń

Firmy w Polsce stosują różne podejścia do zarządzania ryzykiem związanym z wdrożeniem systemu AI. Niemal co trzeci ankietowany (31%) zidentyfikował najważniejsze zagrożenia związane z jego implementacją w swojej organizacji i stara się im zapobiegać. Drugą grupę stanowią przedsiębiorstwa, które jeszcze przed wdrożeniem konkretnego systemu przeprowadzają analizę ryzyka (26% odpowiedzi). Znaczny odsetek (27%) stanowią respondenci, którzy orientują się w ogólnych, typowych ryzykach związanych z AI, nie skupiając się na aspektach specyficznych dla swojej organizacji. Z kolei co dziesiąta firma (10%) zarządza ryzykiem przy adopcji narzędzi sztucznej inteligencji, stosując takie samo podejście, jak przy wdrożeniu każdego innego systemu IT.

Najsłabszym ogniwem w procesie utrzymywania wysokiego poziomu cyberbezpieczeństwa są pracownicy – ich niewystarczający poziom wiedzy lub błędy najczęściej doprowadzają do narażenia firmy na ataki cybernetyczne. Aby temu przeciwdziałać, organizacje implementujące narzędzia AI zawczasu się zabezpieczają. Jednym z najpopularniejszych sposobów jest wprowadzenie rozwiązań proceduralnych (np. szkoleń dla pracowników), które wskazało 36% respondentów. Inną opcją jest zwiększenie liczby rozwiązań na poziomie narzędzi (31% odpowiedzi), a co piąta firma (20%) wdrożyła zarówno zabezpieczenia proceduralne, jak i narzędziowe.

– Choć implementacja narzędzi AI jest coraz powszechniejsza w rozmaitych branżach, to jednak dla wielu organizacji oznacza to dużą zmianę ze względu na kompleksowość takiego projektu. Na pewno należy zadbać o przeszkolenie wszystkich pracowników, by poznali jasne zasady korzystania zarówno z wewnętrznych, jak i ogólnodostępnych systemów sztucznej inteligencji. Warto także przeprowadzić szczegółową analizę ryzyka jeszcze przed samym wdrożeniem AI. Pozwoli to zbudować skuteczną strategię działania i zidentyfikować obszary, na które należy zwrócić szczególną uwagę, takie jak ochrona danych osobowych czy kwestie prawne – radzi Patryk Gęborys, Partner EY Polska, Zespół Bezpieczeństwa Informacji i Technologii.

Wykres 3. Czy wprowadzono w formie firmowej polityki zasady korzystania z ogólnodostępnych narzędzi opartych o AI?