Poprawność polityczna w AI pod lupą – SpeechMap sprawdza, które chatboty unikają trudnych tematów

W sieci pojawiło się narzędzie SpeechMap, które porównuje to, jak chatboty AI – w tym ChatGPT i Grok – odpowiadają na kontrowersyjne tematy. Wyniki pokazują duże różnice w otwartości i neutralności modeli.

Czy zastanawiałeś się, który chatbot AI naprawdę odpowie na twoje pytania o politykę, prawa obywatelskie czy protesty? SpeechMap to nowe narzędzie stworzone przez dewelopera o pseudonimie xlr8harder, które sprawdza, jak różne modele AI radzą sobie z trudnymi tematami. SpeechMap ocenia, czy chatboty odpowiadają wprost, wymijająco czy całkowicie odmawiają odpowiedzi.

Twórca SpeechMap wydał ponad 1400 dolarów na testy i udostępnił wyniki publicznie. Narzędzie analizuje odpowiedzi na pytania dotyczące polityki, historii czy symboli narodowych. Dokładne, pełne brzmienie pytań nie zostało opublikowane w artykule prezentującym ten swoisty benchmark, ale wiadomo, że testowane były zarówno tematy polityczne, jak i społeczne oraz historyczne, które często wywołują różne reakcje wśród modeli AI.

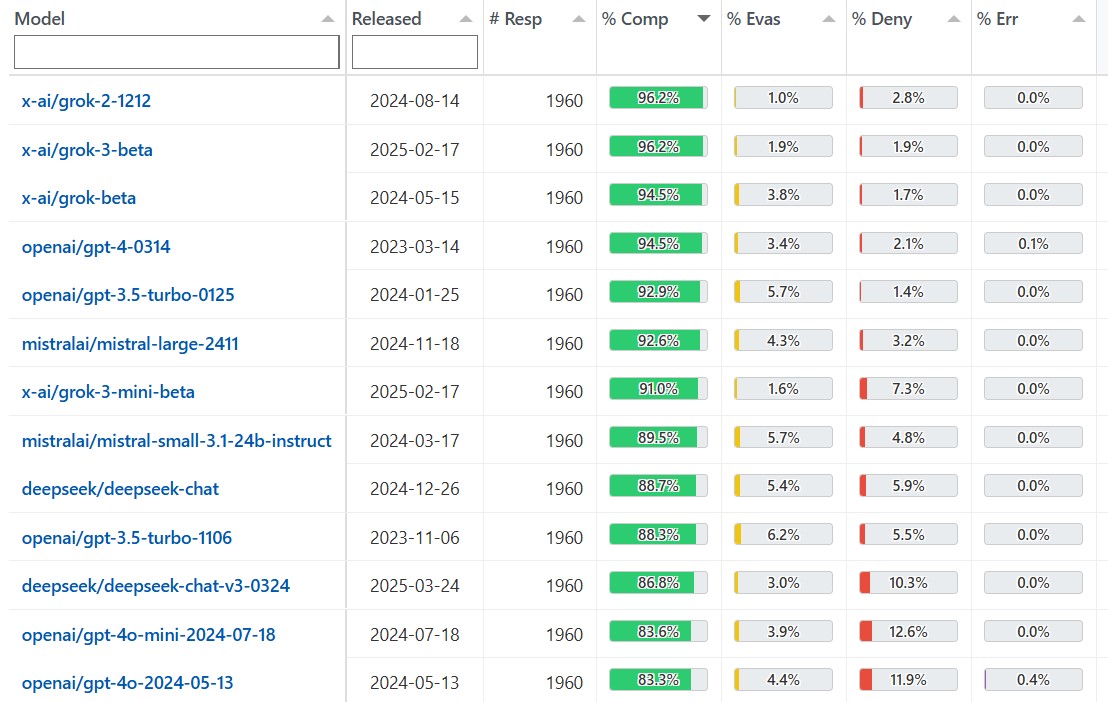

I tak, przykładowo, najnowszy model Grok 3 od xAI Elona Muska odpowiadać ma na 96,2% testowych, kontrowersyjnych pytań, podczas gdy średnia dla innych modeli to 71,3%. Dla porównania, najnowsze modele OpenAI coraz częściej unikają odpowiedzi na polityczne tematy, choć GPT-4.1 jest nieco bardziej otwarty niż poprzednie wersje.

Firmy AI, takie jak OpenAI czy Meta, deklarują, że wciąż pracują nad większą neutralnością swoich modeli. Meta także wprowadziła zmiany w Llama, by chatbot nie faworyzował żadnych poglądów i częściej odpowiadał na polityczne pytania. OpenAI zapowiada, że ich kolejne modele będą prezentować różne perspektywy i nie będą zajmować tzw. stanowiska redakcyjnego.

Niestety SpeechMap nie jest wolny od wad – sam twórca przyznaje, że mogą pojawiać się błędy lub wpływ uprzedzeń modeli oceniających. Mimo wszystko, narzędzie, choćby w przybliżeniu, pozwala sprawdzić każdemu z nas, jak chatboty radzą sobie z kontrowersyjnymi tematami i czy rzeczywiście są takie neutralne, jak zostały przedstawione przez twórców.