Relacja z Google Cloud Next 2024 w Las Vegas – sztuczna inteligencja przejmuje stery

Google Cloud Next to cykl spotkań amerykańskiego potentata internetowego z jego globalną siecią firm partnerskich, oraz z kluczowymi klientami. Ma ono charakter zarówno konferencji technologicznej, spotkania partnerskiego, jak i swoistego pokazu siły. Google zaprosiło mnie do wzięcia udziału w wydarzeniu, które w tym roku okazało się być także areną dla prezentacji nowości firmy z Moutain View. W tym artykule postaram się nakreślić swoje przemyślenia na temat tego, co miałem okazję zobaczyć i usłyszeć w Las Vegas.

No właśnie, Las Vegas. Miejsce, jak się okazuje, nieprzypadkowe. Wcześniejsze Cloud Nexty odbywały się w pobliżu siedziby internetowego giganta, w San Francisco. Skąd więc zmiana? Jej przyczyną jest skala wydarzenia. Jak przyznali sami Googlersi, z którymi miałem okazję rozmawiać, kalifornijskie miasta nie dysponują obiektami pozwalającymi na organizację spotkania na 30 tysięcy ludzi. Las Vegas, ze swoimi olbrzymimi hotelami, jest dość dobrze dostosowane do takich potrzeb. To w końcu tutaj odbywa się co roku CES. Google z całą pewnością na organizacji nie oszczędzało. Nie chodzi tylko o skalę Cloud Next 2024. Wszystko było bardzo dobrze przemyślane organizacyjnie, także, co jest bolączką wielu dużych wydarzeń, oznakowanie. W hotelach, które, z racji tego, że pokaźna część ich przychodów pochodzi z kasyn, i dlatego zostały zaprojektowane tak, by nieco się w nich gubić, uczestnicy wydarzenia bez problemu docierali na wybrane punkty programu.

“Tegoroczny Google Cloud Next ma aż 30 tysięcy uczestników. Myślę, że ta skala najlepiej obrazuje zmianę, z jaką mamy do czynienia. Tyle osób z całego świata chciało tutaj przyjechać, zapłacić za swoją podróż, za uczestnictwo w konferencji. (…) Od wielu lat to miejsce wyznacza biegun przyszłości. Tutaj dziś powstaje przyszłość” – oceniła Magdalena Dziewguć, Country Director w Google Cloud Poland.

Otwierający Google Cloud Next 2024 Keynote, zorganizowany na przepastnej arenie sportowej, wyraźnie nadał ton całemu wydarzeniu. Nie liczyłem nawet, jak często padało hasło “AI”. Dla każdego, kto ostatnich 2 lat nie spędził pod kamieniem, jest to jednak oczywiste. Wszystkie właściwie firmy technologiczne chętnie opowiadają o swoich osiągnięciach na polu sztucznej inteligencji. Czasami w opowieściach tych jest więcej marketingu i okrągłych zdań, niż realnych technologii. Tego, z całą pewnością, nie jest w stanie zarzucić Google’owi.

Keynote dotknął wielu różnych zastosowań rozwiązań AI opracowanych przez inżynierów Google’a, często podając przykłady praktyczne. Amerykańskiej firmie udało się też uniknąć dość powszechnego zjawiska na rynku tj. chwalenia się nowymi modelami AI. Modele powstają dziś, mniej lub bardziej udane, z wielką częstotliwością, ale nie tak wiele z nich okazuje się zyskiwać popularność. Google, co jasno dało się wyczytać z Keynote’u, ma zdecydowanie bardziej platformowe podejście. To zrozumiałe o tyle, że wśród swoich technologii Google umieściło już w zeszłym roku Vertex AI, platformę uczenia maszynowego, która może pracować z różnymi modelami AI, ułatwiając ich praktyczne wykorzystanie.

Co pokazało Google podczas Cloud Next 2024?

Dziś sztuczna inteligencja często kojarzona jest z modelami językowymi. Chociaż w tym obszarze Google zaprezentowało kilka nowości, to patrząc z perspektywy potencjału biznesowego, szczególną rolę odgrywa tu co innego: Vertex AI Agent Builder. Jest to narzędzie, które pomaga użytkownikom biznesowym tworzenie tzw. Agentów AI. W praktyce oznacza to możliwość kreowania własnych, wyspecjalizowanych agentów konwersacyjnych, m.in., ale nie wyłącznie, chatbotów. Co w tym unikalnego? Otóż Google umieściło w narzędziu proces nazwany grounding (ang. „uziemianiem”, acz nie całkiem pasuje mi polskojęzyczna wersja). Sprawia on, że odpowiedzi są powiązane z czymś uważanym za wiarygodne źródło. W konfigurowaniu narzędzia można także wskazać jako źródło… wyszukiwarkę Google, co naturalnie skutkuje kolosalną bazą wiedzy, ale też daje potencjalnie wiele problemów z dokładnością odpowiedzi.

Znaczący potencjał wnosi także inna nowość, Google Gemini Code Assist. Narzędzie to jest de facto konkurentem dla Copilot Enterprise Microsoftu, a więc jest w stanie pomóc w tworzeniu aplikacji, uzupełniając i sugerując rozwiązania w tworzeniu kodu. Dla osób zaznajomionych z narzędziami Google będzie jasnym, że to nie jest pierwsze podejście tej firmy do tego typu AI. Wcześniej widzieliśmy bowiem narzędzie Duet AI.

Interesującym ułatwieniem w codziennej pracy jest rozwijany od jakiegoś już czasu AppSheets. Jest to narzędzie, które pozwala na proste tworzenie aplikacji na podstawie danych zawartych w arkuszu kalkulacyjnym. Co w tym wyjątkowego? Otóż wpisuje się ono w trend no-code, który obserwujemy od kilku już lat na rynku. Nie każdy będzie programistą, ale znajomość języków programowania nie jest w tym przypadku konieczna.

Nowości prezentowane podczas Google Cloud Next były niewątpliwie zróżnicowane, ale niemal wszystkie łączył jeden, wspólny mianownik: sztuczna inteligencja. Kalifornijska firma zaprezentowała wersję preview Gemini in Databases, czyli pakietu narzędzi opartych na sztucznej inteligencji, przeznaczonych dla programistów, którzy tworzą, monitorują i migrują bazy danych aplikacji. Częścią narzędzia jest edytor SQL o nazwie Database Studio. Pozwala on m.in. na zautomatyzowane naprawianie niektórych błędów w SQL. Co więcej, narzędzie potrafi dawać sugestie programistom dzięki sub-funkcji przypominającej chatbota. Google poszło nawet o krok dalej. W kolejnej składowej narzędzia, nazwanej Database Center, użytkownicy mogą wchodzić w interakcję z bazami danych przy użyciu języka naturalnego. Narzędzie może też pomóc np. w ocenie bezpieczeństwa czy zgodności z polityką bezpieczeństwa i prywatności. W razie niespełnienia reguł, narzędzie poda podpowiedź rozwiązania. Gemini in Databases można postrzegać jako swego rodzaju odpowiedź na Copilot in Azure SQL Database firmy Microsoft.

Google nie ograniczyło się oczywiście wyłącznie do narzędzi dla programistów. O nowe funkcjonalności wzbogacono także usługi zgromadzone w Google Workspace. Nikogo chyba nie zaskoczę gdy napiszę, że wiele z tychże nowości opiera się o możliwości wniesione do ekosystemu Google przez AI. Teraz sztuczna inteligencja pomagać będzie np. przeszukiwaniu Dysku w poszukiwaniu konkretnych treści, nie opierając się przy tym jedynie na określonych frazach. W Gmailu dla Workspace pojawiła się natomiast funkcja, która umożliwia natychmiastowe przekształcenie roboczych wersji e-maili w bardziej dopracowane wiadomości. Poza tym w Workspace pojawiło się kilka nowości dotyczących Arkuszy – jednego z najpopularniejszych narzędzi w Workspace. Nowa usługa może wysyłać powiadomienia np. w sytuacji gdy dana komórka zostanie zmieniona. To naturalnie oznacza, że wiemy natychmiast, gdy ktoś z naszego zespołu np. wypełnił arkusz wymaganymi treściami. Ponadto Arkusze będą teraz zawierać nowy zestaw szablonów ułatwiających rozpoczęcie pracy z nowym arkuszem kalkulacyjnym. Dokumenty, inne z popularnych narzędzi Google’a, obsługują teraz karty i usprawnione wyszukiwanie.

Programowanie, praca biurowa… a co z zadaniami kreatywnymi? Jednym z popularnych zastosowań sztucznej inteligencji są, mniej lub bardziej udane, próby wykorzystania jej do generowania treści wizualnych. Tego typu pomysłów nie zabrakło także wśród najważniejszych nowości prezentowanych na Google Cloud Next 2024. Wśród nich na uwagę zasługuje nowe narzędzie do tworzenia filmów o nazwie Google Vids. Póki co, jest to zapowiedź, ale z czasem stanie się ono częścią pakietu biurowego Google Workspace. Google Vids, z tego co mogłem obserwować na prezentacjach, jest dość pomysłowo wpasowanym w ekosystem Google’a narzędziem, umożliwiającym tworzenie krótkich filmów na podstawie określonych, obecnych już w zasobach Workspace treści. Np. możemy nakazać przeanalizowanie firmowego brandbooka, oraz napisanego wcześniej planu kampanii, aby narzędzie zasugerowało scenariusz filmu, a po jego zaakceptowaniu dany film wygeneruje. Można wybierać przejścia, określone szablony czy ścieżki audio. Można też dodać skrypt do przeczytania wirtualnemu lektorowi. Brzmi imponująco, ale, póki co, efekty raczej trudno pomylić z rzeczywistym nagraniem. Narzędzie daje też możliwość współpracy nad powstającymi materiałami w czasie rzeczywistym. Przykłady, jakie dało Google jeśli chodzi o pracę z narzędziem Vids skupiały się głównie na obszarze zastosowań w marketingu i reklamy, co wydaje się zrozumiałe. Jednocześnie, spodziewałbym się, że narzędzia takie jak Vids (a przy tym ich konkurencja, która z pewnością także się wkrótce pojawi) mogą pozbawić pracy wiele osób z tzw. branż kreatywnych.

Usługa Google Vids jest obecnie w fazie ograniczonych testów. Zgodnie z zapowiedzią, w czerwcu zostanie udostępniona dodatkowym testerom i ostatecznie będzie dostępna dla klientów posiadających subskrypcję Gemini for Workspace.

No właśnie, Gemini. Podczas wydarzenie Google ogłosiło wprowadzenie do publicznej wersji beta modelu generatywnej sztucznej inteligencji o nazwie Gemini 1.5 Pro. Nowość oferuje imponującą zdolność przetwarzania kontekstowego, co wyróżnia go na tle innych rozwiązań tego typu. Gemini 1.5 Pro, który zadebiutował w lutym tego roku, może przetwarzać od 128 000 do nawet 1 miliona “tokenów”, co pozwala mu na analizę ogromnych ilości danych. Porównując Gemini 1.5 Pro do innych modeli AI, łatwo zauważyć, że może on obsłużyć nawet osiem razy więcej niż GPT-4 Turbo od OpenAI. To poważna przewaga, chociaż nie w każdym zadaniu. Do najprostszych zapytań wystarczy znacznie prostsze narzędzie, jednak wszędzie tam, gdzie potrzebne są bardziej dokładne, dopasowane do kontekstu odpowiedzi, Gemini 1.5 Pro może rzeczywiście górować.

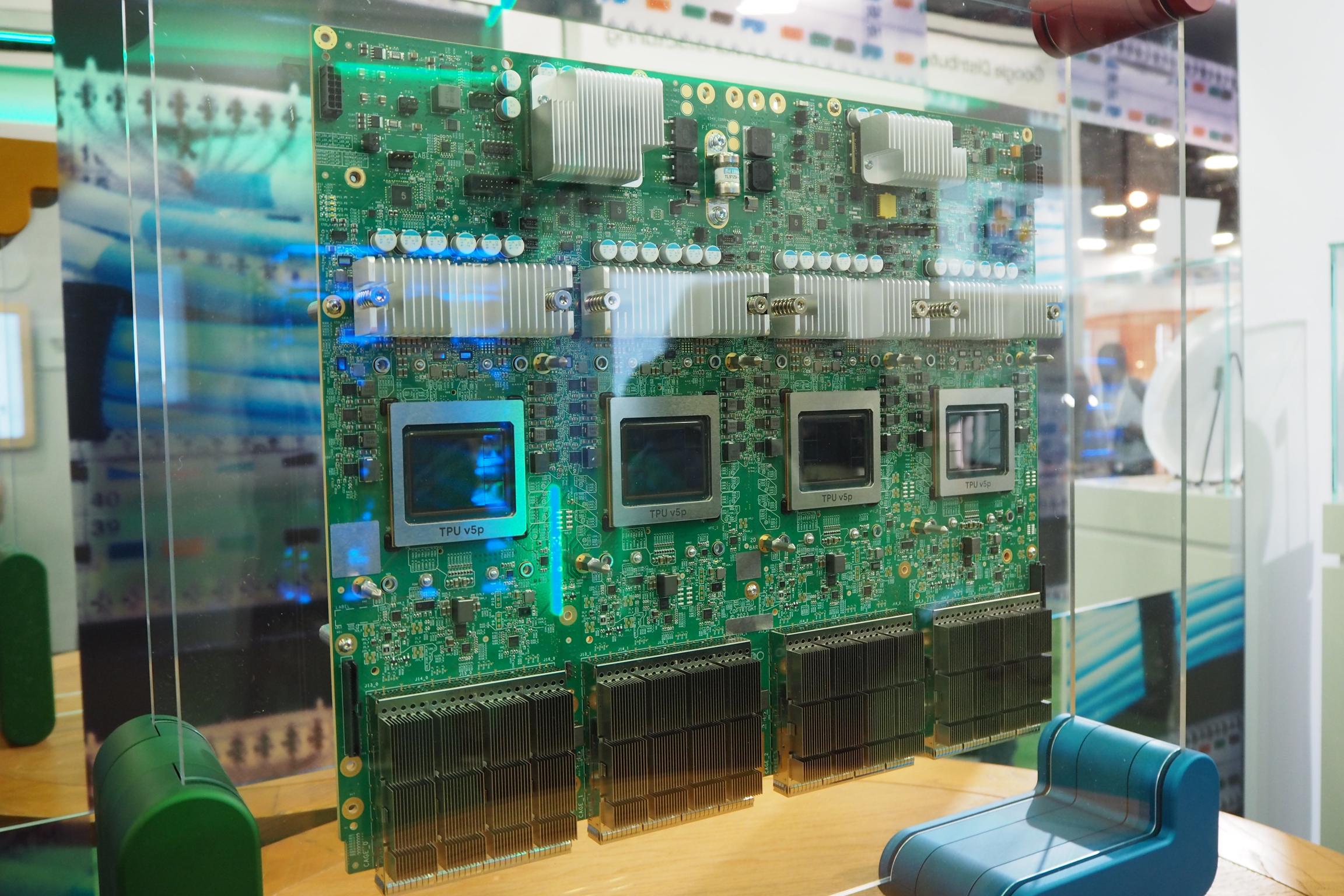

Cała ta rewolucja AI, która trwa przynajmniej od kilkunastu miesięcy, wymaga systematycznych usprawnień po stronie infrastruktury. O ile Google może pochwalić się partnerstwem zarówno z Nvidią, jak i AMD czy Intelem, o tyle firma rozwija także swoje chipy. Podczas Google Cloud Next 2024, kalifornijska firma mogła pochwalić się także nowymi układami, które zapewnić mają odpowiednią moc obliczeniową, przy zachowaniu rozsądnego poboru mocy. Nowy TPU (czyli tensor processing unit, jednostka przetwarzania tensorowego, a więc wyspecjalizowana w zadaniach związanych z AI) oznaczony jako TPU v5p oraz SoC Axion będą kolejną generacją układów mających wzmocnić możliwości centrów danych Google. Podczas jednej z sesji dowiedziałem się, że Google nie planuje oferowania tych układów stronom trzecim.

Na każdym kroku widać, że Google podeszło do tematu rozwoju AI bardzo poważnie. Siłę inwestycji w ten obszar widać dosłownie na każdym kroku, ja każdej sesji czy wystąpieniach.

Google Cloud jest bardzo obiecujący. Widoczne są nasze głębokie inwestycje w sztuczną inteligencję. Od dawna wiemy, że sztuczna inteligencja odmieni każdą branżę i firmę, także naszą. Dlatego od ponad dekady budujemy infrastrukturę AI, w tym TPU, obecnie piątą generację. Te postępy są doskonale widoczne. Klienci szkolą i obsługują najnowocześniejsze modele językowe. Dzięki tym inwestycjom jesteśmy liderem zmian w platformach AI i jesteśmy dumni, że obecnie ponad 60% finansowanych startupów zajmujących się generatywną sztuczną inteligencją i prawie 90% jednorożców “generacji AI” to klienci Google Cloud. Jesteśmy z tego dumni. – powiedział podczas sesji roundtable Thomas Kurian, CEO Google Cloud.

Sztuczna inteligencja to nie tylko hasło

Google pokazało podczas swojej konferencji wiele nowości. Wszystkie jednak mają wspólny mianownik: sztuczną inteligencję. Warto pochylić się nad ogólną koncepcją tego, jak Google zdaje się dziś postrzegać AI. Najważniejsze wydaje się obecnie, nie tyle nawet stworzenie najsilniejszego AI spośród ogólnodostępnych, ale zbudowanie narzędzi, które z AI skorzystają. Te narzędzia natomiast, mają za zadanie przede wszystkim usprawniać codzienną pracę. Bez względu na to, czy jesteś programistą, HR-owcem, analitykiem czy pracownikiem mediów, znajdziesz wśród nowych narzędzi takie, które mogą przejąć część twoich zadań.

No właśnie, przejmowanie zadań – coś co może mieć zarówno pozytywne, jak i negatywne konsekwencje. O ile pozytywne wydają się dość oczywiste, są nam komunikowane przez gigantów technologicznych na każdym niemal kroku, o tyle całość jest bardziej zniuansowana. Podczas jednej z sesji nt. AI kolega dziennikarz z Niemiec zadał pytanie dotyczące branży kreatywnej i wpływu narzędzi takich jak opisany powyżej Google Vids na rynek pracy w tym obszarze. Odpowiedź, niestety, mnie nie zaskoczyła, była jednocześnie rzeczowa i za okrągłymi zdaniami ukrywała dość mroczną prawdę. Usłyszeliśmy bowiem, że narzędzia korzystające z AI usprawnią pracę, przyspieszą ją i wcale nie doprowadzą do zwolnień. To powszechna narracja, w której zawiera się prosty błąd logiczny: wzrost sprzedaży musiałby być równy wzrostowi produktywności. Tak, z oczywistych przyczyn, dziać się nie będzie. W odpowiedzi ostatecznie pojawiła się też bardziej szczera fraza: “agencje kreatywne i marketingowe zwykle nie mają fotografów, ludzi od wideo i montażu na stałe, a na kontraktach. Nie będzie więc zwolnień”. Mówiąc w skrócie: niech martwią się tylko kamerzyści, montażyści, fotografowie – AI to będzie ich problem, nasz, czyli korporacji, zysk.

Podobny problem dotyczy zresztą też usprawnień w innych dziedzinach. Zastanawiam się chociażby nad tym jak wielkie firmy analityczno-doradcze będą mogły zredukować zatrudnienie, opierając się w większym stopniu na odpowiednio wyszkolonych modelach. W gruncie rzeczy model biznesowy tych podmiotów da się w niemałym stopniu zautomatyzować. Tym bardziej nie powinno dziwić, że na strefie Expo tegorocznego Cloud Next nie brakowało stoisk firm takich jak Accenture, EY czy Deloitte.

Strefa Expo

A skoro już dotknąłem strefy Expo, to muszę przyznać, że pomimo niemałej skali, wydaje się ona być najmniej istotną częścią Google Cloud Next. Dlaczego? Stoisk rzeczywiście było dużo, jednakże trudno jest poświęcić przynajmniej kilkanaście minut na rozmowie o produkcie na każdym z nich. Z mojego doświadczenia wynika raczej, że strefy expo sprawdzają się tam, gdzie mowa o fizycznym produkcie – w przypadku oprogramowania jest to znacznie trudniejsze, by zaciekawić przechodzącego przez alejki expo uczestnika. Moja plakietka z napisem “Media” była przy tym swoistą zachętą do nawiązywania konwersacji. Każdy kto poznał trochę kulturę biznesową zza Atlantyku wie, że bywa ona nieraz wręcz zbyt otwarta, niemal nachalna, oceniając ją naszą, europejską miarą. To zresztą nie tylko moja opinia, bo podobne wrażenia ze strefy Expo mieli też moi koledzy i koleżanki z innych europejskich mediów.

Jednocześnie swoistą perełką Expo była strefa Google’a poświęcona sprzętowi (fizyczny produkt jednak przyciąga wzrok). Miałem okazję wziąć udział w indywidualnym zwiedzaniu stoiska. Oprowadzający mnie po tej strefie Cameron Peron, AI Marketing Leader w Google Cloud, opowiedział m.in. o znaczeniu posiadania własnej infrastruktury przez Google. Mogłem zobaczyć m.in. przykład zastosowania AI w zautomatyzowanym sklepie, gdzie dzięki widzeniu maszynowemu badana jest zawartość koszyka, obejrzeć z bliska wspomniane już wyżej nowe procesory i TPU Google’a oraz specjalnie przygotowane przez Google i HPE serwery przeznaczone dla klientów, którzy chcą mieć dostęp do określonych narzędzi AI, ale, z powodu regulacji prawnych, nie mogą korzystać z chmury publicznej.

Próbując podsumować Google Cloud Next 2024 trudno uniknąć perspektywy nieco szerszej, konfrontując nowości prezentowane w Las Vegas z tym, co już teraz oferują konkurenci. Zaczynając od najważniejszej, jak sądzę, nowości, Gemini 1.5 Pro, to bez wątpienia imponujący model. Czy bardziej użyteczny niż konkurencyjne rozwiązania? Prawdopodobnie wiele zależy od wielu czynników, jak wielkość organizacji, jej potrzeby względem AI, konieczność wyboru metod indywidualnego szkolenia AI itd. Google zapewnia jednak, że mówimy o sztucznej inteligencji obsługującej największą liczbę tokenów, a więc potencjalnie, najbardziej zaawansowanej.

W praktyce, trudno jest jednoznacznie ocenić samo AI w oderwaniu od narzędzi, jakie są oferowane niejako jako “efekt uboczny”. I tu, muszę przyznać, Google odrobiło lekcję. Podczas gdy świat masowo korzystał z Chat GPT, a media technologiczne skupiły uwagę na Copilot od Microsoftu i jego postępującej integracji z Windows, Google opracowało szereg narzędzi, które w przejrzysty sposób łączą się z Google Workspace. Wprawdzie Microsoft ma tu pewną przewagę w postaci popularności swojego systemu operacyjnego, ale Google natomiast, jak żadna inna firma na świecie wpływa na to jak korzystamy z internetu. Obaj amerykańscy giganci IT powoli stają się także gigantami AI, podsuwając użytkownikom pomysły na stosowanie sztucznej inteligencji, pod postacią gotowych narzędzi.

Trudno byłoby mi jednoznacznie wskazać najciekawsze spośród prezentowanych narzędzi AI. Z całą pewnością interesujące są Google Gemini Code Assist, który powinien ułatwić pracę niektórym programistom, oraz Google Vids, które wprawdzie potrzebuje jeszcze nieco dopracowania, ale ma olbrzymi potencjał by przebudować branżę kreatywną.

“Jako uczestniczka wielu Nextów dostrzegam to, że wszystko robi się bardziej zaawansowane. Nawet osoby, które na co dzień pracują z technologią, naprawdę potrzebują poświęcić dużo czasu, żeby zrozumieć, zmiany. Są trzy rzeczy, które chciałabym podkreślić, które są niezwykle ważne – to prawdziwa nowa fala innowacji. Po pierwsze, to bardzo poważny komunikat w sprawie infrastruktury. Google ma ogromną przewagę na rynku związaną z tym, że sam buduje i rozwija swoją infrastrukturę, również na poziomie hardware’u i sieci. Po drugie, muszę wymienić fakt, że wprowadzamy rozwiązania, które podnoszą efektywność i produktywność pracy deweloperów. Wiele kompleksowych rozwiązań dla programistów w różnych dziedzinach to naprawdę rewolucja. (…) Trzeci obszar, jak sądzę, jest najbliższy tym, którzy nas oglądają, bo prawie każdy dorosły Polak pracuje na Gmailu. Filozofią Google’a jest to, że sztuczna inteligencja nie jest wyłącznie dla korporacji, nie jest tylko dla geeków. Sztuczna inteligencja ma wnosić wartość w życie każdego użytkownika. I to widzimy w nowościach wprowadzanych w Workspace.” – powiedziała Magdalena Dziewguć, Country Director w Google Cloud Poland.

Google Cloud Next 2024 to był także swojego rodzaju pokaz siły. Amerykański gigant internetowy zaprosił do Las Vegas olbrzymią liczbę swoich partnerów, firm korzystających z technologii chmurowych Google’a. Ich liczba, ale też fakt iż wiele z nich to duże, doskonale znane, globalnie działające podmioty, rzeczywiście robił wrażenie. Jak sądzę, Google jest na dobrej drodze by wykroić dla siebie naprawdę pokaźny kawałek “tortu AI”. Potencjał technologiczny, kreatywny oraz partnerski zdecydowanie jest po stronie firmy z Moutain View. Będziemy niecierpliwie czekać, aż niektóre z narzędzi prezentowanych na Cloud Next 2024 zyskają status dojrzałych aplikacji.