Samsung ogłosił cały szereg nadchodzących nowych technologii w pamięciach. Obliczenia AI przeniesione do pamięci? Dlaczego nie!

Samsung ma wyjątkową pozycję w świecie technologii, projektując i produkując jednocześnie układy skupiające się na obliczeniach (np. mobilne SoC), jak i pamięci wszelkiego rodzaju. Połączenie tych dwóch obszarów daje Samsungowi możliwości, których nie ma nikt inny – i najwyraźniej koreański gigant chce wykorzystać ten fakt.

Podczas wydarzenia Hot Chips 33, Samsung ogłosił, że rozszerzy swoją technologię przetwarzania w pamięci o moduły DDDR4, GDDR6 i LPDDR5X oprócz układów HBM2. Wcześniej, na początku roku, Samsung pokazał pamięć HBM2 ze zintegrowanym procesorem, który może dokonywać obliczeń z wydajnością 1,2 TFLOPS dla obciążeń AI, co pozwala samej pamięci wykonywać operacje zwykle zarezerwowane dla CPU, GPU, ASIC lub FPGA. Samsung szykuje również mocniejsze warianty tej niezwyczajnej kombinacji, ale z nadchodzącą pamięcią HBM3 nowej generacji.

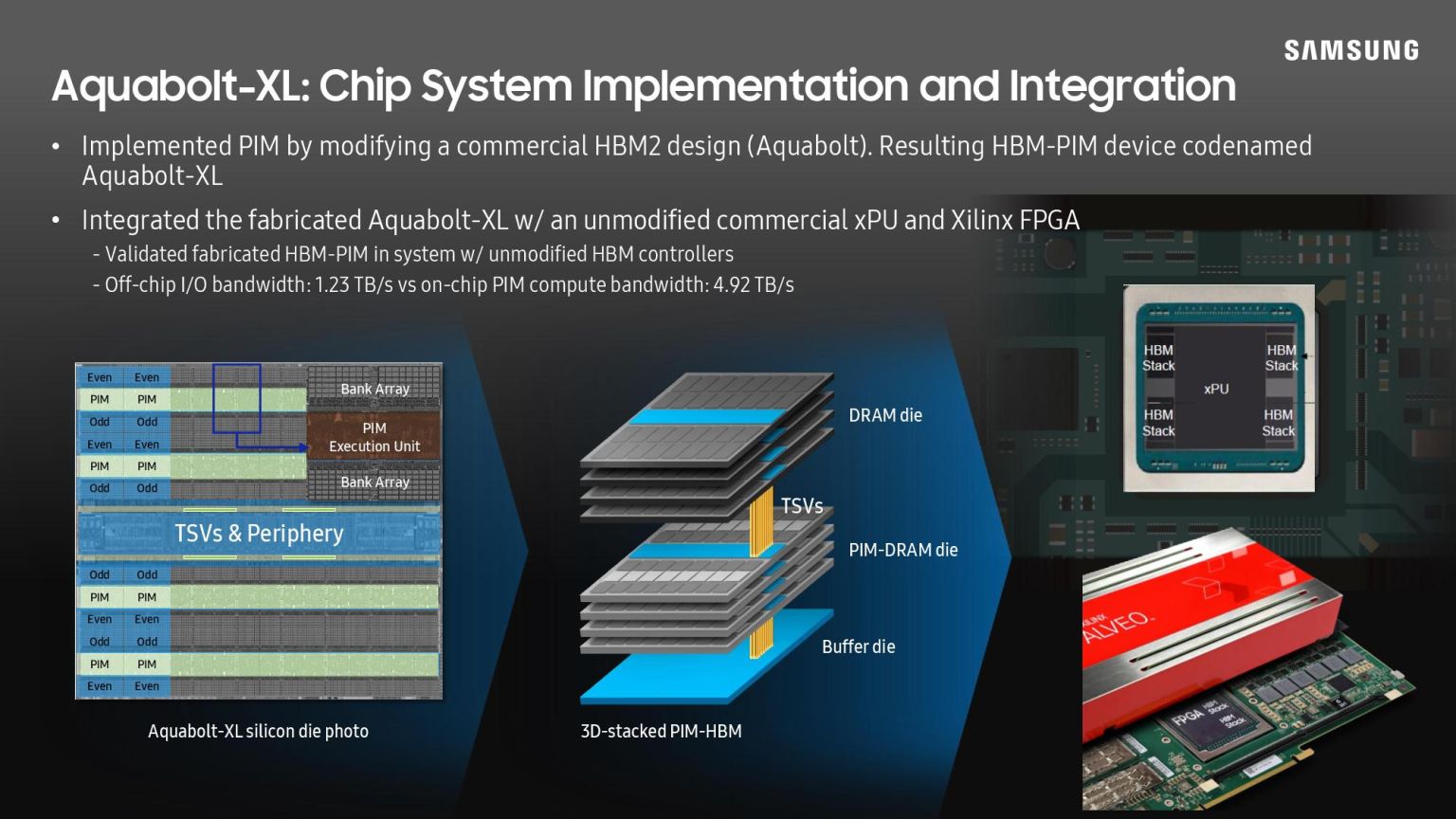

Nowe ogłoszenie Samsunga ujawnia oficjalny branding pamięci tego typu. Noszą one nazwę Aquabolt-XL HBM2. Chipy te mają układ AI umieszczany wewnątrz każdego banku DRAM. Pozwala to samej pamięci na przetwarzanie danych, co oznacza, że system nie musi przenosić danych między pamięcią a procesorem, oszczędzając w ten sposób zarówno czas, jak i energię.

Samsung Aquabolt-XL HBM-PIM współpracuje ze standardowymi kontrolerami pamięci HBM2 zgodnymi z JEDEC, więc jest to zamiennik typu drop-in dla standardowej pamięci HBM2. Samsung podał, że testuje HBM2-PIM z nienazwanym dostawcą CPU, do wykorzystania w swoich przyszłych produktach. Biorąc pod uwagę bliskie w ostatnim czasie relacje z AMD, spodziewałbym się, że mowa właśnie o tym dostawcy. Sama technologia Samsung PIM nadaje się do centrów danych, głównie dlatego, że może odciążyć CPU przejmując te zadania AI, któe nie wymagają intensywnych obliczeń, takich jak rozpoznawanie mowy.

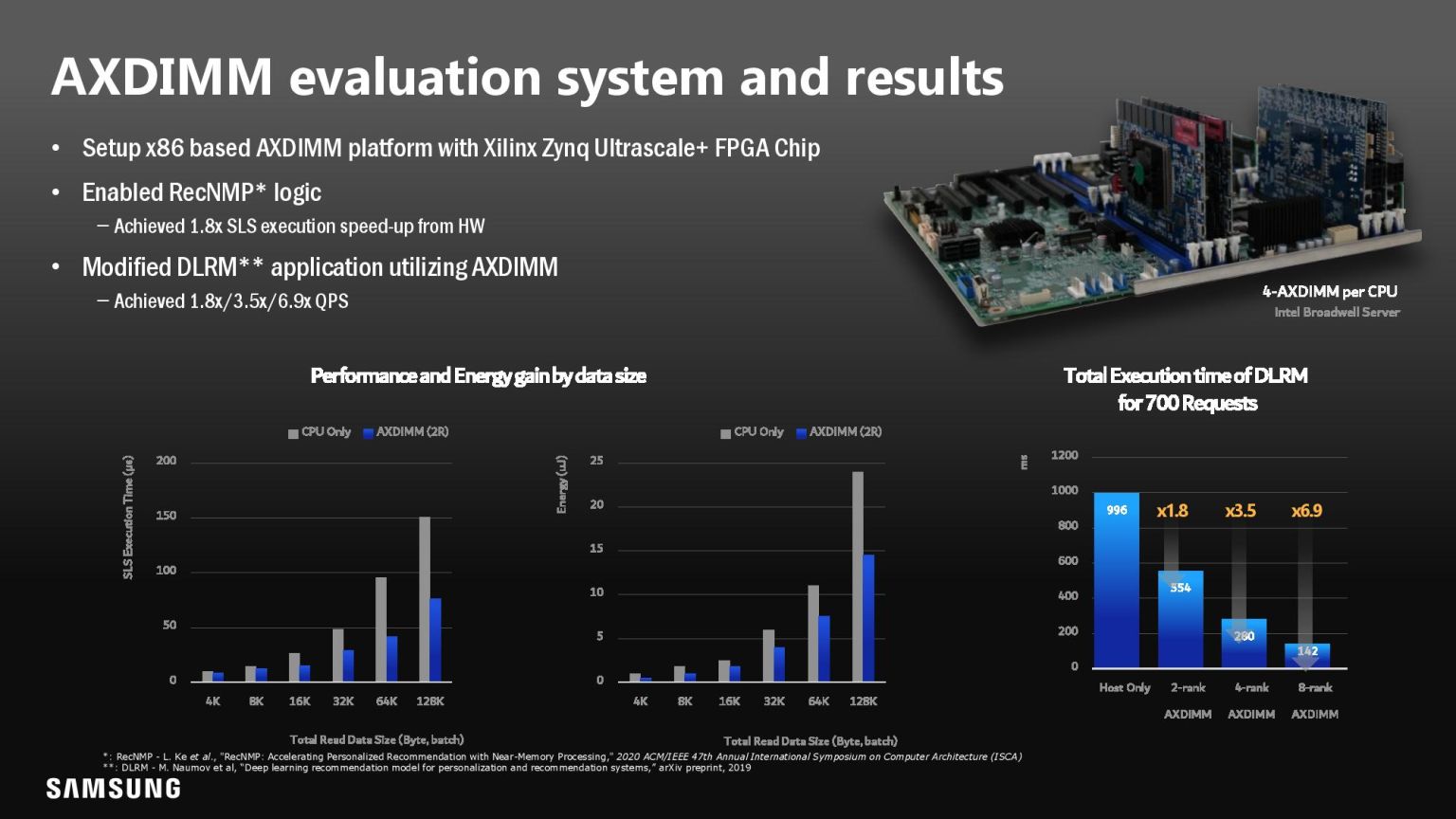

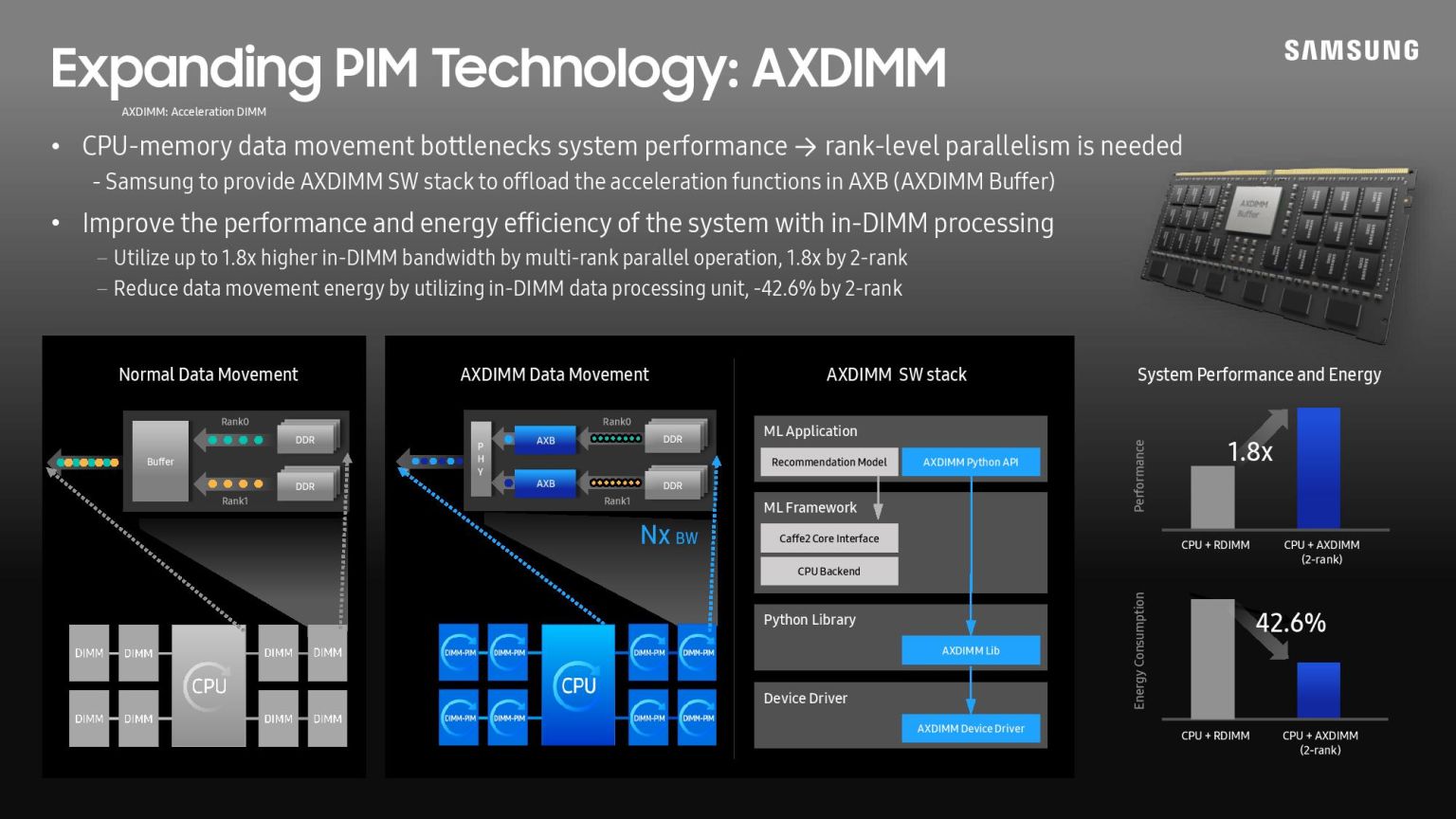

Samsung chce jednak wprowadzić podobny mechanizm do pamięci RAM. W tym celu firma zaprezentowała również AXDIMM, nowy prototyp akceleracji DIMM, który wykonuje przetwarzanie w układzie buforowym. Podobnie jak w przypadku układu HBM2-PIM, może wykonywać przetwarzanie FP16 przy użyciu standardowego kodu TensorFlow i Pythona, chociaż Samsung gorączkowo pracuje nad rozszerzeniem wsparcia na inne typy oprogramowania. Samsung twierdzi, że ten typ DIMM może trafić do dowolnego serwera wyposażonego w DDR4 z modułami LRDIMM lub UDIMMS. Docelowo, oczywiście, trafi także do serwerowych DDR5.

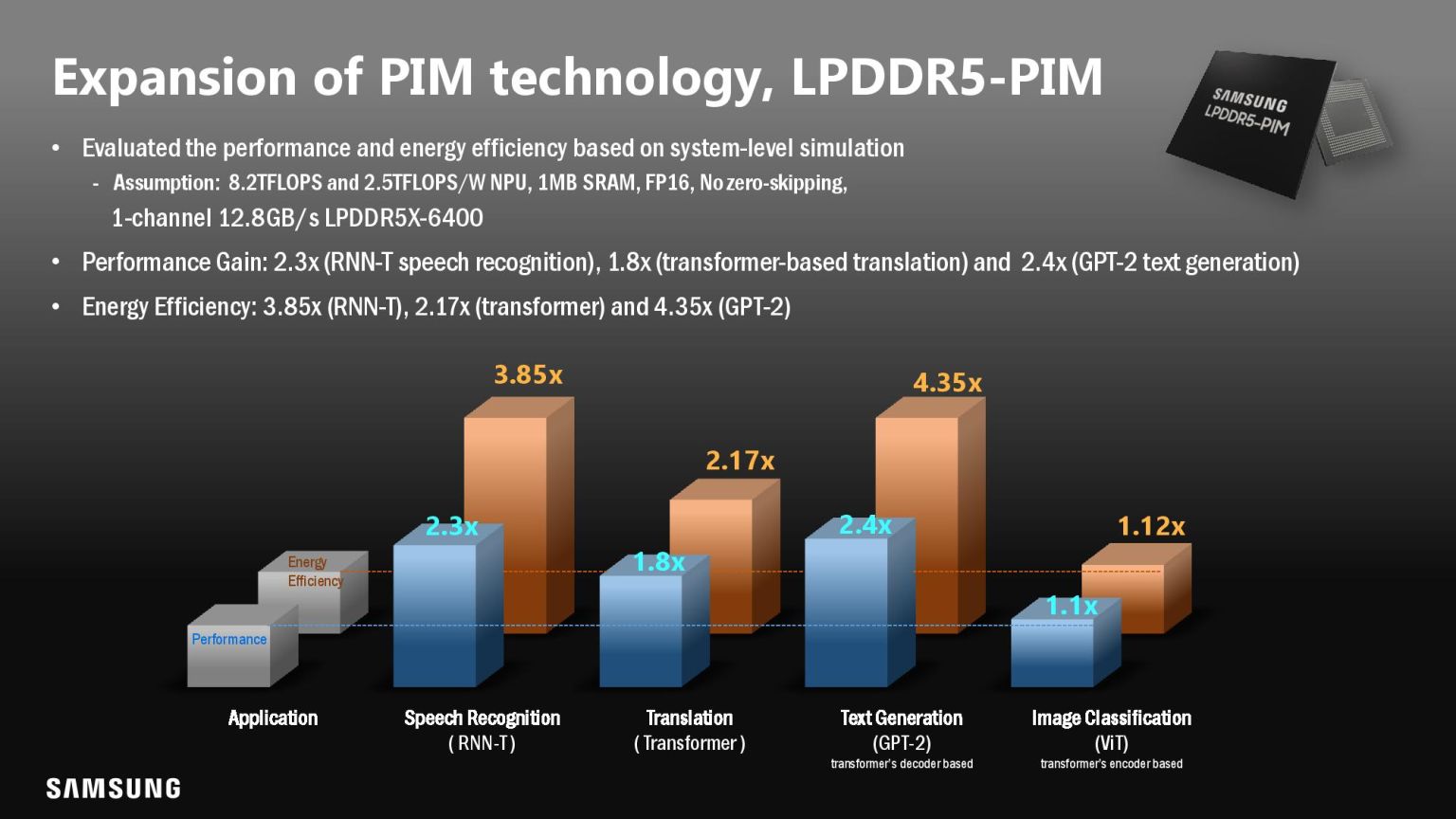

Firma twierdzi, że jej testy (przeprowadzone na AI Facebooka) wykazały 1,8-krotny wzrost wydajności, 42,6% zmniejszenie zużycia energii i 70% zmniejszenie opóźnienia. Technologię PIM firmy Samsung można przenieść na dowolny proces lub rodzaj pamięci, więc firma zaczęła nawet eksperymentować z pamięcią PIM w układach LPDDR5, co oznacza, że technologia ta może w przyszłości trafić do laptopów, tabletów, a nawet telefonów komórkowych.

RECENZJA: OnePlus Nord 2 5G – co potrafi najnowszy OnePlus z procesorem MediaTek Dimensity 1200-AI.