Samsung planuje wzmocnić swoją pozycję na rynku pamięci HBM

Sztuczna inteligencja staje się coraz bardziej popularnym trendem. Warto jednak pamiętać, że oznacza to globalny wzrost zapotrzebowania na pamięć HBM. Te szybkie moduły zapewniają odpowiednie możliwości dla serwerów wykonujących obliczenia na potrzeby AI. Dlatego też Samsung chce zwiększyć swoje możliwości w obszarze tych właśnie pamięci.

Według informacji z koreańskich mediów, Samsung Electronics planuje utworzyć biuro rozwoju pamięci HBM, aby wzmocnić swoją konkurencyjność na rynku HBM. Rozmiar zespołu nie został jeszcze ustalony. Jeśli grupa zadaniowa zostanie podniesiona do rangi biura rozwoju, Samsung utworzy specjalistyczne zespoły projektowe i rozwojowe do pracy nad pamięciami HBM. Wyścig jest w tym przypadku intensywny i “łeb w łeb”. Pod względem postępu w badaniach i rozwoju, trzej główni producenci osiągnęli już etap HBM3e.

Co do Samsunga, w lutym firma wypuściła swój pierwszy produkt HBM3e 12H DRAM o pojemności 36 GB, będący obecnie największym produktem HBM Samsunga. Obecnie Samsung dostarcza próbki HBM3e 12H klientom, a masowa produkcja ma ruszyć w drugiej połowie tego roku.

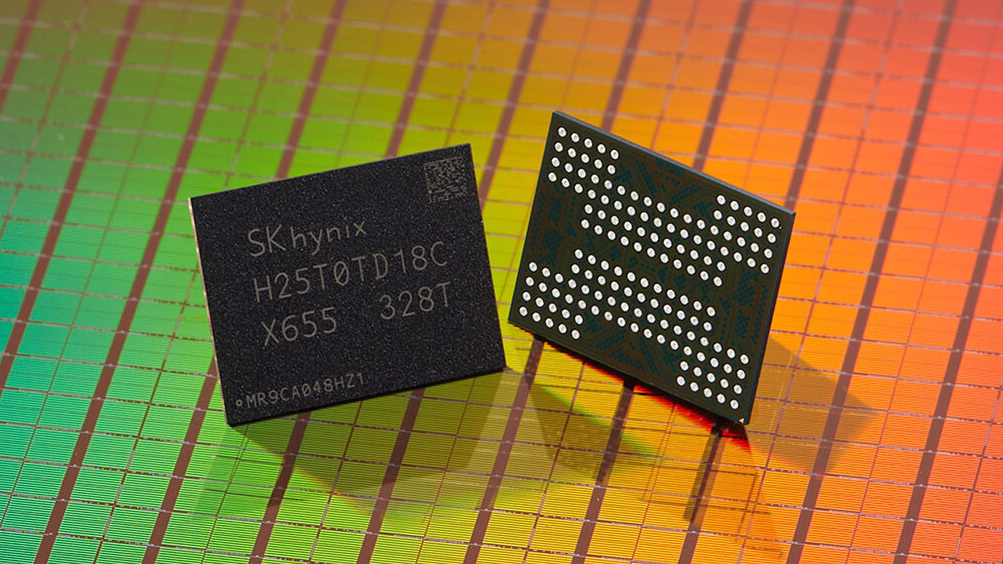

Z kolei Micron Technology ogłosił rozpoczęcie masowej produkcji pamięci o wysokiej częstotliwości “HBM3e”, która będzie wykorzystywana w najnowszym układzie AI od NVIDII, jednostce przetwarzania grafiki Tensor Core “H200”. Wysyłka H200 jest planowana na drugi kwartał 2024 roku. Inny ważny gracz, SK Hynix, zgodnie z informacjami od Business Korea, planuje rozpocząć masową produkcję HBM3e w pierwszej połowie 2024 roku.

Globalna pojemność pamięci HBM ma się podwoić w porównaniu do ubiegłego roku. Z perspektywy popytu przewiduje się, że ponad 60% przyszłego zapotrzebowania na HBM będzie wynikać z głównego zastosowania serwerów AI.