Snowflake wprowadza na rynek Arctic – najnowocześniejszy, duży model językowy (LLM), zaprojektowany, aby był najbardziej otwartym LLM-em klasy korporacyjnej na rynku

Snowflake, firma oferująca Chmurę Danych, ogłosiła uruchomienie Snowflake Arctic, najnowocześniejszego dużego modelu językowego (LLM), zaprojektowanego tak, aby był najbardziej otwartym LLM-em klasy korporacyjnej na rynku. Dzięki unikalnej architekturze Mixture-of-Experts (MoE), Arctic zapewnia najwyższej klasy inteligencję i niezrównaną wydajność na dużą skalę.

Snowflake Arctic jest zoptymalizowany pod kątem złożonych obciążeń korporacyjnych, osiągając najlepsze wyniki w kilku branżowych testach porównawczych w zakresie generowania kodu SQL, realizowania instrukcji i nie tylko. Snowflake udostępnia ponadto wagi Arctic na licencji Apache 2.0 oraz szczegóły badań prowadzących do wyszkolenia modelu, ustanawiając nowy standard otwartości technologii sztucznej inteligencji dla przedsiębiorstw. Snowflake Arctic LLM jest częścią Snowflake Arctic, rodziny modeli zbudowanych przez Snowflake, które obejmują również najlepszy praktyczny model osadzania tekstu dla przypadków użycia obejmujących wyszukiwanie treści.

– To dla Snowflake przełomowy moment, w którym nasz zespół badawczy ds. AI wprowadza innowacje będące w technologicznej czołówce – mówi Sridhar Ramaswamy, CEO Snowflake. – Dostarczając wiodącą w branży inteligencję i wydajność w prawdziwie otwarty dla społeczności sposób, poszerzamy granice tego, co może zrobić AI open source. Badania związane z Arctic znacznie zwiększą nasze możliwości w obszarze dostarczania niezawodnej i wydajnej sztucznej inteligencji naszym klientom.

Arctic przełamuje bariery dzięki prawdziwie otwartej, szeroko dostępnej współpracy

Według niedawnego raportu firmy Forrester, około 46 proc. globalnych decydentów zajmujących się sztuczną inteligencją w przedsiębiorstwach zauważyło, że wykorzystują istniejące otwarte oprogramowanie LLM do przyjęcia generatywnej sztucznej inteligencji jako części strategii AI w swojej organizacji. Dzięki Snowflake jako fundamentowi danych dla ponad 9,4 tys. firm i organizacji na całym świecie użytkownicy Chmury Danych mogą przetwarzać je, korzystając z wiodących w branży otwartych modeli LLM, przy jednoczesnym zachowaniu elastyczności i dostępu do modeli, z którymi już pracują.

Teraz, wraz z uruchomieniem Arctic, Snowflake dostarcza potężny, prawdziwie otwarty model na licencji Apache 2.0, która zezwala na nieograniczone użytkowanie osobiste, badawcze i komercyjne. Idąc o krok dalej, Snowflake zapewnia również szablony kodu, a także elastyczne opcje wnioskowania i szkolenia, dzięki czemu użytkownicy mogą szybko rozpocząć wdrażanie i dostosowywanie Arctic przy użyciu preferowanych przez siebie frameworków. Obejmują one NVIDIA NIM z NVIDIA TensorRT-LLM, vLLM i Hugging Face. Arctic jest też od ręki dostępny do bezserwerowego wnioskowania w Snowflake Cortex, w pełni zarządzanej usłudze Snowflake, która oferuje rozwiązania uczenia maszynowego i sztucznej inteligencji w Chmurze Danych. Rozwiązanie będzie również dostępne w ramach Amazon Web Services (AWS), wraz z innymi rodzinami modeli i katalogami, które będą obejmować Hugging Face, Lamini, Microsoft Azure, katalog API NVIDIA, Perplexity, Together AI i inne.

Arctic zapewnia najwyższą inteligencję z wiodącą wydajnością zasobów

Stworzenie Arctic zajęło zespołowi badawczemu Snowflake ds. AI, w którego skład wchodzą najlepsi w branży badacze i inżynierowie systemów, mniej niż trzy miesiące przy poniesieniu zaledwie około jednej ósmej kosztów szkolenia podobnych modeli. Wyszkolony przy użyciu instancji Amazon Elastic Compute Cloud (Amazon EC2) P5, model Snowflake wyznacza nowy punkt odniesienia dla szybkości szkolenia najnowocześniejszych otwartych modeli klasy korporacyjnej, ostatecznie umożliwiając użytkownikom tworzenie opłacalnych niestandardowych modeli na dużą skalę.

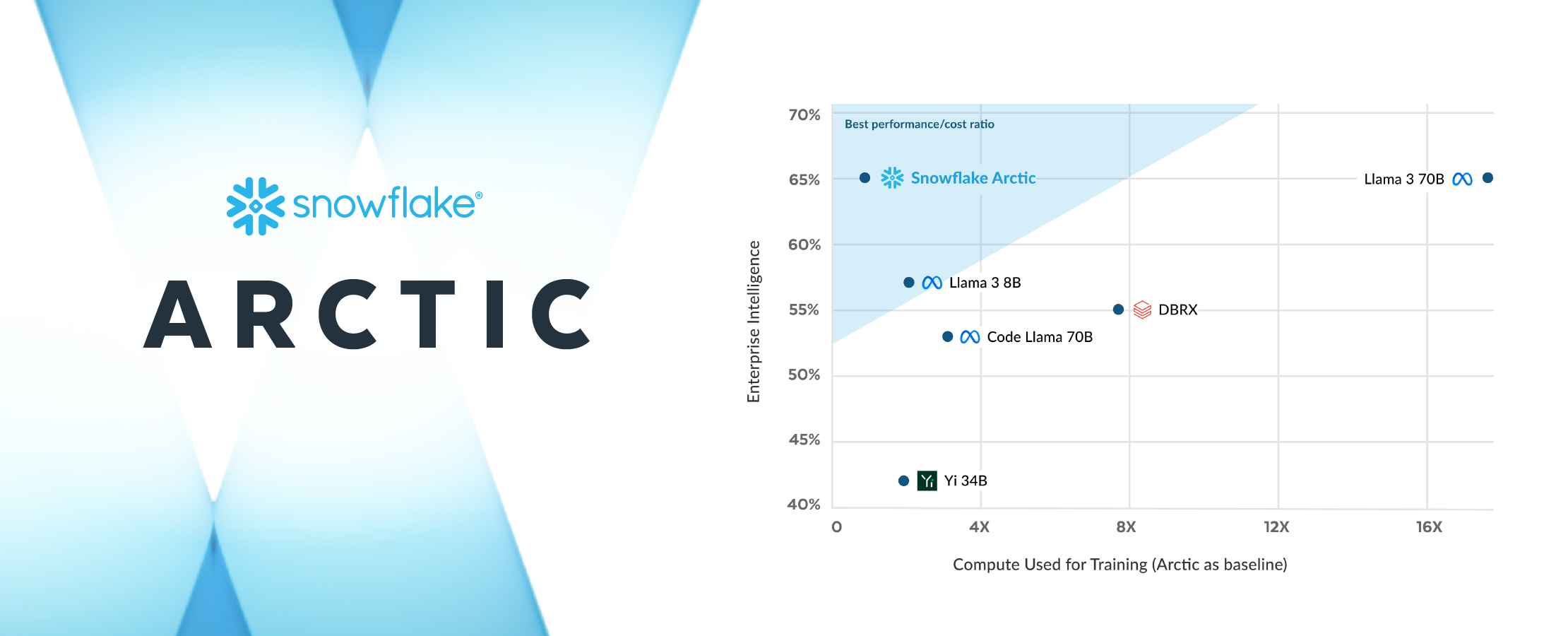

W ramach tych strategicznych prac zróżnicowany projekt MoE Arctic poprawia zarówno systemy szkoleniowe, jak i wydajność modeli, dzięki skrupulatnie zaprojektowanej kompozycji danych skoncentrowanej na potrzebach przedsiębiorstwa. Arctic zapewnia również wysokiej jakości wyniki, aktywując 17 z 480 miliardów parametrów jednocześnie, osiągając wiodącą w branży jakość przy niespotykanej dotąd wydajności tokenów. W ramach przełomu wydajnościowego Arctic aktywuje około 50 proc. mniej parametrów niż DBRX i 75 proc. mniej niż Llama 3 70B podczas wnioskowania lub szkolenia. Ponadto, przewyższa on inne otwarte modele, w tym DBRX, Mixtral-8x7B i inne w kodowaniu (HumanEval+, MBPP+) i generowaniu SQL (Spider i Bird-SQL), zapewniając jednocześnie wysoką wydajność w ogólnym rozumieniu języka (MMLU).

Snowflake kontynuuje ścieżkę przyspieszania innowacji AI dla wszystkich użytkowników

Snowflake zapewnia przedsiębiorstwom fundament danych i najnowocześniejsze bloki konstrukcyjne AI, których potrzebują do tworzenia potężnych aplikacji AI i uczenia maszynowego z wykorzystaniem danych przedsiębiorstwa. Po pojawieniu się w Snowflake Cortex Arctic przyspieszy zdolność klientów do tworzenia aplikacji AI klasy produkcyjnej na wielką skalę, a wszystko to w granicach bezpieczeństwa i zarządzania oferowanych przez Chmurę Danych Snowflake.

Oprócz Arctic LLM rodzina modeli Snowflake Arctic obejmuje również niedawno ogłoszoną Arctic embed, rodzinę najnowocześniejszych modeli osadzania tekstu dostępnych także dla społeczności open source na licencji Apache 2.0. Rodzina pięciu modeli jest już dostępna w ramach Hugging Face do natychmiastowego użytku, a wkrótce będzie dostępna jako część funkcji osadzania w Snowflake Cortex (private preview). Te modele są zoptymalizowane pod kątem zapewnienia wiodącej wydajności wyszukiwania przy około jednej trzeciej rozmiaru porównywalnych modeli, dając organizacjom potężne i opłacalne rozwiązanie przydatne w łączeniu zastrzeżonych zbiorów danych z LLM w ramach usługi Retrieval Augmented Generation lub wyszukiwania semantycznego.

Snowflake traktuje również priorytetowo zapewnienie klientom dostępu do najnowszych i największych modeli LLM w Chmurze Danych, w tym niedawno dodanych modeli Reka i Mistral AI. Co więcej, firma niedawno ogłosiła rozszerzenie partnerstwa z NVIDIA w celu kontynuowania innowacji w zakresie sztucznej inteligencji, łącząc w pełni akcelerowaną platformę NVIDIA z Chmurą Danych Snowflake, aby zapewnić bezpieczne i dostępne na szeroką skalę połączenie infrastruktury i możliwości obliczeniowych w celu odblokowania wydajności sztucznej inteligencji. Snowflake Ventures zainwestował niedawno m.in. w Landing AI, Mistral AI czy Reka, aby zwiększyć możliwości Snowflake, jeśli chodzi o wsparcie klientów w tworzeniu wartości z danych przedsiębiorstwa za pomocą technologii LLM i AI.