SocAI? Chiny sprawdzają modele genAI pod kątem wartości socjalistycznych

Podobno firmy zajmujące się sztuczną inteligencją w Chinach przechodzą rządowy przegląd swoich dużych modeli językowych, którego celem jest zapewnienie, że „ucieleśniają podstawowe wartości socjalistyczne”.

Jak podaje „Financial Times”, przegląd przeprowadza Chińska Administracja Cyberprzestrzeni (CAC), główny rządowy organ regulacyjny ds. internetu, i obejmie graczy z całego spektrum, od gigantów technologicznych, takich jak ByteDance i Alibaba, po małe start-upy.

Modele sztucznej inteligencji zostaną przetestowane przez lokalnych urzędników CAC pod kątem odpowiedzi na różne pytania, z których wiele dotyczy tematów drażliwych politycznie, oraz przez prezydenta Chin Xi Jinpinga, powiedział FT. Przeanalizowane zostaną również dane szkoleniowe modelu i procesy bezpieczeństwa.

Anonimowe źródło z firmy zajmującej się sztuczną inteligencją z siedzibą w Hangzhou, które rozmawiało z FT, powiedziało, że ich model z niejasnych powodów nie przeszedł pierwszej rundy testów. Zdali egzamin dopiero za drugim razem, po miesiącach „zgadywania i dostosowywania” – napisali w raporcie.

Najnowsze wysiłki CAC ilustrują, jak Pekin balansował na granicy między dogonieniem Stanów Zjednoczonych w zakresie GenAI, a jednocześnie uważnie obserwował rozwój tej technologii, zapewniając zgodność treści generowanych przez sztuczną inteligencję ze rygorystycznymi zasadami cenzury Internetu.

Kraj ten był jednym z pierwszych, który w zeszłym roku sfinalizował przepisy regulujące generatywną sztuczną inteligencję, w tym wymóg, aby usługi AI były zgodne z „podstawowymi wartościami socjalizmu” i nie generowały „nielegalnych” treści. Spełnianie zasad cenzury wymaga „filtrowania zabezpieczeń” i zostało skomplikowane, ponieważ chińskie firmy LLM są nadal szkolone w zakresie znacznej ilości treści w języku angielskim, powiedziało FT wielu inżynierów i znawców branży.

Według raportu filtrowanie odbywa się poprzez usuwanie „problematycznych informacji” z danych szkoleniowych modelu AI, a następnie tworzenie bazy danych zawierającej wrażliwe słowa i wyrażenia. Według doniesień przepisy sprawiają, że najpopularniejsze chatboty w kraju często odmawiają odpowiedzi na pytania dotyczące drażliwych tematów, takich jak protesty na placu Tiananmen w 1989 roku.

Jednakże podczas testów CAC istnieją ograniczenia co do liczby pytań, na które osoby LLM mogą od razu odrzucić, dlatego modele muszą być w stanie generować „poprawne politycznie odpowiedzi” na wrażliwe pytania. Ekspert AI pracujący nad chatbotem w Chinach powiedział FT, że trudno jest uniemożliwić LLM generowanie wszystkich potencjalnie szkodliwych treści, dlatego zamiast tego budują dodatkową warstwę w systemie, która zastępuje problematyczne odpowiedzi w czasie rzeczywistym.

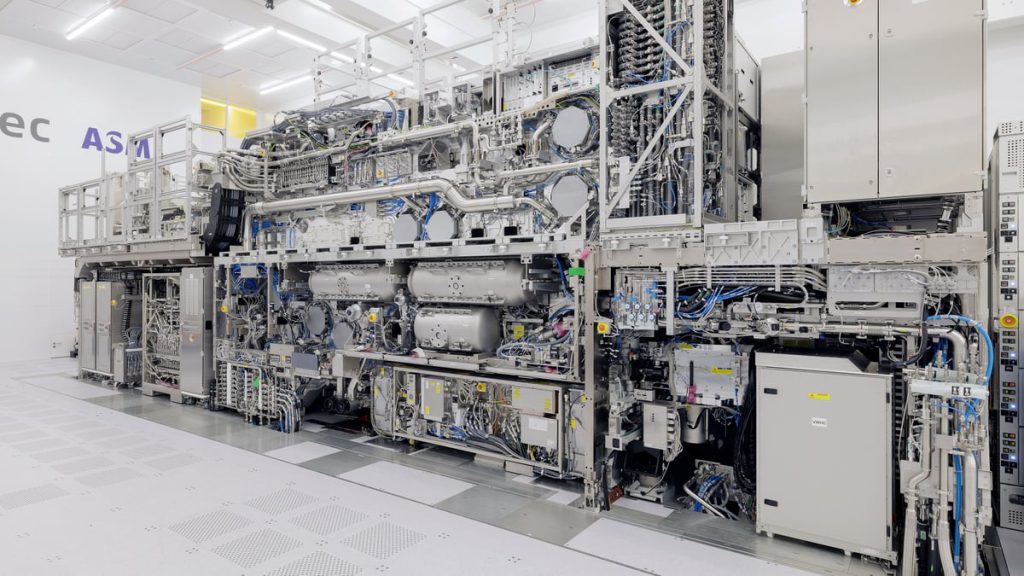

Przepisy, a także amerykańskie sankcje ograniczające dostęp do chipów używanych do szkolenia LLM utrudniają chińskim firmom uruchomienie własnych usług podobnych do ChatGPT. Chiny dominują jednak w światowym wyścigu patentów na generatywną sztuczną inteligencję.