TrendForce: SK hynix przewodzi rynkowi dzięki produktom HBM3e 16hi, zwiększając limity pojemności

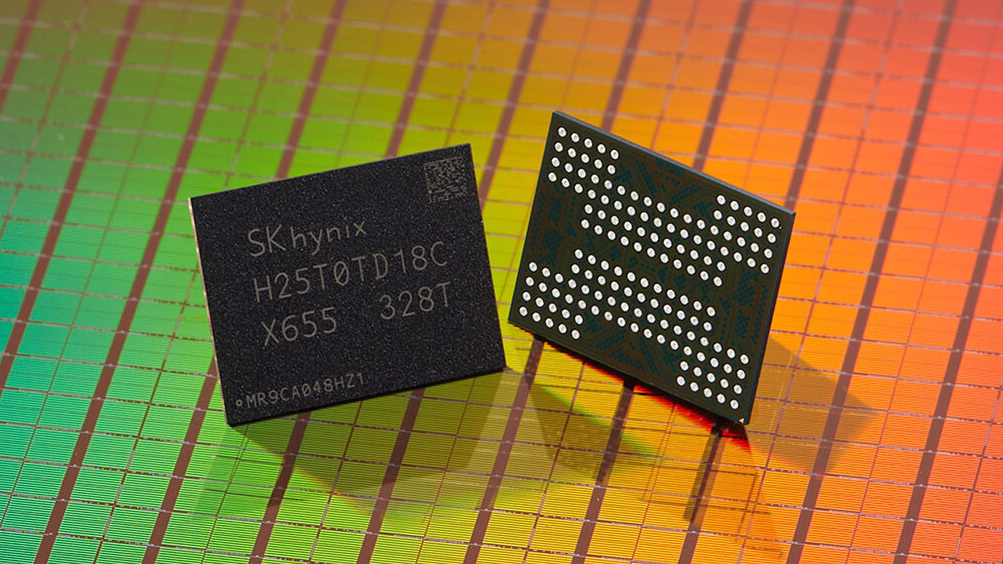

SK hynix niedawno zaprezentował pamięć HBM3e 16hi na SK AI Summit 2024, charakteryzującą się pojemnością 48 GB na kostkę. Próbki zostaną rozesłane w pierwszej połowie 2025 roku.

Najnowsze ustalenia TrendForce pokazują, że ten nowy produkt jest skierowany do aplikacji, które obejmują niestandardowe układy ASIC CSP i uniwersalne procesory graficzne. Oczekuje się, że produkt 16hi HBM3e zwiększy limity pojemności pamięci przed wprowadzeniem generacji HBM4.

TrendForce informuje, że dostawcy HBM tradycyjnie wprowadzają dwie opcje wysokości stosu — takie jak stosy 8hi i 12hi dla HBM3e oraz stosy 12hi i 16hi planowane dla HBM4 — w każdej generacji. Podczas gdy gracze branżowi są gotowi wprowadzić HBM4 12hi począwszy od drugiej połowy 2025 r., ruch SK hynix, aby dodać opcję 16hi w rodzinie HBM3e, można przypisać kilku kluczowym czynnikom.

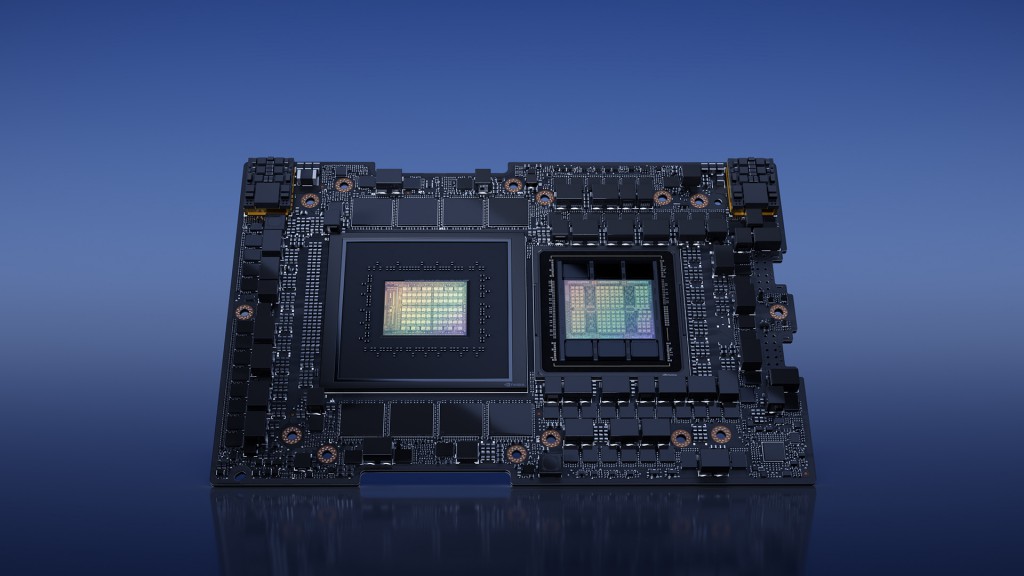

Po pierwsze, oczekuje się, że technologia pakowania CoWoS-L firmy TSMC będzie obsługiwać większe rozmiary opakowań w latach 2026–2027, co umożliwi więcej stosów HBM na SiP. Jednak nadal istnieją wyzwania i niepewności związane z postępem poza tymi planowanymi ulepszeniami. Przed bardziej wymagającą produkcją HBM4 16hi, HBM3e 16hi zapewnia klientom alternatywę o dużej pojemności. Dzięki maksymalnie ośmiu stosom HBM na SiP, HBM3e 16hi może zapewnić maksymalną pojemność 384 GB na system, znacznie przewyższając Rubin firmy NVIDIA o pojemności 288 GB.

Przejście z HBM3e na HBM4 podwaja również liczbę wejść/wyjść. Zwiększa to przepustowość obliczeniową przy jednoczesnym zwiększeniu rozmiaru matrycy, ale pojemność na matrycę pozostaje na poziomie 24 GB. W przypadku uaktualnienia z HBM3e 12hi do HBM4 12hi, HBM3e 16hi może służyć jako opcja oferująca niższe I/O, mniejsze rozmiary matryc i większą pojemność pamięci.

TrendForce dodaje, że HBM3e 16hi firmy SK hynix przyjmie proces układania Advanced MR-MUF. W porównaniu z procesem TC-NCF, MR-MUF umożliwia większą liczbę stosów i większą przepustowość obliczeniową. Produkując HBM3e 16hi przed wersjami HBM4 16hi, SK hynix będzie w stanie zgromadzić cenne doświadczenie w produkcji high-stack, które ułatwi płynniejsze przejście do produkcji HBM4 16hi.

SK hynix rozważa również przyszłą wersję wariantu 16hi wykorzystującą hybrydowe łączenie, co jeszcze bardziej rozszerzy opcje dużej przepustowości dla zaawansowanych aplikacji obliczeniowych.